Weder eine Enzyklopädie noch Google sind in der Lage, Fragen zu beantworten, die so einfach erscheinen wie diese: Wer hat den ersten Computer erfunden? Wenn wir anfangen, tiefer zu graben, finden wir bald viele verschiedene Antworten, und die meisten von ihnen sind richtig. Die Suche nach einer Antwort lädt uns ein, die Geschichte des Rechnens zu überprüfen, seine Pioniere zu treffen und zu entdecken, dass es immer noch nicht ganz klar ist, was ein Computer ist.

Charles Babbage und der mechanische Computer

Vor Babbage waren Computer Menschen. Dies war der Name für Menschen, die sich auf numerische Berechnungen spezialisierten – diejenigen, die viele Stunden damit verbrachten, arithmetische Operationen durchzuführen, die Prozesse immer wieder zu wiederholen und die Ergebnisse ihrer Berechnungen in Tabellen zu hinterlassen, die in wertvollen Büchern zusammengestellt wurden. Diese Tabellen erleichterten anderen Spezialisten das Leben, deren Aufgabe es war, diese Ergebnisse für alle möglichen Aufgaben zu verwenden: von den Artillerieoffizieren, die entschieden, wie man die Kanonen richtet, zu den Steuereintreibern, die Steuern berechneten, zu den Wissenschaftlern, die die Gezeiten oder die Bewegung der Sterne am Himmel vorhersagten.

So beauftragte Napoleon Ende des 17.Jahrhunderts Gaspard de Prony (22. Juli 1755 – 29. Juli 1839) mit der revolutionären Aufgabe, die präzisesten logarithmischen und trigonometrischen Tabellen (mit 14 bis 29 Dezimalstellen) herzustellen, die jemals hergestellt wurden, um die astronomischen Berechnungen des Pariser Observatoriums zu verfeinern und zu erleichtern und alle Messungen der französischen Verwaltung vereinheitlichen zu können. Für diese kolossale Aufgabe hatte de Prony die brillante Idee, die komplexesten Berechnungen in einfachere mathematische Operationen aufzuteilen, die von weniger qualifizierten menschlichen Computern ausgeführt werden konnten. Diese Art, die Arbeit zu beschleunigen und Fehler zu vermeiden, war eines der Dinge, die den englischen Universalgelehrten Charles Babbage (26. Dezember 1791 – 18. Oktober 1871) dazu inspirierten, den nächsten Schritt zu tun: menschliche Computer durch Maschinen zu ersetzen.

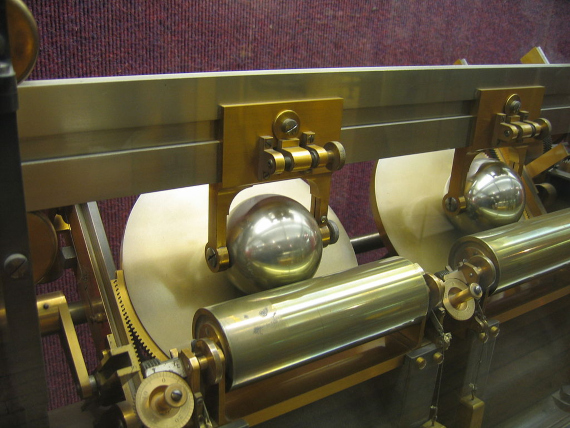

Babbage wird von vielen wegen dieser Vision, die durch seine Bemühungen nie wirklich wahr wurde, als der Vater des Rechnens angesehen. Sein erster Versuch war die Differenzmaschine, die er 1822 nach dem Prinzip der endlichen Differenzen zu bauen begann, um komplexe mathematische Berechnungen mittels einer einfachen Reihe von Additionen und Subtraktionen durchzuführen und Multiplikationen und Divisionen zu vermeiden. Er schuf sogar einen kleinen Taschenrechner, der bewies, dass seine Methode funktionierte, aber er war nicht in der Lage, eine Differentialmaschine zu bauen, um diese begehrten logarithmischen und trigonometrischen Tabellen mit genauen Daten zu füllen. Lady Byron, Ada Lovelaces Mutter, behauptete, 1833 einen funktionalen Prototyp gesehen zu haben — wenn auch in Komplexität und Präzision begrenzt -, aber zu diesem Zeitpunkt hatte Babbage die von der britischen Regierung bereitgestellten Mittel bereits ausgeschöpft.

Weit davon entfernt, von diesem Rückschlag entmutigt zu sein, verdoppelte sich der Mathematiker, Philosoph, Ingenieur und Erfinder Charles Babbage. Er konzentrierte seine ganze Energie auf die Entwicklung der Analytical Engine, die viel ehrgeiziger war, da sie in der Lage war, noch komplexere Berechnungen durch Berechnung von Multiplikationen und Divisionen durchzuführen. Wieder einmal kam Babbage nie über die Designphase hinaus, aber es waren diese Entwürfe, die er 1837 begann, die ihn vielleicht nicht zum Vater des Rechnens machten, aber definitiv zu einem Propheten dessen, was kommen sollte.

Babbages Tausende von Seiten mit Anmerkungen und Skizzen zur Analytical Engine enthielten Komponenten und Prozesse, die jedem modernen Computer gemeinsam sind: eine logische Einheit zur Durchführung arithmetischer Berechnungen (das Äquivalent eines Prozessors oder einer CPU), eine Steuerstruktur mit Anweisungen, Schleifen und bedingter Verzweigung (wie eine Programmiersprache) und Datenspeicherung auf Lochkarten (eine frühe Version des Speichers), eine Idee, die er von der Jacquard-Maschine entlehnt hat. Babbage dachte sogar daran, die Ergebnisse der Berechnungen mit einem Ausgabegerät, das ein Vorläufer der heutigen Drucker war, auf Papier aufzuzeichnen.

Die Thomson-Brüder und analoge Computer

1872, ein Jahr nach dem Tod von Charles Babbage, erfand der große Physiker William Thomson (Lord Kelvin) eine Maschine, die komplexe Berechnungen durchführen und die Gezeiten an einem bestimmten Ort vorhersagen konnte. Es gilt als der erste analoge Computer und teilt sich die Zeit mit dem Differentialanalysator, der 1876 von seinem Bruder James Thomson gebaut wurde. Das letztere Gerät war eine fortgeschrittenere und vollständigere Version, die es schaffte, Differentialgleichungen durch Integration unter Verwendung von Rad- und Scheibenmechanismen zu lösen.

Es dauerte jedoch noch einige Jahrzehnte, bis H.L. Hazen und Vannevar Bush im 20.Jahrhundert die Idee des mechanischen Analogcomputers am MIT (Massachusetts Institute of Technology) perfektionierten. Zwischen 1928 und 1931 bauten sie einen Differentialanalysator, der wirklich praktisch war, da er zur Lösung verschiedener Probleme verwendet werden konnte und daher nach diesem Kriterium als erster Computer angesehen werden konnte.

Turing und die Universal Computing Machine

Zu diesem Zeitpunkt konnten diese analogen Maschinen bereits bei einigen Aufgaben menschliche Computer ersetzen und berechneten immer schneller, insbesondere als ihre Zahnräder durch elektronische Komponenten ersetzt wurden. Aber sie hatten immer noch einen gravierenden Nachteil. Sie wurden entwickelt, um eine Art von Berechnung durchzuführen, und wenn sie für eine andere verwendet werden sollten, mussten ihre Zahnräder oder Schaltkreise ersetzt werden.

Das war bis 1936 der Fall, als ein junger englischer Student, Alan Turing, an einen Computer dachte, der jedes Problem lösen würde, das in mathematische Begriffe übersetzt und dann auf eine Kette logischer Operationen mit Binärzahlen reduziert werden könnte, in denen nur zwei Entscheidungen getroffen werden konnten: wahr oder falsch. Die Idee war, alles (Zahlen, Buchstaben, Bilder, Töne) auf Einsen- und Nullenfolgen zu reduzieren und ein Rezept (ein Programm) zu verwenden, um die Probleme in sehr einfachen Schritten zu lösen. Der digitale Computer war geboren, aber im Moment war es nur eine imaginäre Maschine.

Babbages analytische Maschine hätte wahrscheinlich (fast ein Jahrhundert zuvor) die Bedingungen für eine universelle Turing-Maschine erfüllt … wenn sie jemals gebaut worden wäre. Am Ende des Zweiten Weltkriegs — in dem er half, den Enigma—Code der von den Nazis codierten Nachrichten zu entschlüsseln – schuf Turing einen der ersten Computer, der modernen Computern ähnelte, die automatische Rechenmaschine, die nicht nur digital, sondern auch programmierbar war. mit anderen Worten, es könnte für viele Dinge verwendet werden, indem einfach das Programm geändert wird.

Zuse und der Digitalcomputer

Obwohl Turing feststellte, wie ein Computer theoretisch aussehen sollte, war er nicht der erste, der ihn in die Praxis umsetzte. Diese Ehre geht an einen Ingenieur, der nur langsam Anerkennung fand, auch weil seine Arbeit mitten in einem globalen Krieg vom NS-Regime finanziert wurde. Am 12.Mai 1941 stellte Konrad Zuse in Berlin den Z3 fertig, den ersten voll funktionsfähigen (programmierbaren und automatischen) Digitalcomputer. So wie es später die Silicon Valley-Pioniere taten, baute Zuse den Z3 erfolgreich in seiner heimischen Werkstatt und schaffte dies ohne elektronische Komponenten, sondern mit Telefonrelais. Der erste digitale Computer war daher elektromechanisch und wurde nicht in eine elektronische Version umgewandelt, da die Bundesregierung eine Finanzierung ausschloss, da er in Kriegszeiten nicht als „strategisch wichtig“ angesehen wurde.

Auf der anderen Seite des Krieges legten die alliierten Mächte Wert auf den Bau elektronischer Computer mit Tausenden von Vakuumröhren. Der erste war der ABC (Atanasoff-Berry Computer), der 1942 in den USA von John Vincent Atanasoff und Clifford E. Berry entwickelt wurde, der jedoch weder programmierbar noch „Turing-vollständig“ war. In Großbritannien schufen zwei Kollegen von Alan Turing — Tommy Flowers und Max Newman, die ebenfalls im Bletchley Park an der Entschlüsselung von Nazi—Codes arbeiteten – den Colossus, den ersten elektronischen, digitalen und programmierbaren Computer. Aber Colossus fehlte wie ABC auch ein letztes Detail: Es war nicht „Turing-vollständig“.

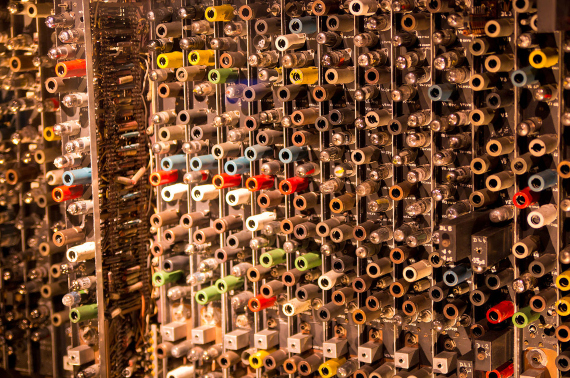

Der erste Computer, der Turing-vollständig war und die vier Grundfunktionen unserer heutigen Computer aufwies, war der ENIAC (Electronic Numerical Integrator and Computer), der heimlich von der US-Armee entwickelt und erstmals am 10. Dezember 1945 an der University of Pennsylvania eingesetzt wurde, um die Machbarkeit der Wasserstoffbombe zu untersuchen. Um andere Berechnungen durchzuführen, musste sein „Programm“ geändert werden, dh eine Vielzahl von Kabeln und Schaltern musste manuell neu positioniert werden. ENIAC, entworfen von John Mauchly und J. Presper Eckert hatte eine Fläche von 167 m2, wog 30 Tonnen, verbrauchte 150 Kilowatt Strom und enthielt rund 20.000 Vakuumröhren.

ENIAC wurde bald von anderen Computern übertroffen, die ihre Programme in elektronischen Speichern speicherten. Die Vakuumröhren wurden zuerst durch Transistoren und schließlich durch Mikrochips ersetzt, mit denen das Miniaturisierungsrennen der Computer begann. Aber diese riesige Maschine, die vom großen Gewinner des Zweiten Weltkriegs gebaut wurde, läutete unser digitales Zeitalter ein. Heute würde es einstimmig als der erste echte Computer der Geschichte gelten, wenn Konrad Zuse (1910-1995) nicht 1961 beschlossen hätte, seinen Z3, der 1943 durch einen Bombenanschlag zerstört worden war, zu rekonstruieren. Die Replik wurde im Deutschen Museum in München ausgestellt, wo sie sich heute befindet. Es vergingen mehrere Jahrzehnte, bis sich 1998 ein mexikanischer Informatiker, Raúl Rojas, bemühte, den Z3 eingehend zu untersuchen, und es gelang ihm zu beweisen, dass er „Turing-vollständig“ sein könnte, was nicht einmal sein damals verstorbener Schöpfer in Betracht gezogen hatte.

Konzentriert darauf, es zum Laufen zu bringen, war Zuse nie bewusst, dass er die erste universelle Rechenmaschine in seinen Händen hatte. Ist Charles Babbage, Konrad Zuse oder Alan Turing der Erfinder des Computers? War der Z3, Colossus oder ENIAC der erste moderne Computer? Es kommt darauf an. Die Frage bleibt heute so offen wie diese: Was macht eine Maschine zu einem Computer?