Ni une encyclopédie ni Google ne sont capables de répondre à des questions qui paraissent aussi simples que celle-ci : Qui a inventé le premier ordinateur? Si nous commençons à creuser plus profondément, nous trouvons bientôt de nombreuses réponses différentes, et la plupart d’entre elles sont correctes. Chercher une réponse nous invite à revoir l’histoire de l’informatique, à rencontrer ses pionniers et à découvrir qu’on ne sait pas encore tout à fait ce qu’est un ordinateur.

Charles Babbage et l’ordinateur mécanique

Avant Babbage, les ordinateurs étaient des humains. C’était le nom donné aux personnes spécialisées dans les calculs numériques — celles qui passaient de longues heures à effectuer des opérations arithmétiques, répétant les processus encore et encore et laissant les résultats de leurs calculs écrits dans des tableaux, qui étaient compilés dans des livres précieux. Ces tableaux ont rendu la vie beaucoup plus facile à d’autres spécialistes, dont le travail consistait à utiliser ces résultats pour effectuer toutes sortes de tâches: des officiers d’artillerie qui décidaient comment viser les canons, aux collecteurs d’impôts qui calculaient les impôts, aux scientifiques qui prédisaient les marées ou le mouvement des étoiles dans les cieux.

Ainsi, à la fin du XVIIe siècle, Napoléon chargea Gaspard de Prony (22 juillet 1755 – 29 juillet 1839) de la tâche révolutionnaire de produire les tables logarithmiques et trigonométriques les plus précises (avec entre 14 et 29 décimales) jamais réalisées, afin d’affiner et de faciliter les calculs astronomiques de l’Observatoire de Paris, et de pouvoir unifier toutes les mesures effectuées par l’administration française. Pour cette tâche colossale, de Prony eut la brillante idée de diviser les calculs les plus complexes en opérations mathématiques plus simples pouvant être effectuées par des ordinateurs humains moins qualifiés. Cette façon d’accélérer le travail et d’éviter les erreurs fut l’une des choses qui inspira le polymathe anglais Charles Babbage (26 décembre 1791 – 18 octobre 1871) à passer à l’étape suivante: remplacer les ordinateurs humains par des machines.

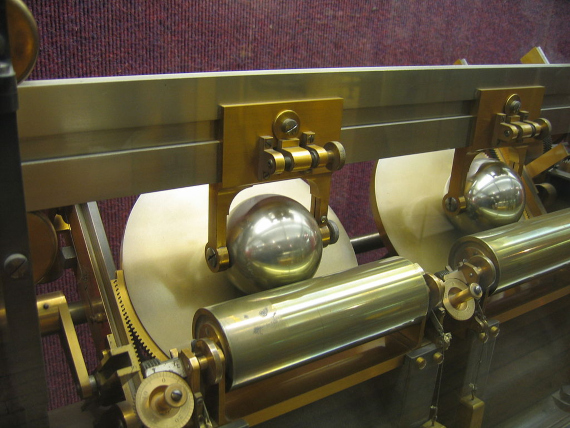

Babbage est considéré par beaucoup comme le père de l’informatique en raison de cette vision, qui ne s’est jamais vraiment réalisée grâce à ses efforts. Sa première tentative a été le Moteur de différence, qu’il a commencé à construire en 1822, basé sur le principe des différences finies, afin d’effectuer des calculs mathématiques complexes au moyen d’une simple série d’additions et de soustractions, en évitant les multiplications et les divisions. Il a même créé une petite calculatrice qui a prouvé que sa méthode fonctionnait, mais il n’a pas été en mesure de construire un moteur différentiel pour remplir ces tables logarithmiques et trigonométriques convoitées avec des données précises. Lady Byron, la mère d’Ada Lovelace, prétendait avoir vu un prototype fonctionnel en 1833 — bien que limité en complexité et en précision — mais à ce moment-là, Babbage avait déjà épuisé le financement fourni par le gouvernement britannique.

Loin d’être découragé par ce revers, le mathématicien, philosophe, ingénieur et inventeur Charles Babbage a doublé la mise. Il a concentré toutes ses énergies sur le développement du Moteur analytique, qui était beaucoup plus ambitieux car il serait capable d’effectuer des calculs encore plus complexes en calculant des multiplications et des divisions. Encore une fois, Babbage n’a jamais dépassé le stade de la conception, mais ce sont ces conceptions qu’il a commencées en 1837 qui ont fait de lui, peut-être pas le père de l’informatique, mais certainement un prophète de ce qui allait arriver.

Les milliers de pages d’annotations et de croquis de Babbage sur le moteur analytique contenaient des composants et des processus communs à tout ordinateur moderne: une unité logique pour effectuer des calculs arithmétiques (l’équivalent d’un processeur ou d’un processeur), une structure de contrôle avec des instructions, des boucles et des ramifications conditionnelles (comme un langage de programmation), et un stockage de données sur des cartes perforées (une première version de la mémoire), une idée qu’il a empruntée à la machine Jacquard. Babbage a même pensé à enregistrer les résultats des calculs sur papier, en utilisant un périphérique de sortie précurseur des imprimantes d’aujourd’hui.

Les frères Thomson et les ordinateurs analogiques

En 1872, un an après la mort de Charles Babbage, le grand physicien William Thomson (Lord Kelvin) inventa une machine capable d’effectuer des calculs complexes et de prédire les marées en un lieu donné. Il est considéré comme le premier ordinateur analogique, partageant les honneurs avec l’analyseur différentiel construit en 1876 par son frère James Thomson. Ce dernier appareil était une version plus avancée et complète, qui réussissait à résoudre des équations différentielles par intégration, en utilisant des mécanismes à roue et à disque.

Cependant, il a fallu plusieurs décennies de plus jusqu’à ce que, jusqu’au 20ème siècle, H.L. Hazen et Vannevar Bush perfectionnent l’idée de l’ordinateur analogique mécanique au MIT (Massachusetts Institute of Technology). Entre 1928 et 1931, ils ont construit un analyseur différentiel qui était vraiment pratique car il pouvait être utilisé pour résoudre différents problèmes, et en tant que tel, suivant ce critère, il pouvait être considéré comme le premier ordinateur.

Turing et la machine informatique universelle

À ce stade, ces machines analogiques pouvaient déjà remplacer les ordinateurs humains dans certaines tâches et calculaient de plus en plus vite, en particulier lorsque leurs engrenages ont commencé à être remplacés par des composants électroniques. Mais ils avaient encore un sérieux inconvénient. Ils ont été conçus pour effectuer un type de calcul et s’ils devaient être utilisés pour un autre, leurs engrenages ou circuits devaient être remplacés.

Ce fut le cas jusqu’en 1936, quand un jeune étudiant anglais, Alan Turing, pensa à un ordinateur qui résoudrait tout problème pouvant être traduit en termes mathématiques puis réduit à une chaîne d’opérations logiques avec des nombres binaires, dans lesquelles seules deux décisions pouvaient être prises: vrai ou faux. L’idée était de tout réduire (chiffres, lettres, images, sons) en chaînes de uns et de zéros et d’utiliser une recette (un programme) pour résoudre les problèmes en étapes très simples. L’ordinateur numérique était né, mais pour l’instant ce n’était qu’une machine imaginaire.

La machine analytique de Babbage aurait probablement rempli (près d’un siècle plus tôt) les conditions pour être une machine de Turing universelle if si elle avait jamais été construite. À la fin de la Seconde Guerre mondiale — au cours de laquelle il a aidé à déchiffrer le code Enigma des messages codés nazis — Turing a créé l’un des premiers ordinateurs similaires aux ordinateurs modernes, le Moteur de calcul automatique, qui en plus d’être numérique était programmable; en d’autres termes, il pouvait être utilisé pour beaucoup de choses en changeant simplement le programme.

Zuse et l’ordinateur numérique

Bien que Turing ait établi à quoi devrait ressembler un ordinateur en théorie, il n’a pas été le premier à le mettre en pratique. Cet honneur revient à un ingénieur qui a tardé à se faire reconnaître, en partie parce que son travail a été financé par le régime nazi en pleine guerre mondiale. Le 12 mai 1941, Konrad Zuse a achevé le Z3 à Berlin, qui était le premier ordinateur numérique entièrement fonctionnel (programmable et automatique). Tout comme les pionniers de la Silicon Valley le feraient plus tard, Zuse a construit avec succès le Z3 dans son atelier, réussissant à le faire sans composants électroniques, mais en utilisant des relais téléphoniques. Le premier ordinateur numérique était donc électromécanique, et il n’a pas été transformé en version électronique car le gouvernement allemand a exclu de le financer, car il n’était pas considéré comme « stratégiquement important » en temps de guerre.

De l’autre côté de la guerre, les puissances alliées attachaient de l’importance à la construction d’ordinateurs électroniques, utilisant des milliers de tubes à vide. Le premier était l’ABC (Atanasoff-Berry Computer), créé en 1942 aux États-Unis par John Vincent Atanasoff et Clifford E. Berry, qui n’était cependant ni programmable ni « Turing-complet ». Pendant ce temps, en Grande—Bretagne, deux des collègues d’Alan Turing — Tommy Flowers et Max Newman, qui ont également travaillé à Bletchley Park pour déchiffrer les codes nazis – ont créé le Colossus, le premier ordinateur électronique, numérique et programmable. Mais Colossus, comme ABC, manquait également d’un dernier détail: il n’était pas « Turing-complet ».

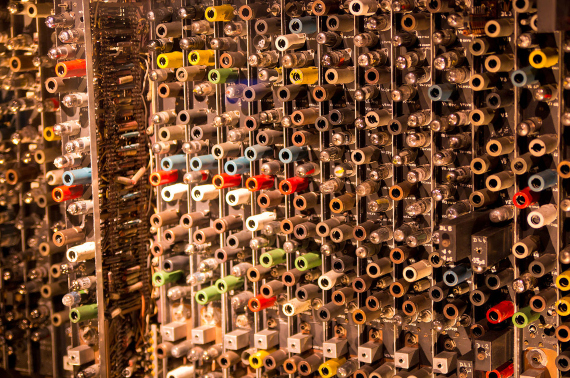

Le premier ordinateur qui était Turing-complet, et qui avait ces quatre caractéristiques de base de nos ordinateurs actuels était l’ENIAC (Electronic Numerical Integrator and Computer), développé secrètement par l’armée américaine et mis au travail pour la première fois à l’Université de Pennsylvanie le 10 décembre 1945 afin d’étudier la faisabilité de la bombe à hydrogène. Afin d’effectuer d’autres calculs, son « programme » a dû être modifié, c’est-à-dire qu’une multitude de câbles et d’interrupteurs devaient être repositionnés manuellement. ENIAC, conçu par John Mauchly et J. Presper Eckert, qui occupait 167 m2, pesait 30 tonnes, consommait 150 kilowatts d’électricité et contenait quelque 20 000 tubes à vide.

ENIAC a rapidement été dépassé par d’autres ordinateurs qui stockaient leurs programmes dans des mémoires électroniques. Les tubes à vide ont d’abord été remplacés par des transistors et finalement par des puces électroniques, avec lesquelles la course à la miniaturisation informatique a commencé. Mais cette machine géante, construite par le grand vainqueur de la Seconde Guerre mondiale, a lancé notre ère numérique. Aujourd’hui, il serait unanimement considéré comme le premier véritable ordinateur de l’histoire sans Konrad Zuse (1910-1995), qui décida en 1961 de reconstruire son Z3, détruit par un bombardement en 1943. La réplique a été exposée au Deutsches Museum de Munich, où elle se trouve aujourd’hui. Plusieurs décennies s’écouleront jusqu’à ce qu’en 1998, un informaticien mexicain, Raúl Rojas, s’efforce d’étudier le Z3 en profondeur et parvienne à prouver qu’il pourrait être « Turing-complet », ce que même son créateur décédé à l’époque n’avait pas envisagé.

Soucieux de le faire fonctionner, Zuse n’a jamais su qu’il avait entre les mains la première machine informatique universelle. En fait, il n’a jamais fait fonctionner son invention de cette façon Charles Alors, Charles Babbage, Konrad Zuse ou Alan Turing sont-ils l’inventeur de l’ordinateur? Le Z3, Colossus ou ENIAC était-il le premier ordinateur moderne? Ça dépend. La question reste aujourd’hui aussi ouverte que celle-ci : Qu’est-ce qui fait d’une machine un ordinateur ?