cele uczenia się

- zarys zasad warunkowania operanta.

- wyjaśnij, w jaki sposób można kształtować uczenie się za pomocą harmonogramów wzmacniania i wtórnych wzmacniaczy.

w klasycznej kondycji organizm uczy się kojarzyć nowe bodźce z naturalnymi reakcjami biologicznymi, takimi jak ślinienie czy strach. Organizm nie uczy się czegoś nowego, ale zaczyna wykonywać istniejące zachowanie w obecności nowego sygnału. Z drugiej strony uwarunkowanie operanta to uczenie się, które odbywa się w oparciu o konsekwencje zachowania i może obejmować uczenie się nowych działań. Uwarunkowanie operanta występuje, gdy pies przewraca się na komendę, ponieważ był chwalony za to w przeszłości, gdy szkolny łobuz grozi kolegom z klasy, ponieważ pozwala mu to na jego drogę, a gdy dziecko dostaje dobre oceny, ponieważ jej rodzice grożą, że ją ukarzą, jeśli tego nie zrobi. W operatywnej kondycji organizm uczy się na konsekwencjach własnych działań.

How Reinforcement and Punishment Influence Behaviour: the Research of Thorndike and Skinner

psycholog Edward L. Thorndike (1874-1949) był pierwszym naukowcem, który systematycznie badał uwarunkowania operanta. W swoich badaniach Thorndike (1898) zaobserwował koty, które zostały umieszczone w „pudełku puzzle”, z którego próbowały uciec („Video Clip: Thorndike 'S Puzzle Box”). Początkowo koty drapały się, gryzły i swatały przypadkowo, nie mając pojęcia, jak się wydostać. Ale w końcu, i przypadkowo, nacisnęli dźwignię, która otworzyła drzwi i wyszli do swojej nagrody, skrawka ryby. Następnym razem, gdy kot był ograniczony w pudełku, próbował mniej nieskutecznych odpowiedzi przed przeprowadzeniem udanej ucieczki, a po kilku próbach kot nauczył się prawie natychmiast wykonać prawidłową odpowiedź.

obserwowanie tych zmian w zachowaniu kotów doprowadziło Thorndike’ a do opracowania jego prawa skutku, zasady, że reakcje, które tworzą typowo przyjemny wynik w danej sytuacji, są bardziej prawdopodobne, że wystąpią ponownie w podobnej sytuacji, podczas gdy reakcje, które wywołują typowo nieprzyjemny wynik, są mniej prawdopodobne, aby wystąpić ponownie w tej sytuacji (Thorndike, 1911). Istotą prawa skutku jest to, że skuteczne odpowiedzi, ponieważ są przyjemne, są „odciskane” przez doświadczenie, a zatem występują częściej. Nieudane odpowiedzi, które wywołują nieprzyjemne doświadczenia, są „stemplowane”, a następnie występują rzadziej.

kiedy Thorndike umieścił swoje koty w pudełku z puzzlami, odkrył, że nauczyły się szybciej angażować w ważne zachowania ucieczki po każdej próbie. Thorndike opisał naukę, która następuje po wzmocnieniu w kategoriach prawa skutku.

oglądasz: „pudełko z puzzlami Thorndike” : http://www.youtube.com/watch?v=BDujDOLre-8

oglądasz: „pudełko z puzzlami Thorndike” : http://www.youtube.com/watch?v=BDujDOLre-8

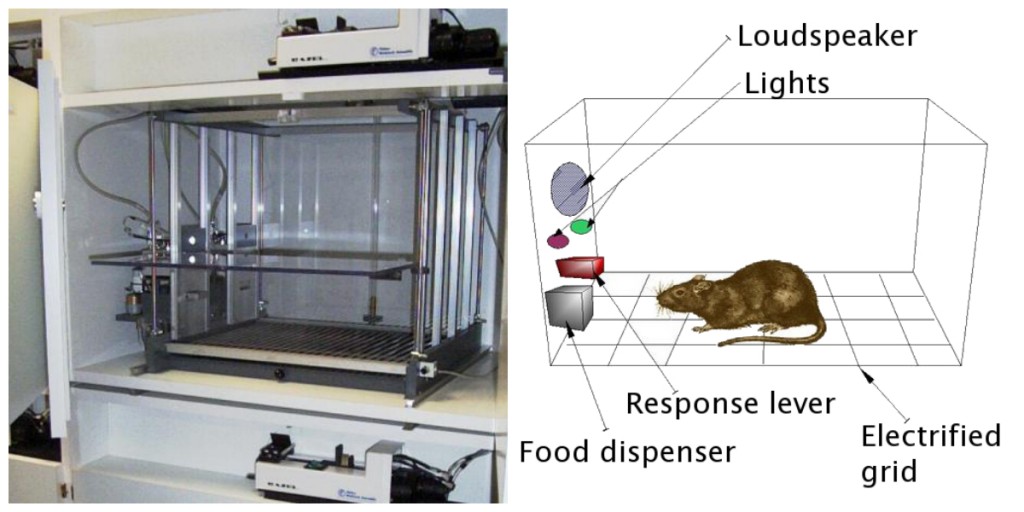

wpływowy psycholog behawioralny B. F. Skinner (1904-1990) rozwinął idee Thorndike ’ a, aby opracować bardziej kompletny zestaw zasad wyjaśniających uwarunkowania operanta. Skinner stworzył specjalnie zaprojektowane środowiska znane jako komory operantów (zwykle nazywane skrzynkami Skinnera), aby systematycznie studiować uczenie się. Skrzynka Skinnera (komora operacyjna) to struktura wystarczająco duża, aby zmieścić Gryzonia lub ptaka i zawierająca pasek lub klucz, który organizm może nacisnąć lub dziobnąć, aby uwolnić żywność lub wodę. Zawiera również urządzenie do rejestrowania odpowiedzi zwierzęcia (rysunek 8.5).

najbardziej podstawowe eksperymenty Skinnera były dość podobne do badań Thorndike ’ a z kotami. Szczur umieszczony w komorze zareagował, jak można się było spodziewać, biegając po pudełku, wąchając i drapiąc podłogę i ściany. W końcu szczur natknął się na dźwignię, którą nacisnął, aby uwolnić granulki jedzenia. Następnym razem szczur potrzebował nieco mniej czasu na naciśnięcie dźwigni, a w kolejnych próbach czas potrzebny na naciśnięcie dźwigni stawał się coraz krótszy. Wkrótce szczur naciskał dźwignię tak szybko, jak mógł zjeść jedzenie, które się pojawiło. Zgodnie z prawem skutku, szczur nauczył się powtarzać akcję, która przyniosła Jedzenie i zaprzestać działań, które nie.

Skinner szczegółowo zbadał, w jaki sposób zwierzęta zmieniają swoje zachowanie poprzez wzmacnianie i karanie, i opracował terminy wyjaśniające procesy uczenia się operantów (tabela 8.1, „jak pozytywne i negatywne wzmocnienie i kara wpływają na zachowanie”). Skinner użył terminu wzmacniacz w odniesieniu do każdego zdarzenia, które wzmacnia lub zwiększa prawdopodobieństwo zachowania, a termin punisher w odniesieniu do każdego zdarzenia, które osłabia lub zmniejsza prawdopodobieństwo zachowania. I użył terminów pozytywne i negatywne w odniesieniu do tego, czy wzmocnienie zostało przedstawione lub usunięte, odpowiednio. Tak więc pozytywne wzmocnienie wzmacnia odpowiedź, prezentując coś przyjemnego po odpowiedzi, a negatywne wzmocnienie wzmacnia odpowiedź, zmniejszając lub usuwając coś nieprzyjemnego. Na przykład dawanie dziecku pochwał za odrabianie lekcji oznacza pozytywne wzmocnienie, podczas gdy przyjmowanie aspiryny w celu zmniejszenia bólu głowy oznacza negatywne wzmocnienie. W obu przypadkach wzmocnienie zwiększa prawdopodobieństwo ponownego wystąpienia zachowań w przyszłości.

| opis | wynik | przykład | |

|---|---|---|---|

| wzmocnienie pozytywne | Dodaj lub zwiększ przyjemny bodziec | zachowanie się wzmacnia | dając uczniowi nagrodę po otrzymaniu A z testu |

| wzmocnienie negatywne | zmniejsz lub usuń nieprzyjemny bodziec | zachowanie jest wzmocnione | przyjmowanie leków przeciwbólowych, które eliminują ból, zwiększa prawdopodobieństwo, że weźmiesz znowu leki przeciwbólowe |

| pozytywna kara | Przedstaw lub dodaj nieprzyjemny bodziec | zachowanie jest osłabione | dając uczniowi dodatkową pracę domową po tym, jak źle się zachowuje w klasie |

| Kara negatywna | zmniejsz lub usuń przyjemny bodziec | zachowanie jest osłabione | zabranie nastolatkowi komputera po tym, jak on lub ona przegapi godzinę policyjną |

wzmocnienie, zarówno pozytywne, jak i negatywne, działa poprzez zwiększenie prawdopodobieństwa zachowania. Kara natomiast odnosi się do każdego zdarzenia, które osłabia lub zmniejsza prawdopodobieństwo zachowania. Kara pozytywna osłabia odpowiedź, prezentując coś nieprzyjemnego po odpowiedzi, podczas gdy kara negatywna osłabia odpowiedź, zmniejszając lub usuwając coś przyjemnego. Dziecko, które jest uziemione po walce z rodzeństwem (kara pozytywna) lub które traci możliwość pójścia na przerwę po uzyskaniu złej oceny (kara negatywna), jest mniej prawdopodobne, aby powtórzyć te zachowania.

chociaż różnica między wzmocnieniem (co zwiększa zachowanie) a karą (co zmniejsza je) jest zwykle jasna, w niektórych przypadkach trudno jest określić, czy wzmacniacz jest pozytywny, czy negatywny. W upalny dzień chłodny powiew może być postrzegany jako wzmacniacz dodatni (ponieważ przynosi chłodne powietrze) lub wzmacniacz ujemny (ponieważ usuwa gorące powietrze). W innych przypadkach wzmocnienie może być zarówno pozytywne, jak i negatywne. Można palić papierosa zarówno dlatego, że przynosi przyjemność (pozytywne wzmocnienie), jak i dlatego, że eliminuje pragnienie nikotyny (negatywne wzmocnienie).

ważne jest również, aby pamiętać, że wzmocnienie i kara nie są po prostu przeciwieństwami. Stosowanie pozytywnego wzmocnienia w zmianie zachowania jest prawie zawsze bardziej skuteczne niż stosowanie kary. Dzieje się tak, ponieważ pozytywne wzmocnienie sprawia, że osoba lub zwierzę czują się lepiej, pomagając stworzyć pozytywną relację z osobą zapewniającą wzmocnienie. Rodzaje pozytywnego wzmocnienia, które są skuteczne w życiu codziennym, obejmują słowne pochwały lub aprobatę, przyznanie statusu lub prestiżu oraz bezpośrednią płatność finansową. Z drugiej strony, kara jest bardziej skłonna do tworzenia tylko tymczasowych zmian w zachowaniu, ponieważ opiera się na przymusie i zazwyczaj tworzy negatywny i kontradyktoryjny związek z osobą zapewniającą wzmocnienie. Gdy osoba, która wymierza karę, opuści sytuację, niepożądane zachowanie prawdopodobnie powróci.

tworzenie złożonych zachowań poprzez warunkowanie Operanta

być może pamiętasz oglądanie filmu lub bycie na wystawie, w której zwierzę — może pies, koń lub delfin — dokonało niesamowitych rzeczy. Trener wydał polecenie, a Delfin popłynął na dno basenu, podniósł pierścień na nosie, wyskoczył z wody przez obręcz w powietrzu, zanurkował ponownie na dno basenu, podniósł kolejny pierścień, a następnie zabrał oba pierścienie do trenera na krawędzi basenu. Zwierzę zostało przeszkolone do wykonywania triku, a do jego wytrenowania wykorzystano Zasady warunkowania operanta. Ale te złożone zachowania są dalekie od prostych relacji bodziec-odpowiedź, które rozważaliśmy do tej pory. W jaki sposób można wykorzystać wzmocnienie do tworzenia złożonych zachowań, takich jak te?

jednym ze sposobów na rozszerzenie wykorzystania uczenia operant jest modyfikacja harmonogramu, na którym stosuje się wzmocnienie. Do tego momentu omówiliśmy tylko ciągły harmonogram zbrojenia, w którym pożądana odpowiedź jest wzmacniana za każdym razem, gdy występuje; za każdym razem, gdy pies przewraca się, na przykład, dostaje ciastko. Ciągłe wzmacnianie skutkuje stosunkowo szybkim uczeniem się, ale także szybkim zanikiem pożądanego zachowania po zaniku wzmacniacza. Problem polega na tym, że ponieważ organizm jest przyzwyczajony do otrzymywania wzmocnienia po każdym zachowaniu, osoba reagująca może szybko zrezygnować, gdy się nie pojawi.

Większość realnych wzmacniaczy nie jest ciągła; występują na częściowym (lub przerywanym) harmonogramie zbrojenia — harmonogramie, w którym reakcje są czasami wzmacniane, a czasami nie. W porównaniu do ciągłego zbrojenia, harmonogramy częściowego zbrojenia prowadzą do wolniejszego uczenia się początkowego, ale prowadzą również do większej odporności na wymieranie. Ponieważ wzmocnienie nie pojawia się po każdym zachowaniu, potrzeba więcej czasu, aby uczeń ustalił, że nagroda już nie nadchodzi, a zatem wygaszenie jest wolniejsze. Cztery rodzaje harmonogramów częściowego zbrojenia podsumowano w tabeli 8.2 ” harmonogramy zbrojenia.”

| schemat zbrojenia | Wyjaśnienie | przykład ze świata rzeczywistego |

|---|---|---|

| zachowanie o stałym stosunku | jest wzmacniane po określonej liczbie odpowiedzi. | pracownicy fabryki, którzy otrzymują wynagrodzenie w zależności od liczby produktów, które produkują |

| zmienny stosunek | zachowanie jest wzmocnione po średniej, ale nieprzewidywalnej, liczbie odpowiedzi. | wypłaty z automatów i innych gier losowych |

| zachowanie ze stałym interwałem | jest wzmacniane dla pierwszej odpowiedzi po upływie określonego czasu. | ludzie, którzy zarabiają miesięczne wynagrodzenie |

| zmienny interwał | zachowanie jest wzmacniane dla pierwszej odpowiedzi po upływie średniego, ale nieprzewidywalnego czasu. | osoba sprawdzająca maile pod kątem wiadomości |

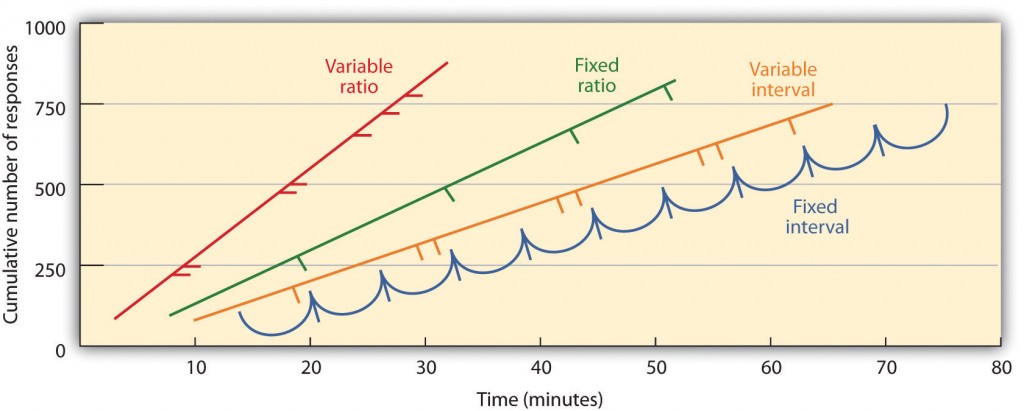

częściowe harmonogramy zbrojeń są określane przez to, czy zbrojenie jest prezentowane na podstawie czasu, który upływa między zbrojeniem (interwał) lub na podstawie liczby odpowiedzi, które organizm angażuje (stosunek), oraz przez to, czy zbrojenie występuje w regularnym (stałym) lub nieprzewidywalnym (zmiennym) harmonogramie. W ustalonym harmonogramie interwałowym wzmocnienie występuje dla pierwszej odpowiedzi wykonanej po upływie określonego czasu. Na przykład w jednominutowym harmonogramie o ustalonych odstępach czasu zwierzę otrzymuje wzmocnienie co minutę, zakładając, że przynajmniej raz w ciągu minuty angażuje się w zachowanie. Jak widać na rysunku 8.6, „przykłady wzorców reakcji przez zwierzęta wyszkolone w ramach różnych harmonogramów częściowego wzmocnienia”, zwierzęta w harmonogramach o stałych interwałach mają tendencję do spowolnienia reakcji natychmiast po wzmocnieniu, ale następnie ponownie zwiększają zachowanie, gdy czas następnego wzmocnienia zbliża się. (Większość studentów uczy się do egzaminów w ten sam sposób.) W harmonogramie zmiennych interwałów wzmacniacze pojawiają się w harmonogramie interwałów, ale czas zmienia się wokół średniego interwału, dzięki czemu rzeczywisty wygląd wzmacniacza jest nieprzewidywalny. Przykładem może być sprawdzanie poczty e-mail: jesteś wzmocniony przez otrzymywanie wiadomości, które przychodzą średnio co 30 minut, ale wzmocnienie występuje tylko losowo. Interwałowe harmonogramy wzmacniania wydają się produkować powolne i stałe wskaźniki odpowiedzi.

w harmonogramie o stałym współczynniku zachowanie jest wzmacniane po określonej liczbie odpowiedzi. Na przykład, zachowanie szczura może zostać wzmocnione po naciśnięciu klawisza 20 razy, lub sprzedawca może otrzymać premię po sprzedaniu 10 produktów. Jak widać na rysunku 8.6, „przykłady wzorców reakcji zwierząt wyszkolonych w ramach różnych harmonogramów częściowego wzmocnienia”, gdy organizm nauczy się działać zgodnie z harmonogramem o ustalonych proporcjach, zatrzyma się tylko na krótko, gdy nastąpi wzmocnienie, zanim powróci do wysokiego poziomu reakcji. Harmonogram zmiennych proporcji zapewnia wzmacniacze po określonej, ale średniej liczbie odpowiedzi. Wygrywanie pieniędzy z automatów lub na kuponie loteryjnym jest przykładem wzmocnienia, które występuje w harmonogramie zmiennych współczynników. Na przykład automat (patrz rysunek 8.7, „automat”) może być zaprogramowany tak, aby zapewnić wygraną średnio co 20 razy, gdy użytkownik pociągnie za rączkę. Harmonogramy stosunek wydają się produkować wysokie wskaźniki odpowiedzi, ponieważ wzmocnienie wzrasta wraz ze wzrostem liczby odpowiedzi.

złożone zachowania powstają również poprzez kształtowanie, proces kierowania zachowania organizmu do pożądanego rezultatu poprzez zastosowanie sukcesywnego Zbliżenia do ostatecznego pożądanego zachowania. Skinner wykorzystał tę procedurę w swoich pudłach. Na przykład, mógł wytrenować szczura, aby dwukrotnie nacisnął poprzeczkę, aby otrzymać jedzenie, najpierw dostarczając jedzenie, gdy zwierzę poruszało się w pobliżu baru. Kiedy nauczono się tego zachowania, Skinner zaczął dostarczać pokarm tylko wtedy, gdy szczur dotknął baru. Dalsze kształtowanie ograniczało wzmocnienie tylko wtedy, gdy szczur nacisnął drążek, kiedy nacisnął drążek i dotknął go po raz drugi, a na koniec tylko wtedy, gdy nacisnął drążek dwa razy. Chociaż może to zająć dużo czasu, w ten sposób uwarunkowania operantowe mogą tworzyć łańcuchy zachowań, które są wzmacniane dopiero po ich zakończeniu.

wzmacnianie zwierząt, jeśli prawidłowo rozróżniają podobne bodźce, pozwala naukowcom przetestować zdolność zwierząt do uczenia się, a rozróżnienia, które mogą powodować, są czasami niezwykłe. Gołębie zostały przeszkolone w rozróżnianiu obrazów Charliego Browna i innych postaci z orzeszków ziemnych (Cerella, 1980) oraz różnych stylów muzyki i sztuki (Porter & Neuringer, 1984; Watanabe, Sakamoto & Wakita, 1995).

Podczas gdy wzmacniacz pierwotny zawiera bodźce, które są naturalnie preferowane lub cieszą się organizmem, takie jak jedzenie, woda i ulga w bólu, wzmacniacz wtórny (czasami nazywany wzmacniaczem warunkowym) jest neutralnym wydarzeniem, które stało się związane ze wzmacniaczem pierwotnym poprzez klasyczne uwarunkowanie. Przykładem wtórnego wzmacniacza byłby gwizdek podany przez tresera zwierząt, który z czasem był kojarzony z podstawowym wzmacniaczem, pokarmem. Przykładem codziennego wzmacniacza wtórnego są pieniądze. Cieszymy się z posiadania pieniędzy, nie tyle za sam bodziec, ale raczej za podstawowe wzmacniacze (rzeczy, które można kupić za pieniądze), z którymi są one związane.

kluczowe wnioski

- Edward Thorndike opracował prawo skutku: zasadę, że odpowiedzi, które tworzą typowo przyjemny wynik w danej sytuacji, są bardziej prawdopodobne, że wystąpią ponownie w podobnej sytuacji, podczas gdy odpowiedzi, które wywołują typowo nieprzyjemny wynik, są mniej prawdopodobne, aby wystąpić ponownie w tej sytuacji.

- B. F. Skinner rozwinął idee Thorndike ’ a, aby opracować zestaw zasad wyjaśniających uwarunkowania operanta.

- wzmocnienie pozytywne wzmacnia odpowiedź, prezentując coś, co jest zazwyczaj przyjemne po odpowiedzi, podczas gdy wzmocnienie negatywne wzmacnia odpowiedź, zmniejszając lub usuwając coś, co jest zazwyczaj nieprzyjemne.

- pozytywna kara osłabia odpowiedź, prezentując coś typowo nieprzyjemnego po odpowiedzi, podczas gdy negatywna kara osłabia odpowiedź, zmniejszając lub usuwając coś, co jest typowo przyjemne.

- wzmocnienie może być częściowe lub ciągłe. Harmonogramy wzmocnienia częściowego są określane przez to, czy wzmocnienie jest prezentowane na podstawie czasu, który upływa między wzmocnieniami (interwał) lub na podstawie liczby odpowiedzi, które organizm angażuje (stosunek), oraz przez to, czy wzmocnienie występuje w regularnym (stałym) lub nieprzewidywalnym (zmiennym) harmonogramie.

- złożone zachowania mogą być tworzone poprzez kształtowanie, proces kierowania zachowania organizmu do pożądanego rezultatu poprzez zastosowanie sukcesywnego Zbliżenia do ostatecznego pożądanego zachowania.

ćwiczenia i krytyczne myślenie

- dają przykład z codziennego życia każdego z następujących: pozytywne wzmocnienie, negatywne wzmocnienie, pozytywna kara, negatywna kara.

- rozważ techniki wzmacniania, których możesz użyć, aby wytresować psa, aby złapał i odzyskał Frisbee, które do niego rzucasz.

- obejrzyj poniższe dwa filmy z aktualnych programów telewizyjnych. Czy możesz określić, które procedury uczenia się są demonstrowane?

- Biuro: http://www.break.com/usercontent/2009/11/the-office-altoid-eksperyment-1499823

- Teoria wielkiego podrywu : http://www.youtube.com/watch?v=JA96Fba-WHk

Cerella, J. (1980). Analiza zdjęć gołębia. Rozpoznawanie Wzorców, 12, 1-6.

Animal intelligence: an experimental study of the asocjative processes in animals. Washington, DC: American Psychological Association.

Przypisanie Obrazu

Rysunek 8.6: Adaptacja Kassin (2003).