Lernziele

- Skizzieren Sie die Prinzipien der operanten Konditionierung.

- Erklären Sie, wie Lernen durch den Einsatz von Verstärkungsplänen und sekundären Verstärkern gestaltet werden kann.

In der klassischen Konditionierung lernt der Organismus, neue Reize mit natürlichen biologischen Reaktionen wie Speichelfluss oder Angst in Verbindung zu bringen. Der Organismus lernt nicht etwas Neues, sondern beginnt bei Vorliegen eines neuen Signals ein bestehendes Verhalten auszuführen. Operante Konditionierung hingegen ist Lernen, das auf der Grundlage der Konsequenzen des Verhaltens stattfindet und das Lernen neuer Handlungen beinhalten kann. Operante Konditionierung tritt auf, wenn ein Hund auf Befehl rollt, weil er dafür in der Vergangenheit gelobt wurde, wenn ein Schulzimmer-Tyrann seine Klassenkameraden bedroht, weil er dadurch seinen Weg finden kann, und wenn ein Kind gute Noten bekommt, weil seine Eltern drohen, sie zu bestrafen, wenn sie es nicht tut. In der operanten Konditionierung lernt der Organismus aus den Konsequenzen seines eigenen Handelns.

Wie Verstärkung und Bestrafung das Verhalten beeinflussen: Die Forschung von Thorndike und Skinner

Der Psychologe Edward L. Thorndike (1874-1949) war der erste Wissenschaftler, der operante Konditionierung systematisch untersuchte. In seiner Forschung beobachtete Thorndike (1898) Katzen, die in eine „Puzzle-Box“ gelegt worden waren, aus der sie zu entkommen versuchten („Video Clip: Thorndike’s Puzzle Box“). Zuerst kratzten, bissen und schlugen die Katzen willkürlich, ohne zu wissen, wie sie herauskommen sollten. Aber schließlich und versehentlich drückten sie den Hebel, der die Tür öffnete, und stiegen zu ihrem Preis aus, einem Stück Fisch. Das nächste Mal, wenn die Katze in der Box eingeschränkt war, versuchte sie weniger der unwirksamen Antworten, bevor sie die erfolgreiche Flucht durchführte, und nach mehreren Versuchen lernte die Katze, fast sofort die richtige Antwort zu geben.

Die Beobachtung dieser Veränderungen im Verhalten der Katzen veranlasste Thorndike, sein Wirkungsgesetz zu entwickeln, das Prinzip, dass Reaktionen, die in einer bestimmten Situation ein typisch angenehmes Ergebnis hervorrufen, in einer ähnlichen Situation eher wieder auftreten, während Reaktionen, die ein typisch unangenehmes Ergebnis hervorrufen, in der Situation weniger wahrscheinlich wieder auftreten (Thorndike, 1911). Das Wesen des Wirkungsgesetzes besteht darin, dass erfolgreiche Reaktionen, weil sie angenehm sind, durch Erfahrung „eingeprägt“ werden und daher häufiger auftreten. Erfolglose Reaktionen, die unangenehme Erfahrungen hervorrufen, werden „ausgerottet“ und treten anschließend seltener auf.

Als Thorndike seine Katzen in eine Puzzle-Box legte, stellte er fest, dass sie nach jedem Versuch schneller lernten, sich auf das wichtige Fluchtverhalten einzulassen. Thorndike beschrieb das Lernen, das der Verstärkung folgt, in Bezug auf das Gesetz der Wirkung.

Uhr: „Thorndike’s Puzzle Box“ : http://www.youtube.com/watch?v=BDujDOLre-8

Uhr: „Thorndike’s Puzzle Box“ : http://www.youtube.com/watch?v=BDujDOLre-8

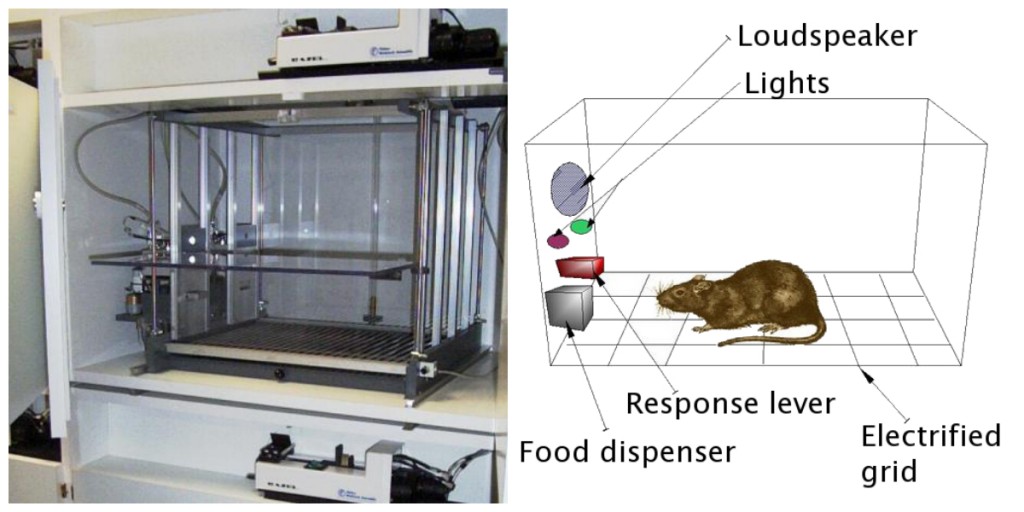

Der einflussreiche Verhaltenspsychologe B. F. Skinner (1904-1990) erweiterte Thorndikes Ideen, um einen vollständigeren Satz von Prinzipien zur Erklärung der operanten Konditionierung zu entwickeln. Skinner schuf speziell entworfene Umgebungen, die als operante Kammern (normalerweise Skinner-Boxen genannt) bekannt sind, um das Lernen systematisch zu untersuchen. Eine Skinner-Box (operante Kammer) ist eine Struktur, die groß genug ist, um ein Nagetier oder einen Vogel aufzunehmen, und die eine Stange oder einen Schlüssel enthält, den der Organismus drücken oder picken kann, um Nahrung oder Wasser freizusetzen. Es enthält auch ein Gerät zur Aufzeichnung der Reaktionen des Tieres (Abbildung 8.5).

Das grundlegendste von Skinners Experimenten war Thorndikes Forschung mit Katzen ziemlich ähnlich. Eine Ratte, die sich in der Kammer befand, reagierte wie erwartet, huschte durch die Kiste und schnüffelte und krallte sich am Boden und an den Wänden. Schließlich stieß die Ratte zufällig auf einen Hebel, den sie drückte, um Futterpellets freizusetzen. Das nächste Mal brauchte die Ratte etwas weniger Zeit, um den Hebel zu drücken, und bei aufeinanderfolgenden Versuchen wurde die Zeit, die zum Drücken des Hebels benötigt wurde, immer kürzer. Bald drückte die Ratte den Hebel so schnell, wie sie das auftauchende Futter essen konnte. Wie durch das Gesetz der Wirkung vorhergesagt, hatte die Ratte gelernt, die Handlung zu wiederholen, die das Essen hervorbrachte, und die Handlungen einzustellen, die dies nicht taten.

Skinner untersuchte im Detail, wie Tiere ihr Verhalten durch Verstärkung und Bestrafung veränderten, und entwickelte Begriffe, die die Prozesse des operanten Lernens erklärten (Tabelle 8.1, „Wie positive und negative Verstärkung und Bestrafung das Verhalten beeinflussen“). Skinner verwendete den Begriff Verstärker, um sich auf jedes Ereignis zu beziehen, das die Wahrscheinlichkeit eines Verhaltens verstärkt oder erhöht, und den Begriff Punisher, um sich auf jedes Ereignis zu beziehen, das die Wahrscheinlichkeit eines Verhaltens schwächt oder verringert. Und er verwendete die Begriffe positiv und negativ, um sich darauf zu beziehen, ob eine Verstärkung präsentiert oder entfernt wurde. So stärkt die positive Verstärkung eine Antwort, indem sie nach der Antwort etwas Angenehmes präsentiert, und die negative Verstärkung stärkt eine Antwort, indem sie etwas Unangenehmes reduziert oder entfernt. Zum Beispiel stellt das Lob eines Kindes für die Erledigung seiner Hausaufgaben eine positive Verstärkung dar, während die Einnahme von Aspirin zur Verringerung der Kopfschmerzen eine negative Verstärkung darstellt. In beiden Fällen erhöht die Verstärkung die Wahrscheinlichkeit, dass das Verhalten in Zukunft erneut auftritt.

| Operante Konditionierung term | Beschreibung | Ergebnis | Beispiel |

|---|---|---|---|

| Positive Verstärkung | Fügen Sie einen angenehmen Reiz hinzu oder erhöhen Sie ihn | Das Verhalten wird gestärkt | Einem Schüler einen Preis geben, nachdem er bei einem Test ein A erhalten hat |

| Negative Verstärkung | Reduzieren oder entfernen Sie einen unangenehmen Reiz | Das Verhalten wird gestärkt | Die Einnahme von Schmerzmitteln, die Schmerzen beseitigen, erhöht die Wahrscheinlichkeit, dass Sie wieder Schmerzmittel |

| Positive Bestrafung | Einen unangenehmen Reiz präsentieren oder hinzufügen | Verhalten wird geschwächt | Einem Schüler zusätzliche Hausaufgaben geben, nachdem er sich im Unterricht schlecht benommen hat |

| Negative Bestrafung | Reduzieren oder entfernen Sie einen angenehmen Reiz | Verhalten wird geschwächt | Den Computer eines Teenagers wegnehmen, nachdem er oder sie die Ausgangssperre verpasst hat |

Verstärkung, entweder positiv oder negativ, erhöht die Wahrscheinlichkeit eines Verhaltens. Bestrafung hingegen bezieht sich auf jedes Ereignis, das die Wahrscheinlichkeit eines Verhaltens schwächt oder verringert. Positive Bestrafung schwächt eine Antwort, indem sie etwas Unangenehmes nach der Antwort präsentiert, während negative Bestrafung eine Antwort schwächt, indem sie etwas Angenehmes reduziert oder entfernt. Ein Kind, das nach einem Kampf mit einem Geschwister geerdet ist (positive Bestrafung) oder das die Möglichkeit verliert, nach einer schlechten Note in die Pause zu gehen (negative Bestrafung), wiederholt diese Verhaltensweisen seltener.

Obwohl die Unterscheidung zwischen Verstärkung (die das Verhalten erhöht) und Bestrafung (die es verringert) normalerweise klar ist, ist es in einigen Fällen schwierig zu bestimmen, ob ein Verstärker positiv oder negativ ist. An einem heißen Tag kann eine kühle Brise als positiver Verstärker (weil sie kühle Luft hereinbringt) oder als negativer Verstärker (weil sie heiße Luft entfernt) angesehen werden. In anderen Fällen kann die Verstärkung sowohl positiv als auch negativ sein. Man kann eine Zigarette rauchen, weil sie Freude bereitet (positive Verstärkung) und weil sie das Verlangen nach Nikotin beseitigt (negative Verstärkung).

Es ist auch wichtig zu beachten, dass Verstärkung und Bestrafung nicht einfach Gegensätze sind. Die Verwendung von positiver Verstärkung bei Verhaltensänderungen ist fast immer effektiver als Bestrafung. Dies liegt daran, dass sich die Person oder das Tier durch positive Verstärkung besser fühlt und eine positive Beziehung zu der Person aufbaut, die die Verstärkung bereitstellt. Arten der positiven Verstärkung, die im Alltag wirksam sind, umfassen verbales Lob oder Zustimmung, die Vergabe von Status oder Prestige und direkte finanzielle Zahlung. Bestrafung hingegen führt eher zu vorübergehenden Verhaltensänderungen, da sie auf Zwang beruht und typischerweise eine negative und kontradiktorische Beziehung zu der Person schafft, die die Verstärkung bereitstellt. Wenn die Person, die die Strafe verhängt, die Situation verlässt, wird das unerwünschte Verhalten wahrscheinlich zurückkehren.

Komplexe Verhaltensweisen durch operante Konditionierung erzeugen

Vielleicht erinnern Sie sich an einen Film oder eine Show, in der ein Tier — vielleicht ein Hund, ein Pferd oder ein Delphin — einige erstaunliche Dinge getan hat. Der Trainer gab einen Befehl und der Delphin schwamm zum Boden des Pools, nahm einen Ring an der Nase, sprang durch einen Reifen in der Luft aus dem Wasser, tauchte wieder auf den Boden des Pools, nahm einen weiteren Ring und brachte dann beide Ringe zum Trainer am Rand des Pools. Das Tier wurde trainiert, um den Trick zu machen, und die Prinzipien der operanten Konditionierung wurden verwendet, um es zu trainieren. Aber diese komplexen Verhaltensweisen sind weit entfernt von den einfachen Reiz-Antwort-Beziehungen, die wir bisher in Betracht gezogen haben. Wie kann Verstärkung verwendet werden, um komplexe Verhaltensweisen wie diese zu erzeugen?

Eine Möglichkeit, die Verwendung des operanten Lernens zu erweitern, besteht darin, den Zeitplan zu ändern, auf den die Verstärkung angewendet wird. Bis zu diesem Punkt haben wir nur einen kontinuierlichen Verstärkungsplan besprochen, in dem die gewünschte Antwort jedes Mal verstärkt wird, wenn sie auftritt; immer wenn sich der Hund zum Beispiel umdreht, bekommt er einen Keks. Kontinuierliche Verstärkung führt zu relativ schnellem Lernen, aber auch zu einem schnellen Aussterben des gewünschten Verhaltens, sobald der Verstärker verschwindet. Das Problem ist, dass, weil der Organismus daran gewöhnt ist, die Verstärkung nach jedem Verhalten zu erhalten, der Responder schnell aufgeben kann, wenn er nicht erscheint.

Die meisten realen Verstärkungen sind nicht kontinuierlich; Sie treten nach einem teilweisen (oder intermittierenden) Verstärkungsplan auf – einem Zeitplan, in dem die Antworten manchmal verstärkt werden und manchmal nicht. Im Vergleich zur kontinuierlichen Verstärkung führen partielle Verstärkungspläne zu einem langsameren anfänglichen Lernen, aber auch zu einer größeren Resistenz gegen das Aussterben. Da die Verstärkung nicht nach jedem Verhalten erscheint, dauert es länger, bis der Lernende feststellt, dass die Belohnung nicht mehr kommt, und daher ist das Aussterben langsamer. Die vier Arten von Teilbewehrungsplänen sind in Tabelle 8.2, „Bewehrungspläne.“

| Verstärkungsplan | Erklärung | Beispiel aus der Praxis |

|---|---|---|

| Fixed-ratio | Das Verhalten wird nach einer bestimmten Anzahl von Antworten verstärkt. | Fabrikarbeiter, die nach der Anzahl der von ihnen hergestellten Produkte bezahlt werden |

| Variable-ratio | Das Verhalten wird nach einer durchschnittlichen, aber unvorhersehbaren Anzahl von Antworten verstärkt. | Auszahlungen von Spielautomaten und anderen Glücksspielen |

| Festes Intervall | Das Verhalten wird für die erste Antwort nach Ablauf einer bestimmten Zeit verstärkt. | Personen, die ein monatliches Gehalt verdienen |

| Variablenintervall | Das Verhalten wird für die erste Antwort verstärkt, nachdem eine durchschnittliche, aber unvorhersehbare Zeitspanne verstrichen ist. | Person, die E-Mails auf Nachrichten überprüft |

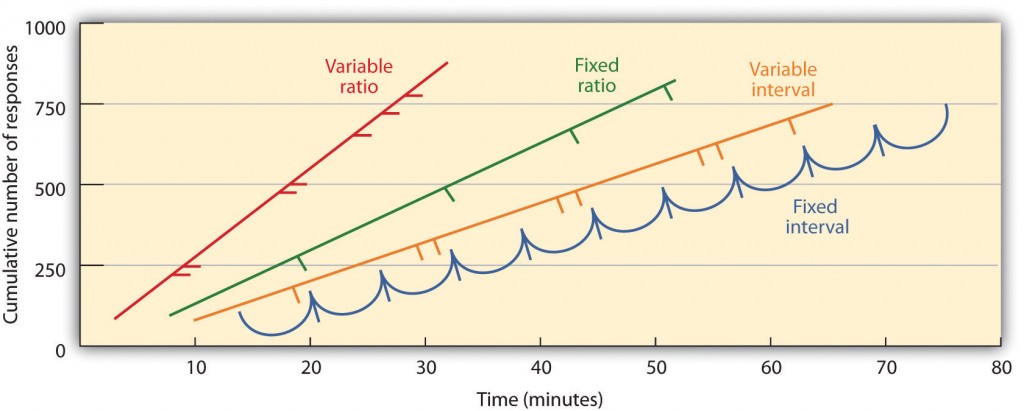

Teilbewehrungspläne werden dadurch bestimmt, ob die Verstärkung auf der Grundlage der Zeit zwischen der Verstärkung (Intervall) oder auf der Grundlage der Anzahl der Reaktionen, an denen der Organismus beteiligt ist (Verhältnis), und ob die Verstärkung nach einem regelmäßigen (festen) oder unvorhersehbaren (variablen) Zeitplan erfolgt. In einem Zeitplan mit festen Intervallen erfolgt die Verstärkung für die erste Antwort, die nach Ablauf einer bestimmten Zeitspanne erfolgt ist. Zum Beispiel erhält das Tier nach einem einminütigen Zeitplan mit festen Intervallen jede Minute eine Verstärkung, vorausgesetzt, es führt das Verhalten mindestens einmal während der Minute aus. Wie Sie in Abbildung 8.6, „Beispiele für Reaktionsmuster von Tieren, die unter verschiedenen Teilbewehrungsplänen trainiert wurden“, sehen können, neigen Tiere mit festen Intervallen dazu, ihre Reaktion unmittelbar nach der Verstärkung zu verlangsamen, aber dann das Verhalten wieder zu erhöhen, wenn die Zeit der nächsten Verstärkung näher rückt. (Die meisten Schüler lernen für Prüfungen auf die gleiche Weise.) In einem Zeitplan mit variablem Intervall erscheinen die Verstärkungen in einem Intervallplan, aber das Timing wird um das durchschnittliche Intervall herum variiert, wodurch das tatsächliche Erscheinungsbild des Verstärkers unvorhersehbar wird. Ein Beispiel könnte das Überprüfen Ihrer E-Mails sein: Sie werden durch den Empfang von Nachrichten verstärkt, die im Durchschnitt alle 30 Minuten eingehen, die Verstärkung erfolgt jedoch nur zu zufälligen Zeiten. Intervallverstärkungspläne neigen dazu, langsame und stetige Reaktionsraten zu erzeugen.

In einem Zeitplan mit festem Verhältnis wird ein Verhalten nach einer bestimmten Anzahl von Antworten verstärkt. Zum Beispiel kann das Verhalten einer Ratte verstärkt werden, nachdem sie 20 Mal eine Taste gedrückt hat, oder ein Verkäufer kann einen Bonus erhalten, nachdem er 10 Produkte verkauft hat. Wie Sie in Abbildung 8 sehen können.6, „Beispiele für Reaktionsmuster von Tieren, die unter verschiedenen Teilverstärkungsplänen trainiert wurden“, sobald der Organismus gelernt hat, gemäß dem Zeitplan mit festem Verhältnis zu handeln, wird er nur kurz pausieren, wenn eine Verstärkung auftritt, bevor er zu einem hohen Maß an Reaktionsfähigkeit zurückkehrt. Ein Zeitplan mit variablem Verhältnis bietet Verstärkung nach einer bestimmten, aber durchschnittlichen Anzahl von Antworten. Das Gewinnen von Geld an Spielautomaten oder auf einem Lottoschein ist ein Beispiel für eine Verstärkung, die nach einem Zeitplan mit variablem Verhältnis erfolgt. Zum Beispiel kann ein Spielautomat (siehe Abbildung 8.7, „Spielautomat“) kann so programmiert werden, dass alle 20-mal ein Gewinn erzielt wird, wenn der Benutzer im Durchschnitt am Griff zieht. Verhältnispläne neigen dazu, hohe Reaktionsraten zu erzeugen, da die Verstärkung mit zunehmender Anzahl der Antworten zunimmt.

Komplexe Verhaltensweisen entstehen auch durch Formgebung, den Prozess, das Verhalten eines Organismus durch sukzessive Annäherung an ein endgültiges gewünschtes Verhalten zum gewünschten Ergebnis zu führen. Skinner nutzte dieses Verfahren in seinen Boxen ausgiebig. Zum Beispiel könnte er eine Ratte trainieren, zweimal auf eine Stange zu drücken, um Nahrung zu erhalten, indem er zuerst Nahrung bereitstellt, wenn sich das Tier in der Nähe der Stange bewegt. Wenn dieses Verhalten erlernt worden war, würde Skinner erst dann anfangen, Nahrung zu liefern, wenn die Ratte die Stange berührte. Eine weitere Formgebung beschränkte die Verstärkung nur dann, wenn die Ratte die Stange drückte, wenn sie die Stange drückte und sie ein zweites Mal berührte, und schließlich nur dann, wenn sie die Stange zweimal drückte. Obwohl es sehr lange dauern kann, kann die operante Konditionierung auf diese Weise Verhaltensketten erzeugen, die erst verstärkt werden, wenn sie abgeschlossen sind.

Tiere zu verstärken, wenn sie zwischen ähnlichen Stimuli richtig unterscheiden, ermöglicht es Wissenschaftlern, die Lernfähigkeit der Tiere zu testen, und die Unterscheidungen, die sie vornehmen können, sind manchmal bemerkenswert. Tauben wurden darin geschult, zwischen Bildern von Charlie Brown und den anderen Peanuts-Charakteren (Cerella, 1980) und zwischen verschiedenen Musik- und Kunststilen (Porter & Neuringer, 1984) zu unterscheiden; Watanabe, Sakamoto & Wakita, 1995).

Verhaltensweisen können auch durch den Einsatz von sekundären Verstärkern trainiert werden. Während ein primärer Verstärker Reize umfasst, die vom Organismus auf natürliche Weise bevorzugt oder genossen werden, wie Nahrung, Wasser und Schmerzlinderung, ist ein sekundärer Verstärker (manchmal auch konditionierter Verstärker genannt) ein neutrales Ereignis, das durch klassische Konditionierung mit einem primären Verstärker in Verbindung gebracht wurde. Ein Beispiel für einen sekundären Verstärker wäre die Pfeife eines Tiertrainers, die im Laufe der Zeit mit dem primären Verstärker, dem Futter, in Verbindung gebracht wurde. Ein Beispiel für einen alltäglichen sekundären Verstärker ist Geld. Wir genießen es, Geld zu haben, nicht so sehr für den Stimulus selbst, sondern für die primären Verstärker (die Dinge, die Geld kaufen kann), mit denen es verbunden ist.

Wichtige Erkenntnisse

- Edward Thorndike entwickelte das Gesetz der Wirkung: Das Prinzip, dass Reaktionen, die in einer bestimmten Situation zu einem typischerweise angenehmen Ergebnis führen, in einer ähnlichen Situation eher wieder auftreten, während Antworten, die zu einem typischerweise unangenehmen Ergebnis führen, in der Situation seltener wieder auftreten.

- B. F. Skinner erweiterte Thorndikes Ideen, um eine Reihe von Prinzipien zur Erklärung der operanten Konditionierung zu entwickeln.

- Positive Verstärkung stärkt eine Antwort, indem sie etwas präsentiert, das typischerweise angenehm ist, während negative Verstärkung eine Antwort stärkt, indem sie etwas reduziert oder entfernt, das typischerweise unangenehm ist.

- Positive Bestrafung schwächt eine Reaktion, indem sie etwas typischerweise Unangenehmes nach der Antwort präsentiert, während negative Bestrafung eine Antwort schwächt, indem sie etwas reduziert oder entfernt, das typischerweise angenehm ist.

- Die Bewehrung kann partiell oder kontinuierlich erfolgen. Teilbewehrungspläne werden dadurch bestimmt, ob die Verstärkung auf der Grundlage der zwischen den Verstärkungen verstrichenen Zeit (Intervall) oder auf der Grundlage der Anzahl der Reaktionen des Organismus (Verhältnis) dargestellt wird und ob die Verstärkung nach einem regelmäßigen (festen) oder unvorhersehbaren (variablen) Zeitplan erfolgt.

- Komplexe Verhaltensweisen können durch Formen erzeugt werden, der Prozess, das Verhalten eines Organismus durch sukzessive Annäherung an ein endgültiges gewünschtes Verhalten zum gewünschten Ergebnis zu führen.

Übungen und kritisches Denken

- Geben Sie ein Beispiel aus dem täglichen Leben von jedem der folgenden: positive Verstärkung, negative Verstärkung, positive Bestrafung, negative Bestrafung.

- Betrachten Sie die Verstärkungstechniken, mit denen Sie einen Hund trainieren können, um einen Frisbee zu fangen und abzurufen, den Sie darauf werfen.

- Sehen Sie sich die folgenden zwei Videos aus aktuellen Fernsehsendungen an. Können Sie feststellen, welche Lernverfahren demonstriert werden?

- Das Büro: http://www.break.com/usercontent/2009/11/the-office-altoid- experiment-1499823

- Die Urknalltheorie : http://www.youtube.com/watch?v=JA96Fba-WHk

Cerella, J. (1980). Die Analyse der Bilder der Taube. Mustererkennung, 12, 1-6.

Thorndike, E. L. (1898). Animal Intelligence: Eine experimentelle Untersuchung der assoziativen Prozesse bei Tieren. Washington, DC: Amerikanische Psychologische Vereinigung.

Bildzuordnungen

Abbildung 8.6: Adaptiert von Kassin (2003).