inlärningsmål

- skissera principerna för operant conditioning.

- förklara hur lärande kan formas genom användning av förstärkningsscheman och sekundära förstärkare.

i klassisk konditionering lär organismen att associera nya stimuli med naturliga biologiska svar som salivation eller rädsla. Organismen lär sig inte något nytt utan börjar snarare utföra ett befintligt beteende i närvaro av en ny signal. Operant konditionering, å andra sidan, är lärande som sker baserat på konsekvenserna av beteende och kan involvera inlärning av nya handlingar. Operant konditionering uppstår när en hund rullar över på kommando eftersom det har blivit berömt för att göra det tidigare, när ett Skolrum mobbar hotar sina klasskamrater eftersom det gör det möjligt för honom att få sin väg och när ett barn får bra betyg eftersom hennes föräldrar hotar att straffa henne om hon inte gör det. I operant konditionering lär organismen av konsekvenserna av sina egna handlingar.

hur förstärkning och bestraffning påverkar beteende: forskningen av Thorndike och Skinner

psykolog Edward L. Thorndike (1874-1949) var den första forskaren som systematiskt studerade operant konditionering. I sin forskning observerade Thorndike (1898) katter som hade placerats i en ”pussellåda” från vilken de försökte fly (”videoklipp: Thorndike ’ s Puzzle Box”). Först skrapade katterna, bet och swatted slumpmässigt, utan någon aning om hur man kommer ut. Men så småningom, och av misstag, tryckte de på spaken som öppnade dörren och gick ut till sitt pris, ett skrot fisk. Nästa gång katten var begränsad i lådan försökte den färre av de ineffektiva svaren innan den lyckades fly, och efter flera försök lärde sig katten att nästan omedelbart göra rätt svar.

att observera dessa förändringar i katternas beteende ledde till att Thorndike utvecklade sin effektlag, principen att svar som skapar ett typiskt trevligt resultat i en viss situation är mer benägna att inträffa igen i en liknande situation, medan svar som ger ett typiskt obehagligt resultat är mindre benägna att uppstå igen i situationen (Thorndike, 1911). Kärnan i effektlagen är att framgångsrika svar, eftersom de är behagliga, ”stämplas in” av erfarenhet och därmed förekommer oftare. Misslyckade svar, som ger obehagliga upplevelser,” stämplas ut ” och uppträder därefter mindre ofta.

när Thorndike placerade sina katter i en pussellåda fann han att de lärde sig att engagera sig i det viktiga flyktbeteendet snabbare efter varje försök. Thorndike beskrev lärandet som följer förstärkning när det gäller effektlagen.

kolla på: ”Thorndike’ s Puzzle Box” : http://www.youtube.com/watch?v=BDujDOLre-8

kolla på: ”Thorndike’ s Puzzle Box” : http://www.youtube.com/watch?v=BDujDOLre-8

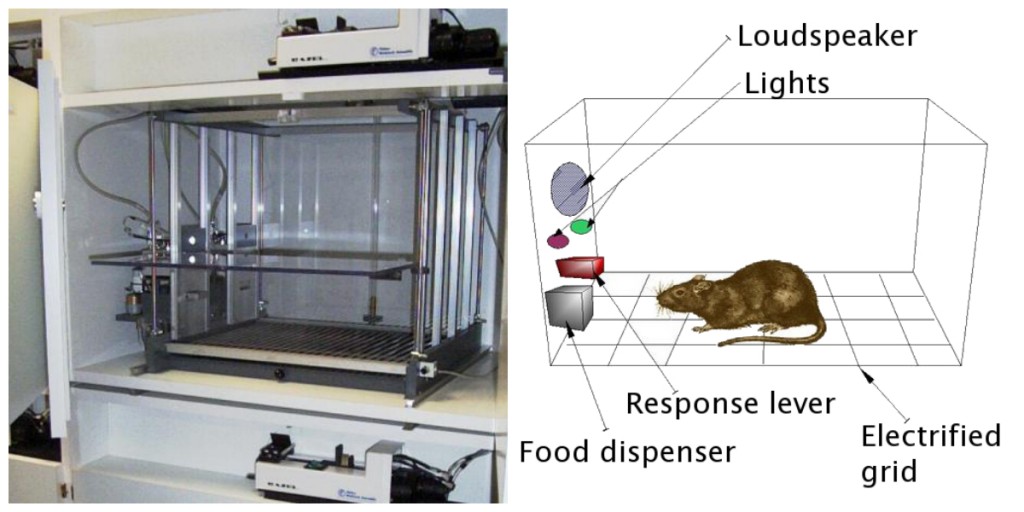

den inflytelserika beteendepsykologen B. F. Skinner (1904-1990) utvidgade Thorndikes ideer för att utveckla en mer komplett uppsättning principer för att förklara operant konditionering. Skinner skapade specialdesignade miljöer som kallas operantkammare (vanligtvis kallade Skinner-lådor) för att systematiskt studera lärande. En Skinner box (operant chamber) är en struktur som är tillräckligt stor för att passa en gnagare eller fågel och som innehåller en stapel eller nyckel som organismen kan trycka på eller pecka för att släppa ut mat eller vatten. Den innehåller också en anordning för att registrera djurets svar (figur 8.5).

den mest grundläggande av Skinners experiment var ganska lik Thorndikes forskning med katter. En råtta placeras i kammaren reagerade som man kan förvänta sig, ilande om lådan och sniffa och klo på golv och väggar. Så småningom råttan rått på en spak, som den pressade att släppa pellets av mat. Nästa gång tog råttan lite mindre tid att trycka på spaken, och vid successiva försök blev tiden det tog att trycka på spaken kortare och kortare. Snart pressade råttan spaken så fort den kunde äta maten som dök upp. Som förutsagt av lagen om effekt hade råttan lärt sig att upprepa åtgärden som medförde maten och upphöra med de handlingar som inte gjorde det.

Skinner studerade i detalj hur djur förändrade sitt beteende genom förstärkning och bestraffning, och han utvecklade termer som förklarade processerna för operant lärande (tabell 8.1, ”hur positiv och negativ förstärkning och bestraffning påverkar beteende”). Skinner använde termen förstärkare för att hänvisa till alla händelser som stärker eller ökar sannolikheten för ett beteende, och termen punisher för att hänvisa till alla händelser som försvagar eller minskar sannolikheten för ett beteende. Och han använde termerna positiva och negativa för att hänvisa till huruvida en förstärkning presenterades eller togs bort. Således stärker positiv förstärkning ett svar genom att presentera något trevligt efter svaret, och negativ förstärkning stärker ett svar genom att minska eller ta bort något obehagligt. Att ge ett barn beröm för att ha slutfört sina läxor representerar till exempel positiv förstärkning, medan att ta Aspirin för att minska smärtan vid huvudvärk representerar negativ förstärkning. I båda fallen gör förstärkningen det mer troligt att beteende kommer att inträffa igen i framtiden.

| Operant konditionering term | beskrivning | utfall | exempel |

|---|---|---|---|

| positiv förstärkning | Lägg till eller öka en trevlig stimulans | beteendet stärks | ge en student ett pris efter att han eller hon får ett A på ett test |

| negativ förstärkning | minska eller ta bort en obehaglig stimulans | beteendet stärks | att ta smärtstillande medel som eliminerar smärta ökar sannolikheten för att du tar smärtstillande medel igen |

| positiv bestraffning | presentera eller lägg till en obehaglig stimulans | beteendet försvagas | ge en elev extra läxor efter att han eller hon uppför sig felaktigt i klassen |

| negativt straff | minska eller ta bort en trevlig stimulans | beteendet försvagas | ta bort en tonårs dator efter att han eller hon saknar utegångsförbud |

förstärkning, antingen positiv eller negativ, fungerar genom att öka sannolikheten för ett beteende. Straff, å andra sidan, hänvisar till varje händelse som försvagar eller minskar sannolikheten för ett beteende. Positivt straff försvagar ett svar genom att presentera något obehagligt efter svaret, medan negativt straff försvagar ett svar genom att minska eller ta bort något trevligt. Ett barn som är jordat efter att ha kämpat med ett syskon (positivt straff) eller som förlorar möjligheten att gå i urtagning efter att ha fått en dålig betyg (negativt straff) är mindre benägna att upprepa dessa beteenden.

även om skillnaden mellan förstärkning (som ökar beteendet) och straff (som minskar det) vanligtvis är tydlig, är det i vissa fall svårt att avgöra om en förstärkare är positiv eller negativ. På en varm dag kan en sval bris ses som en positiv förstärkare (eftersom den tar in kall luft) eller en negativ förstärkare (eftersom den tar bort varm luft). I andra fall kan förstärkning vara både positiv och negativ. Man kan röka en cigarett både för att den ger nöje (positiv förstärkning) och för att den eliminerar begäret efter nikotin (negativ förstärkning).

det är också viktigt att notera att förstärkning och straff inte bara är motsatser. Användningen av positiv förstärkning i förändrat beteende är nästan alltid effektivare än att använda straff. Detta beror på att positiv förstärkning får personen eller djuret att må bättre och hjälper till att skapa en positiv relation med den som ger förstärkningen. Typer av positiv förstärkning som är effektiva i vardagen inkluderar verbalt beröm eller godkännande, tilldelning av status eller prestige och direkt ekonomisk betalning. Straff, å andra sidan, är mer benägna att skapa endast tillfälliga förändringar i beteende eftersom det är baserat på tvång och vanligtvis skapar ett negativt och kontradiktoriskt förhållande med den person som tillhandahåller förstärkningen. När personen som ger straffet lämnar situationen, kommer det oönskade beteendet sannolikt att återvända.

skapa komplexa beteenden genom Operant konditionering

kanske kommer du ihåg att titta på en Film eller vara på en show där ett djur — kanske en hund, en häst eller en delfin — gjorde några ganska fantastiska saker. Tränaren gav ett kommando och delfinen simmade till botten av poolen, plockade upp en ring på näsan, hoppade upp ur vattnet genom en ring i luften, dök igen till botten av poolen, plockade upp en annan ring och tog sedan båda ringarna till tränaren vid kanten av poolen. Djuret utbildades för att göra tricket, och principerna för operant konditionering användes för att träna det. Men dessa komplexa beteenden är långt ifrån de enkla stimulans-responsrelationer som vi hittills har övervägt. Hur kan förstärkning användas för att skapa komplexa beteenden som dessa?

ett sätt att utöka användningen av operant lärande är att ändra schemat på vilket förstärkningen tillämpas. Till denna punkt har vi bara diskuterat ett kontinuerligt förstärkningsschema, där det önskade svaret förstärks varje gång det inträffar; när hunden rullar över, till exempel, blir det en kex. Kontinuerlig förstärkning resulterar i relativt snabb inlärning men också snabb utrotning av önskat beteende när förstärkaren försvinner. Problemet är att eftersom organismen är van vid att ta emot förstärkningen efter varje beteende, kan responderen ge upp snabbt när den inte visas.

de flesta verkliga förstärkare är inte kontinuerliga; de förekommer på ett partiellt (eller intermittent) förstärkningsschema — ett schema där svaren ibland förstärks och ibland inte. I jämförelse med kontinuerlig förstärkning leder partiella förstärkningsscheman till långsammare inledande inlärning, men de leder också till större motstånd mot utrotning. Eftersom förstärkningen inte visas efter varje beteende tar det längre tid för eleven att bestämma att belöningen inte längre kommer, och därmed är utrotningen långsammare. De fyra typerna av partiella förstärkningsscheman sammanfattas i tabell 8.2, ”Förstärkningsscheman.”

| Förstärkningsschema | förklaring | verkligt exempel |

|---|---|---|

| fast förhållande | beteendet förstärks efter ett visst antal svar. | fabriksarbetare som betalas enligt antalet produkter de producerar |

| variabelt förhållande | beteendet förstärks efter ett genomsnittligt men oförutsägbart antal svar. | utbetalningar från spelautomater och andra hasardspel |

| fast intervall | beteendet förstärks för det första svaret efter att en viss tid har gått. | människor som tjänar en månadslön |

| variabelt intervall | beteendet förstärks för det första svaret efter en genomsnittlig men oförutsägbar tid har gått. | Person som kontrollerar e-post för meddelanden |

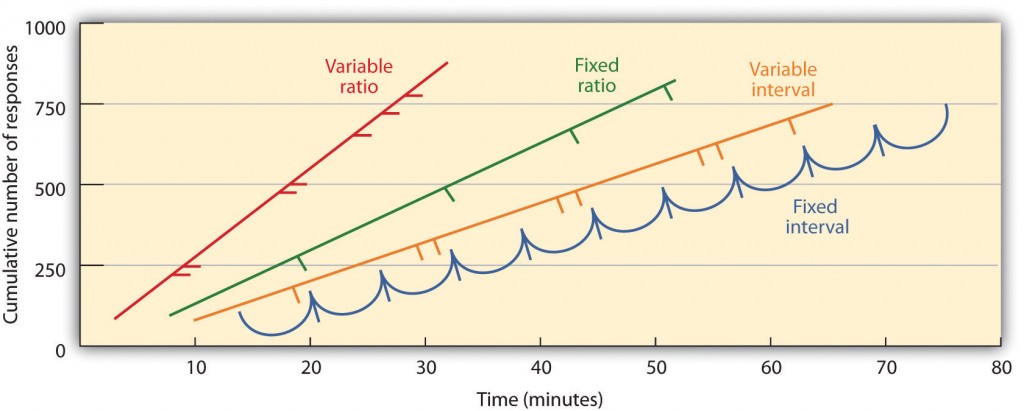

partiella förstärkningsscheman bestäms av om förstärkningen presenteras på grundval av tiden som går mellan förstärkning (intervall) eller på grundval av antalet svar som organismen engagerar sig i (förhållande) och av om förstärkningen sker på ett regelbundet (fast) eller oförutsägbart (variabelt) schema. I ett schema med fast intervall sker förstärkning för det första svaret efter att en viss tid har gått. Till exempel, på en minuts schema med fast intervall får djuret en förstärkning varje minut, förutsatt att det engagerar sig i beteendet minst en gång under minuten. Som du kan se i Figur 8.6, ”exempel på svarsmönster av djur som tränas under olika partiella Förstärkningsscheman”, tenderar djur under scheman med fast intervall att sakta ner deras svar omedelbart efter förstärkningen men sedan öka beteendet igen när tiden för nästa förstärkning kommer närmare. (De flesta studenter studerar för tentor på samma sätt.) I ett schema med variabelt intervall visas förstärkarna på ett intervallschema, men tidpunkten varierar runt det genomsnittliga intervallet, vilket gör förstärkarens faktiska utseende oförutsägbart. Ett exempel kan vara att kontrollera din e-post: du förstärks genom att ta emot meddelanden som i genomsnitt säger var 30: e minut, men förstärkningen sker endast slumpmässigt. Intervallförstärkningsscheman tenderar att producera långsamma och stabila svarsfrekvenser.

i ett schema med fast förhållande förstärks ett beteende efter ett visst antal svar. Till exempel kan en råttans beteende förstärkas efter att den har tryckt på en knapp 20 gånger, eller en säljare kan få en bonus efter att han eller hon har sålt 10 produkter. Som ni ser i figur 8.6, ”exempel på svarsmönster av djur utbildade under olika partiella Förstärkningsscheman”, när organismen har lärt sig att agera i enlighet med schemat med fast förhållande, kommer det bara att pausa kort när förstärkning inträffar innan den återgår till en hög responsnivå. Ett schema med variabelt förhållande ger förstärkare efter ett specifikt men genomsnittligt antal svar. Att vinna pengar från spelautomater eller på en lotteri är ett exempel på förstärkning som sker på ett schema med variabelt förhållande. Till exempel en spelautomat (se figur 8.7,” spelmaskin”) kan programmeras för att ge en vinst varje 20 gånger användaren drar i handtaget, i genomsnitt. Förhållande scheman tenderar att producera höga svarsfrekvenser eftersom förstärkning ökar när antalet svar ökar.

komplexa beteenden skapas också genom formning, processen att styra en organisms beteende till önskat resultat genom användning av successiv approximation till ett slutligt önskat beteende. Skinner gjorde omfattande användning av denna procedur i sina lådor. Till exempel kunde han träna en råtta att trycka på en bar två gånger för att ta emot mat, genom att först tillhandahålla mat när djuret rörde sig nära baren. När detta beteende hade lärt sig, Skinner skulle börja ge mat endast när råttan rörde baren. Ytterligare formning begränsade förstärkningen till endast när råttan pressade stången, till när den pressade stången och rörde den en andra gång, och slutligen till endast när den pressade stången två gånger. Även om det kan ta lång tid, kan operant konditionering på detta sätt skapa kedjor av beteenden som förstärks först när de är färdiga.

förstärkning av djur om de korrekt diskriminerar mellan liknande stimuli gör det möjligt för forskare att testa djurens förmåga att lära sig, och de diskrimineringar som de kan göra är ibland anmärkningsvärda. Duvor har utbildats för att skilja mellan bilder av Charlie Brown och de andra Peanuts-karaktärerna (Cerella, 1980) och mellan olika stilar av musik och konst (Porter & Neuringer, 1984; Watanabe, Sakamoto & Wakita, 1995).

beteenden kan också tränas genom användning av sekundära förstärkare. Medan en primär förstärkare inkluderar stimuli som naturligt föredras eller åtnjuts av organismen, såsom mat, vatten och lindring från smärta, är en sekundär förstärkare (ibland kallad konditionerad förstärkare) en neutral händelse som har blivit associerad med en primär förstärkare genom klassisk konditionering. Ett exempel på en sekundär förstärkare skulle vara visselpipan från en djurtränare, som har associerats över tid med den primära förstärkaren, mat. Ett exempel på en daglig sekundär förstärkare är pengar. Vi tycker om att ha pengar, inte så mycket för själva stimulansen, utan snarare för de primära förstärkarna (de saker som pengar kan köpa) som de är associerade med.

viktiga Takeaways

- Edward Thorndike utvecklade lagen om effekt: principen att svar som skapar ett typiskt trevligt resultat i en viss situation är mer benägna att inträffa igen i en liknande situation, medan svar som ger ett typiskt obehagligt resultat är mindre benägna att uppstå igen i situationen.

- B. F. Skinner utvidgade Thorndikes ideer för att utveckla en uppsättning principer för att förklara operant konditionering.

- positiv förstärkning stärker ett svar genom att presentera något som vanligtvis är trevligt efter svaret, medan negativ förstärkning stärker ett svar genom att minska eller ta bort något som vanligtvis är obehagligt.

- positivt straff försvagar ett svar genom att presentera något som vanligtvis är obehagligt efter svaret, medan negativt straff försvagar ett svar genom att minska eller ta bort något som vanligtvis är trevligt.

- förstärkning kan vara antingen partiell eller kontinuerlig. Partiella förstärkningsscheman bestäms av om förstärkningen presenteras på grundval av tiden som går mellan förstärkningar (intervall) eller på grundval av antalet svar som organismen engagerar sig i (förhållande) och av om förstärkningen sker på ett regelbundet (fast) eller oförutsägbart (variabelt) schema.

- komplexa beteenden kan skapas genom formning, processen att styra en organisms beteende till det önskade resultatet genom användning av successiv approximation till ett slutligt önskat beteende.

övningar och kritiskt tänkande

- ge ett exempel från det dagliga livet för var och en av följande: positiv förstärkning, negativ förstärkning, positiv straff, negativ straff.

- Tänk på de förstärkningstekniker som du kan använda för att träna en hund att fånga och hämta en Frisbee som du kastar till den.

- titta på följande två videor från aktuella TV-program. Kan du bestämma vilka inlärningsförfaranden som demonstreras?

- kontoret: http://www.break.com/usercontent/2009/11/the-office-altoid-experiment-1499823

- Big Bang-teorin : http://www.youtube.com/watch?v=JA96Fba-WHk

Cerella, J. (1980). Duvans analys av bilder. Mönsterigenkänning, 12, 1-6.

Thorndike, E. L. (1898). Djurintelligens: en experimentell studie av associativa processer hos djur. Washington, DC: American Psychological Association.

Bild Attribut

Figur 8.6: Anpassad från Kassin (2003).