Objetivos de aprendizaje

- Esbozar los principios del condicionamiento operante.

- Explicar cómo se puede moldear el aprendizaje mediante el uso de programas de refuerzo y reforzadores secundarios.

En el condicionamiento clásico, el organismo aprende a asociar nuevos estímulos con respuestas biológicas naturales como la salivación o el miedo. El organismo no aprende algo nuevo, sino que comienza a realizar un comportamiento existente en presencia de una nueva señal. El condicionamiento operante, por otro lado, es un aprendizaje que se produce basado en las consecuencias del comportamiento y puede implicar el aprendizaje de nuevas acciones. El condicionamiento operante ocurre cuando un perro se da la vuelta al mando porque ha sido elogiado por hacerlo en el pasado, cuando un acosador de la escuela amenaza a sus compañeros de clase porque hacerlo le permite salirse con la suya, y cuando un niño obtiene buenas calificaciones porque sus padres amenazan con castigarla si no lo hace. En el condicionamiento operante, el organismo aprende de las consecuencias de sus propias acciones.

Cómo el refuerzo y el Castigo Influyen en el Comportamiento: La investigación de Thorndike y Skinner

El psicólogo Edward L. Thorndike (1874-1949) fue el primer científico en estudiar sistemáticamente el condicionamiento operante. En su investigación, Thorndike (1898) observó gatos que habían sido colocados en una «caja de rompecabezas»de la que trataron de escapar («Video Clip: Thorndike’s Puzzle Box»). Al principio, los gatos se rascaban, mordían y aplastaban al azar, sin tener idea de cómo salir. Pero eventualmente, y accidentalmente, presionaron la palanca que abría la puerta y salieron hacia su premio, un trozo de pescado. La próxima vez que el gato fue encerrado en la caja, intentó menos de las respuestas ineficaces antes de llevar a cabo el escape exitoso, y después de varias pruebas, el gato aprendió a hacer casi inmediatamente la respuesta correcta.

Observar estos cambios en el comportamiento de los gatos llevó a Thorndike a desarrollar su ley de efecto, el principio de que las respuestas que crean un resultado típicamente agradable en una situación particular tienen más probabilidades de volver a ocurrir en una situación similar, mientras que las respuestas que producen un resultado típicamente desagradable tienen menos probabilidades de volver a ocurrir en la situación (Thorndike, 1911). La esencia de la ley del efecto es que las respuestas exitosas, porque son placenteras, son «selladas» por la experiencia y, por lo tanto, ocurren con más frecuencia. Las respuestas fallidas, que producen experiencias desagradables, son «eliminadas» y posteriormente ocurren con menos frecuencia.

Cuando Thorndike colocó a sus gatos en una caja de rompecabezas, descubrió que aprendieron a participar en el importante comportamiento de escape más rápido después de cada prueba. Thorndike describió el aprendizaje que sigue al refuerzo en términos de la ley de efecto.

Reloj: «Caja de rompecabezas de Thorndike» : http://www.youtube.com/watch?v=BDujDOLre-8

Reloj: «Caja de rompecabezas de Thorndike» : http://www.youtube.com/watch?v=BDujDOLre-8

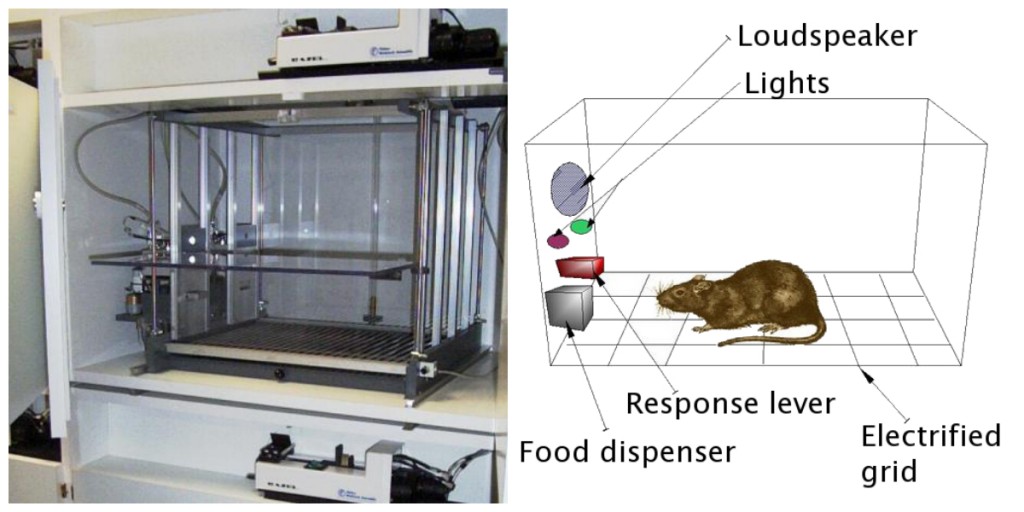

El influyente psicólogo conductual B. F. Skinner (1904-1990) amplió las ideas de Thorndike para desarrollar un conjunto más completo de principios para explicar el condicionamiento operante. Skinner creó ambientes especialmente diseñados conocidos como cámaras operantes (generalmente llamadas cajas Skinner) para estudiar sistemáticamente el aprendizaje. Una caja de desollador (cámara operante) es una estructura lo suficientemente grande como para caber en un roedor o pájaro y que contiene una barra o llave que el organismo puede presionar o picotear para liberar comida o agua. También contiene un dispositivo para registrar las respuestas del animal (Figura 8.5).

El experimento más básico de Skinner fue bastante similar a la investigación de Thorndike con gatos. Una rata colocada en la cámara reaccionó como era de esperar, corriendo por la caja y olfateando y arañando el suelo y las paredes. Finalmente, la rata se topó con una palanca, que presionó para liberar gránulos de comida. La próxima vez, la rata tardó un poco menos en presionar la palanca, y en pruebas sucesivas, el tiempo que tardó en presionar la palanca se hizo cada vez más corto. Pronto la rata presionaba la palanca tan rápido como podía comer la comida que aparecía. Como predijo la ley del efecto, la rata había aprendido a repetir la acción que produjo el alimento y a cesar las acciones que no lo hicieron.

Skinner estudió, en detalle, cómo los animales cambiaban su comportamiento a través del refuerzo y el castigo, y desarrolló términos que explicaban los procesos de aprendizaje operante (Tabla 8.1, «Cómo el Refuerzo y el Castigo Positivos y Negativos Influyen en el Comportamiento»). Skinner usó el término reforzador para referirse a cualquier evento que fortalece o aumenta la probabilidad de un comportamiento, y el término castigador para referirse a cualquier evento que debilita o disminuye la probabilidad de un comportamiento. Y usó los términos positivo y negativo para referirse a si se presentó o eliminó un refuerzo, respectivamente. Por lo tanto, el refuerzo positivo fortalece una respuesta al presentar algo agradable después de la respuesta, y el refuerzo negativo fortalece una respuesta al reducir o eliminar algo desagradable. Por ejemplo, elogiar a un niño por completar su tarea representa un refuerzo positivo, mientras que tomar aspirina para reducir el dolor de un dolor de cabeza representa un refuerzo negativo. En ambos casos, el refuerzo hace que sea más probable que el comportamiento vuelva a ocurrir en el futuro.

| Término de acondicionamiento operante | Descripción | Resultado | Ejemplo |

|---|---|---|---|

| Refuerzo positivo | Añadir o aumentar un estímulo agradable | El comportamiento se fortalece | Dar un premio a un estudiante después de obtener una A en un examen |

| Refuerzo negativo | Reducir o eliminar un estímulo desagradable | El comportamiento se fortalece | Tomar analgésicos que eliminan el dolor aumenta la probabilidad de que tome analgésicos de nuevo |

| Castigo positivo | Presentar o añadir un estímulo desagradable | El comportamiento se debilita | Dar a un estudiante tareas adicionales después de que se porta mal en clase |

| Castigo negativo | Reducir o eliminar un estímulo agradable | El comportamiento se debilita | Quitarle la computadora a un adolescente después de que no toque de queda |

El refuerzo, ya sea positivo o negativo, funciona aumentando la probabilidad de un comportamiento. El castigo, por otra parte, se refiere a cualquier acontecimiento que debilite o reduzca la probabilidad de un comportamiento. El castigo positivo debilita una respuesta al presentar algo desagradable después de la respuesta, mientras que el castigo negativo debilita una respuesta al reducir o eliminar algo agradable. Un niño que está castigado después de pelear con un hermano (castigo positivo) o que pierde la oportunidad de ir al recreo después de obtener una mala calificación (castigo negativo) es menos probable que repita estos comportamientos.

Aunque la distinción entre refuerzo (que aumenta el comportamiento) y castigo (que lo disminuye) suele ser clara, en algunos casos es difícil determinar si un refuerzo es positivo o negativo. En un día caluroso, una brisa fresca podría verse como un refuerzo positivo (porque trae aire frío) o un refuerzo negativo (porque elimina el aire caliente). En otros casos, el refuerzo puede ser tanto positivo como negativo. Uno puede fumar un cigarrillo porque trae placer (refuerzo positivo) y porque elimina el deseo de nicotina (refuerzo negativo).

También es importante tener en cuenta que el refuerzo y el castigo no son simplemente opuestos. El uso del refuerzo positivo para cambiar el comportamiento es casi siempre más eficaz que el castigo. Esto se debe a que el refuerzo positivo hace que la persona o el animal se sienta mejor, lo que ayuda a crear una relación positiva con la persona que proporciona el refuerzo. Los tipos de refuerzo positivo que son efectivos en la vida cotidiana incluyen elogios verbales o aprobación, la concesión de estatus o prestigio y el pago financiero directo. Por otra parte, es más probable que el castigo sólo provoque cambios temporales en el comportamiento, ya que se basa en la coacción y, por lo general, crea una relación negativa y contradictoria con la persona que proporciona el refuerzo. Cuando la persona que impone el castigo abandona la situación, es probable que el comportamiento no deseado vuelva.

Crear comportamientos Complejos a través del Condicionamiento Operante

Tal vez recuerde ver una película o estar en un espectáculo en el que un animal, tal vez un perro, un caballo o un delfín, hizo algunas cosas bastante sorprendentes. El entrenador dio una orden y el delfín nadó hasta el fondo de la piscina, tomó un anillo en su nariz, saltó del agua a través de un aro en el aire, se sumergió de nuevo hasta el fondo de la piscina, tomó otro anillo y luego llevó ambos anillos al entrenador en el borde de la piscina. El animal fue entrenado para hacer el truco, y se utilizaron los principios del condicionamiento operante para entrenarlo. Pero estos comportamientos complejos están muy lejos de las simples relaciones estímulo-respuesta que hemos considerado hasta ahora. ¿Cómo se puede utilizar el refuerzo para crear comportamientos complejos como estos?

Una forma de ampliar el uso del aprendizaje operante es modificar el horario en el que se aplica el refuerzo. Hasta este punto, solo hemos discutido un programa de refuerzo continuo, en el que la respuesta deseada se refuerza cada vez que se produce; cada vez que el perro se da la vuelta, por ejemplo, recibe una galleta. El refuerzo continuo resulta en un aprendizaje relativamente rápido, pero también en una extinción rápida del comportamiento deseado una vez que el reforzador desaparece. El problema es que debido a que el organismo está acostumbrado a recibir el refuerzo después de cada comportamiento, el respondedor puede dar rápidamente cuando no aparece.

La mayoría de los reforzadores del mundo real no son continuos; ocurren en un programa de refuerzo parcial (o intermitente), un programa en el que las respuestas a veces se refuerzan y otras no. En comparación con el refuerzo continuo, los programas de refuerzo parcial conducen a un aprendizaje inicial más lento, pero también conducen a una mayor resistencia a la extinción. Debido a que el refuerzo no aparece después de cada comportamiento, al alumno le toma más tiempo determinar que la recompensa ya no viene, y por lo tanto la extinción es más lenta. Los cuatro tipos de programas de refuerzo parcial se resumen en la Tabla 8.2, » Programas de refuerzo.»

| Programa de refuerzo | Explicación | Ejemplo del mundo real |

|---|---|---|

| El comportamiento de relación fija | se refuerza después de un número específico de respuestas. | Trabajadores de fábrica a los que se les paga de acuerdo con el número de productos que producen |

| El comportamiento de relación variable | se refuerza después de un número de respuestas promedio, pero impredecible. | Pagos de máquinas tragamonedas y otros juegos de azar |

| El comportamiento de intervalo fijo | se refuerza para la primera respuesta una vez transcurrido un tiempo determinado. | Personas que ganan un salario mensual |

| El comportamiento de intervalo variable | se refuerza para la primera respuesta después de que haya pasado un tiempo promedio, pero impredecible. | Persona que comprueba los mensajes de correo electrónico |

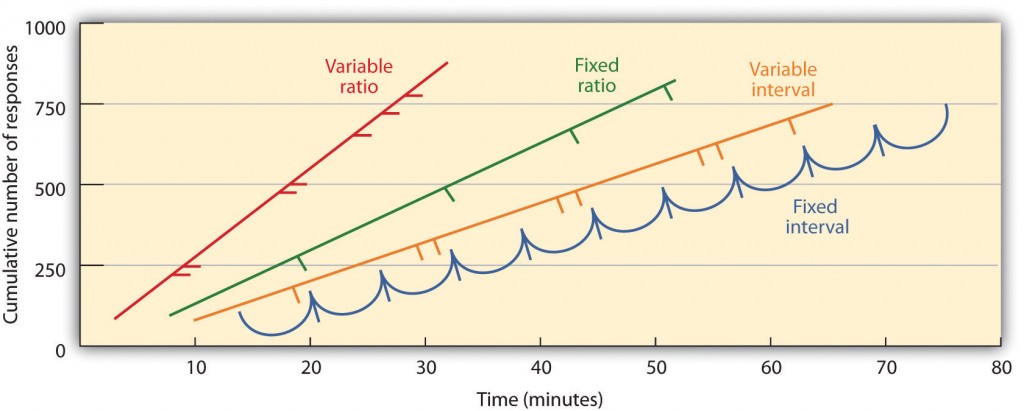

Los programas parciales de refuerzo se determinan por si el refuerzo se presenta en función del tiempo que transcurre entre el refuerzo (intervalo) o en función del número de respuestas que el organismo realiza (proporción), y por si el refuerzo se produce en un programa regular (fijo) o impredecible (variable). En un programa de intervalo fijo, el refuerzo se produce para la primera respuesta realizada después de que haya pasado una cantidad específica de tiempo. Por ejemplo, en un programa de intervalo fijo de un minuto, el animal recibe un refuerzo cada minuto, suponiendo que se involucre en el comportamiento al menos una vez durante el minuto. Como se puede ver en la Figura 8.6, «Ejemplos de Patrones de Respuesta de Animales Entrenados bajo Diferentes Programas de Refuerzo Parcial», los animales bajo programas de intervalo fijo tienden a ralentizar su respuesta inmediatamente después del refuerzo, pero luego aumentan el comportamiento de nuevo a medida que se acerca el momento del siguiente refuerzo. (La mayoría de los estudiantes estudian para los exámenes de la misma manera. En un programa de intervalos variables, los reforzadores aparecen en un programa de intervalos, pero el tiempo varía alrededor del intervalo promedio, lo que hace que la apariencia real del reforzador sea impredecible. Un ejemplo podría ser revisar su correo electrónico: se refuerza al recibir mensajes que, en promedio, por ejemplo, cada 30 minutos, pero el refuerzo se produce solo en momentos aleatorios. Los programas de refuerzo de intervalos tienden a producir tasas de respuesta lentas y constantes.

En un programa de proporción fija, un comportamiento se refuerza después de un número específico de respuestas. Por ejemplo, el comportamiento de una rata puede reforzarse después de haber presionado una tecla 20 veces, o un vendedor puede recibir un bono después de haber vendido 10 productos. Como se puede ver en la Figura 8.6, «Ejemplos de Patrones de Respuesta de Animales Entrenados bajo Diferentes Programas de Refuerzo Parcial», una vez que el organismo ha aprendido a actuar de acuerdo con el programa de proporción fija, se detendrá solo brevemente cuando se produzca el refuerzo antes de regresar a un alto nivel de respuesta. Un programa de proporción variable proporciona reforzadores después de un número específico pero promedio de respuestas. Ganar dinero de máquinas tragamonedas o en un boleto de lotería es un ejemplo de refuerzo que se produce en un horario de proporción variable. Por ejemplo, una máquina tragamonedas (ver Figura 8.7, «Máquina tragamonedas») se puede programar para proporcionar una ganancia cada 20 veces que el usuario tire de la manija, en promedio. Los programas de proporción tienden a producir altas tasas de respuesta porque el refuerzo aumenta a medida que aumenta el número de respuestas.

Los comportamientos complejos también se crean a través de la conformación, el proceso de guiar el comportamiento de un organismo hacia el resultado deseado mediante el uso de la aproximación sucesiva a un comportamiento final deseado. Skinner hizo un uso extensivo de este procedimiento en sus cajas. Por ejemplo, podría entrenar a una rata para presionar una barra dos veces para recibir comida, proporcionando primero comida cuando el animal se movía cerca de la barra. Cuando se había aprendido ese comportamiento, Skinner comenzaba a proporcionar comida solo cuando la rata tocaba la barra. El modelado adicional limitaba el refuerzo a solo cuando la rata presionaba la barra, a cuando presionaba la barra y la tocaba por segunda vez, y finalmente a solo cuando presionaba la barra dos veces. Aunque puede llevar mucho tiempo, de esta manera el condicionamiento operante puede crear cadenas de comportamientos que se refuerzan solo cuando se completan.

Reforzar a los animales si discriminan correctamente entre estímulos similares permite a los científicos probar la capacidad de aprendizaje de los animales, y las discriminaciones que pueden hacer a veces son notables. Las palomas han sido entrenadas para distinguir entre imágenes de Charlie Brown y los otros personajes de Peanuts (Cerella, 1980), y entre diferentes estilos de música y arte (Porter & Neuringer, 1984; Watanabe, Sakamoto & Wakita, 1995).Los comportamientos

también se pueden entrenar mediante el uso de reforzadores secundarios. Mientras que un reforzador primario incluye estímulos que el organismo prefiere o disfruta naturalmente, como alimentos, agua y alivio del dolor, un reforzador secundario (a veces llamado reforzador condicionado) es un evento neutro que se ha asociado con un reforzador primario a través del acondicionamiento clásico. Un ejemplo de un reforzador secundario sería el silbato dado por un entrenador de animales, que se ha asociado con el tiempo con el reforzador primario, la comida. Un ejemplo de refuerzo secundario cotidiano es el dinero. Disfrutamos de tener dinero, no tanto para el estímulo en sí, sino para los reforzadores primarios (las cosas que el dinero puede comprar) con las que está asociado.

Conclusiones clave

- Edward Thorndike desarrolló la ley del efecto: el principio de que las respuestas que crean un resultado típicamente agradable en una situación particular tienen más probabilidades de volver a ocurrir en una situación similar, mientras que las respuestas que producen un resultado típicamente desagradable tienen menos probabilidades de volver a ocurrir en la situación.

- B. F. Skinner amplió las ideas de Thorndike para desarrollar un conjunto de principios para explicar el condicionamiento operante.

- El refuerzo positivo fortalece una respuesta al presentar algo que es típicamente agradable después de la respuesta, mientras que el refuerzo negativo fortalece una respuesta al reducir o eliminar algo que es típicamente desagradable.

- El castigo positivo debilita una respuesta al presentar algo típicamente desagradable después de la respuesta, mientras que el castigo negativo debilita una respuesta al reducir o eliminar algo que es típicamente agradable.

- El refuerzo puede ser parcial o continuo. Los programas parciales de refuerzo se determinan por si el refuerzo se presenta en función del tiempo que transcurre entre los refuerzos (intervalo) o en función del número de respuestas que el organismo realiza (proporción), y por si el refuerzo se produce en un programa regular (fijo) o impredecible (variable).

- Se pueden crear comportamientos complejos a través de la conformación, el proceso de guiar el comportamiento de un organismo hacia el resultado deseado mediante el uso de una aproximación sucesiva a un comportamiento final deseado.

Ejercicios y Pensamiento Crítico

- Dé un ejemplo de la vida diaria de cada uno de los siguientes: refuerzo positivo, refuerzo negativo, castigo positivo, castigo negativo.

- Considere las técnicas de refuerzo que podría usar para entrenar a un perro para atrapar y recuperar un disco volador que le arroje.

- Vea los siguientes dos videos de programas de televisión actuales. ¿Puede determinar qué procedimientos de aprendizaje se están demostrando?

- La Oficina: http://www.break.com/usercontent/2009/11/the-office-altoid – experimento-1499823

- La Teoría del Big Bang : http://www.youtube.com/watch?v=JA96Fba-WHk

Cerella, J. (1980). El análisis de imágenes de la paloma. Reconocimiento de patrones, 12, 1-6.

Thorndike, E. L. (1898). Inteligencia animal: Estudio experimental de los procesos asociativos en animales. Washington, DC: American Psychological Association.

Atribuciones de imagen

Figura 8.6: Adaptado de Kassin (2003).