când un YouTuber proeminent pe nume Lewis Hilsenteger (alias „Unbox Therapy”) testa noul model de iPhone din această toamnă, XS, a observat ceva: pielea lui era foarte netedă în camera selfie frontală a dispozitivului, mai ales în comparație cu modelele mai vechi de iPhone. Hilsenteger a comparat-o cu un fel de machiaj digital. „Nu arăt așa”, a spus el într-un videoclip care demonstrează fenomenul. „Este ciudat … arăt de parcă aș purta fond de ten.”

nu este singurul care a observat efectul, deși Apple nu a recunoscut că face ceva diferit decât a făcut-o înainte. Vorbind ca un utilizator iPhone de lungă durată și fotograf amator, mi se pare incontestabil faptul că modul portret—o tehnologie de marcă în cea mai recentă ediție a celor mai populare telefoane din lume—a strălucit. Peste săptămâni de a lua fotografii cu dispozitivul, am dat seama că aparatul de fotografiat a trecut un prag între fotografie și fauxtograph. Nu am fost atât de mult „a lua fotografii” ca telefonul a fost sintetizarea lor.

acesta nu este un fenomen cu totul nou: fiecare cameră digitală folosește algoritmi pentru a transforma diferitele lungimi de undă ale luminii care lovesc senzorul său într-o imagine reală. Oamenii au căutat întotdeauna o lumină bună. În era smartphone-urilor, aplicațiile de la Snapchat la FaceApp la Beauty Plus s-au oferit să vă actualizeze fața. Alte telefoane au un defect-eliminarea „modul de frumusete”, puteți activa sau dezactiva, de asemenea. Ceea ce face remarcabilă netezirea pielii iPhone XS este că este pur și simplu implicită pentru cameră. Fă-ți un selfie și asta primești.

aceste imagini nu sunt false, exact. Dar, de asemenea, nu sunt imagini așa cum au fost înțelese în zilele dinainte de a face fotografii cu un computer.

ceea ce s-a schimbat este acesta: camerele știu prea multe. Toate camerele captează informații despre lume—în trecut, acestea erau înregistrate de substanțe chimice care interacționau cu fotonii și, prin definiție, o fotografie era o expunere, scurtă sau lungă, a unui senzor la lumină. Acum, sub capotă, camerele telefonice trag informații de la mai multe intrări de imagine într-o singură ieșire de imagine, împreună cu desenarea pe rețele neuronale instruite să înțeleagă scenele la care sunt îndreptate. Folosind aceste alte informații, precum și o expunere individuală, computerul sintetizează imaginea finală, tot mai automat și invizibil.

mai multe povești

miza poate fi mare: inteligența artificială facilitează sintetizarea videoclipurilor în altele noi, fictive, adesea numite „deepfakes”.”În curând vom trăi într-o lume în care ochii noștri ne înșală în mod obișnuit”, a scris Colegul meu Franklin Foer. „Altfel spus, nu suntem atât de departe de prăbușirea realității.”Deepfakes sunt o modalitate de topire a realității; altul schimbă fotografia simplă a telefonului de la o aproximare decentă a realității pe care o vedem cu ochii noștri la ceva mult diferit. Este o temperatură omniprezentă și scăzută, dar nu mai puțin eficientă. Și, probabil, mult mai important pentru viitorul companiilor de tehnologie.

în How to See the World, savantul Media Nicholas Mirzoeff numește fotografia „o modalitate de a vedea lumea activată de mașini.”Vorbim nu numai despre utilizarea mașinilor, ci și despre” societatea de rețea ” în care produc imagini. Și pentru Mirzoeff, nu există un exemplu mai bun al „noii culturi globale de tineret urbane în rețea” decât selfie-ul.

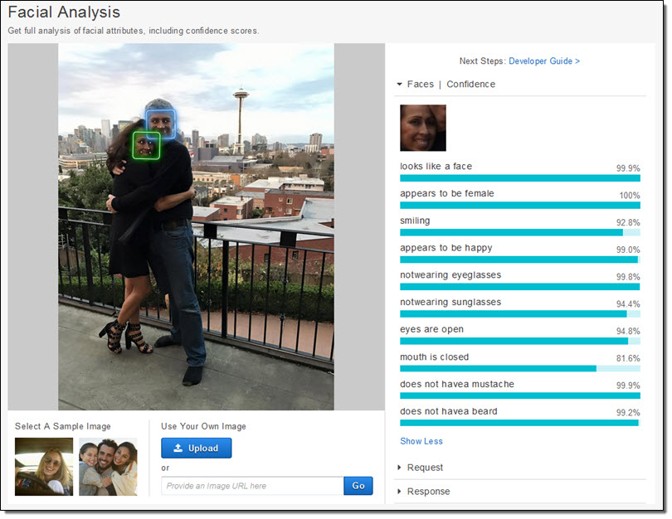

producătorii de telefoane și producătorii de aplicații par să fie de acord că selfie-urile le conduc ecosistemele de afaceri. Au dedicat resurse enorme fotografierii fețelor. Apple a creat literalmente noi cipuri de siliciu pentru a putea, așa cum promite compania, să vă ia în considerare fața „chiar înainte de a trage.”În primul rând, există detectarea facială. Apoi, telefonul se fixează pe „reperele” feței pentru a ști unde sunt ochii și gura și alte caracteristici. În cele din urmă, fața și restul prim-planului sunt cartografiate în profunzime, astfel încât o față să poată ieși din fundal. Toate aceste date sunt disponibile dezvoltatorilor de aplicații, ceea ce reprezintă un motiv pentru proliferarea aplicațiilor pentru manipularea feței, cum ar fi Mug Life, care face fotografii unice și le transformă în videoclipuri false cvasi-realiste la comandă.

toate aceste lucrări, care au fost incredibil de dificile în urmă cu un deceniu și posibile doar pe serverele cloud foarte recent, rulează acum chiar la telefon, așa cum a descris Apple. Compania a instruit un model de învățare automată pentru a găsi fețe într-un număr enorm de imagini. Modelul era însă prea mare, așa că au pregătit o versiune mai mică pe ieșirile primului. Acest truc a făcut posibilă rularea pe un telefon. Fiecare fotografie pe care o face fiecare iPhone este mulțumită, într-o mică parte, acestor milioane de imagini, filtrate de două ori printr-un sistem enorm de învățare automată.

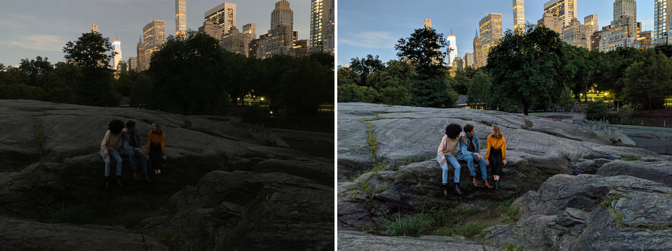

dar nu doar camera știe că există o față și unde sunt ochii. De asemenea, camerele foto captează acum mai multe imagini în acest moment pentru a sintetiza altele noi. Night Sight, o nouă caracteristică pentru Google Pixel, este cel mai bine explicat exemplu al modului în care funcționează acest lucru. Google a dezvoltat noi tehnici pentru combinarea mai multor imagini inferioare (zgomotoase, întunecate) într-o singură imagine superioară (mai curată, mai strălucitoare). Orice fotografie este într-adevăr un amestec de o grămadă de fotografii capturate în jurul expunerii centrale. Dar apoi, ca și în cazul Apple, Google implementează algoritmi de învățare automată peste partea de sus a acestor imagini. Cel pe care compania l—a descris public ajută la echilibrarea albă—care ajută la furnizarea unei culori realiste într-o imagine-la lumină scăzută. De asemenea, a spus Verge că „învățarea sa automată detectează ce obiecte sunt în cadru, iar camera este suficient de inteligentă pentru a ști ce culoare ar trebui să aibă.”Luați în considerare cât de diferit este de o fotografie normală. Camera Google nu captează ceea ce este, ci ceea ce, statistic, este probabil.

fotografierea a devenit tot mai automată. E ca și cum piloții comerciale care zboară avioane: Ele sunt în control manual pentru doar un procent mic dintr-o călătorie dată. Nostru telefon-calculator-camere perfect, estompa invizibil distincțiile dintre lucrurile pe care o camera poate face și lucruri pe care un computer poate face. Există continuități cu tehnici preexistente, desigur, dar numai dacă complotați progresul fotografiei digitale pe un fel de scară logaritmică.

High-dynamic range, sau HDR, fotografia a devenit populară în anii 2000, dominând site-ul timpuriu de partajare a fotografiilor Flickr. Fotografii au capturat mai multe (de obicei trei) imagini ale aceleiași scene la expuneri diferite. Apoi, au stivuit imaginile una peste alta și au luat informațiile despre umbre din cea mai strălucitoare fotografie și informațiile despre cele mai importante momente din cea mai întunecată fotografie. Puneți-le pe toate împreună și ar putea genera o suprarealitate frumoasă. În mâinile potrivite, o fotografie HDR ar putea crea o scenă care seamănă mult mai mult cu ceea ce văd ochii noștri decât ceea ce produc în mod normal majoritatea camerelor.

ochii noștri, în special în condiții de luminozitate variabilă, pot compensa dinamic. Încercați să faceți o fotografie a lunii, de exemplu. Luna în sine este foarte strălucitoare și, dacă încercați să faceți o fotografie cu ea, trebuie să o expuneți ca și cum ar fi amiază înaltă. Dar noaptea este întunecată, evident, și astfel pentru a obține o imagine a lunii cu detalii, restul scenei este în esență negru. Ochii noștri pot vedea atât luna, cât și peisajul pământesc fără nicio problemă.

Google și Apple doresc să facă procesul HDR la fel de automat ca ajustările ochilor noștri. Au încorporat HDR în camerele lor implicite, desenând dintr-o explozie de imagini (Google folosește până la 15). HDR a devenit pur și simplu modul în care sunt făcute fotografiile pentru majoritatea oamenilor. Ca și în cazul netezirii pielii, nu mai contează cu adevărat dacă asta ar vedea ochii noștri. Scopul unor produse noi este de a depăși abilitățile vizuale impresionante ale corpului nostru. „Scopul Night Sight este de a face fotografii ale scenelor atât de întunecate încât nu le poți vedea clar cu ochii tăi — aproape ca o super-putere!”Google scrie.

începând cu secolul al 19-lea, camerele au reușit să capteze imagini la viteze, lungimi de undă și măriri diferite, care dezvăluie lumi ascunse anterior. Ceea ce este fascinant despre schimbările actuale în fotografie telefon este că acestea sunt la fel de mult despre dezvăluie ceea ce vrem să arate ca acestea sunt investigații ale lumii. Este ca și cum am fi descoperit o sondă pentru găsirea și împărtășirea versiunilor fețelor noastre—sau chiar a noastră—și este acest proces care conduce acum comportamentul celor mai inovatoare și mai profitabile companii din lume.

între timp, companiile și guvernele pot face altceva cu fața ta: creează tehnologii de recunoaștere facială care transformă orice cameră într-o mașină de supraveghere. Google s-a angajat să nu vândă un produs de „recunoaștere facială de uz general” până când problemele etice cu tehnologia nu vor fi rezolvate, dar Amazon Rekognition este disponibil acum, la fel ca Microsoft Face API, pentru a nu spune nimic despre eforturile și mai extinse ale companiilor chineze de internet.

economia globală este legată de fața ta. Și este dispus să mute cerul și pământul pentru a vă permite să vedeți ceea ce doriți să vedeți.