kiedy wybitny YouTuber Lewis Hilsenteger (aka „terapia Unbox”) testował nowy model iPhone 'a tej jesieni, XS, zauważył coś: jego skóra była wyjątkowo gładka w przedniej kamerze selfie urządzenia, zwłaszcza w porównaniu ze starszymi modelami iPhone’ a. Hilsenteger porównał go do rodzaju cyfrowego makijażu. „Nie wyglądam tak”, powiedział w filmie demonstrującym zjawisko. „To dziwne … wyglądam jakbym nosił podkład.”

nie tylko on zauważył efekt, chociaż Apple nie przyznał, że robi coś innego niż wcześniej. Mówiąc jako wieloletni użytkownik iPhone ’ a i fotograf amator, uważam za niezaprzeczalne, że tryb portretowy—technologia marquee w najnowszym wydaniu najpopularniejszych telefonów na świecie—został zaćmiony. Po tygodniach robienia zdjęć za pomocą urządzenia zdałem sobie sprawę, że aparat przekroczył próg między fotografią a sfałszowaniem. Nie tyle „robiłam zdjęcia”, co Telefon je syntetyzował.

nie jest to zupełnie nowe zjawisko: każdy aparat cyfrowy wykorzystuje algorytmy do przekształcania różnych długości fal światła, które trafiają w jego czujnik, w rzeczywisty obraz. Ludzie zawsze szukali dobrego światła. W erze smartfonów, aplikacje od Snapchat do FaceApp do Beauty Plus oferują ulepszenie twarzy. Inne telefony mają wadę-eliminując „tryb urody”, który można włączyć lub wyłączyć. Co sprawia, że wygładzanie skóry iPhone ’ a XS jest niezwykłe, że jest to po prostu domyślne dla aparatu. Zrób sobie selfie i tyle dostaniesz.

te obrazy nie są fałszywe, dokładnie. Ale nie są to również zdjęcia, tak jak były rozumiane w czasach przed zrobieniem zdjęć z komputerem.

co się zmieniło to: Kamery wiedzą za dużo. Wszystkie kamery rejestrują informacje o świecie—w przeszłości były rejestrowane przez chemikalia oddziałujące z fotonami, a z definicji fotografia była jedną ekspozycją, krótką lub długą, czujnika na światło. Teraz, pod maską, kamery telefoniczne pobierają informacje z wielu wejść obrazu do jednego wyjścia obrazu, wraz z rysowaniem na sieciach neuronowych przeszkolonych do rozumienia scen, w które są skierowane. Korzystając z tych innych informacji, a także indywidualnej ekspozycji, komputer syntetyzuje końcowy obraz, coraz bardziej automatycznie i niewidocznie.

więcej historii

stawka może być wysoka: sztuczna inteligencja ułatwia syntezę filmów w nowe, fikcyjne, często nazywane „deepfakes”.”Wkrótce będziemy żyć w świecie, w którym nasze oczy rutynowo nas zwodzą” – napisał mój kolega Franklin Foer. „Mówiąc inaczej, nie jesteśmy tak daleko od upadku rzeczywistości.”Deepfakes to jeden ze sposobów topienia rzeczywistości; innym jest zmiana prostej fotografii telefonicznej z przyzwoitego przybliżenia rzeczywistości, którą widzimy naszymi oczami, na coś znacznie innego. Jest wszechobecna i niska temperatura, ale nie mniej skuteczna. I prawdopodobnie o wiele ważniejsze dla przyszłości firm technologicznych.

w „jak zobaczyć świat”, medioznawca Nicholas Mirzoeff nazywa fotografię ” sposobem widzenia świata umożliwionym przez maszyny.”Mówimy nie tylko o użyciu maszyn, ale o „społeczeństwie sieciowym”, w którym produkują obrazy. Dla Mirzoeffa nie ma lepszego przykładu „nowej sieciowej, miejskiej globalnej kultury młodzieżowej” niż selfie.

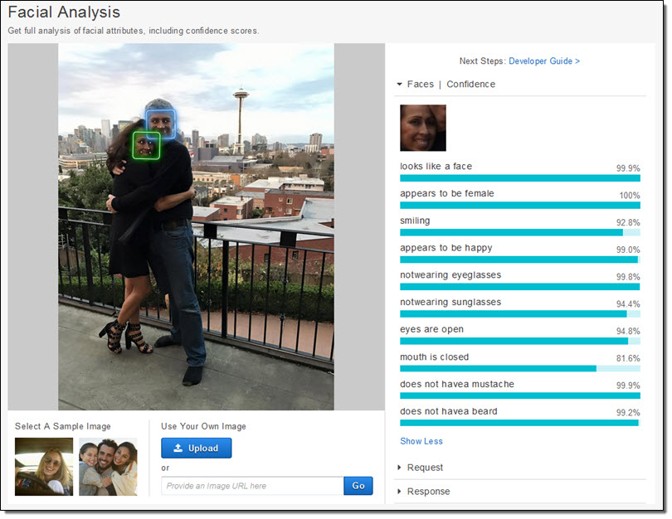

producenci telefonów i twórcy aplikacji wydają się zgadzać, że selfie napędzają ich ekosystemy biznesowe. Poświęcili ogromne środki na robienie zdjęć twarzy. Apple dosłownie stworzył nowe chipy silikonowe, aby móc, jak obiecuje firma, rozważyć swoją twarz ” jeszcze przed strzałem.”Po pierwsze, jest wykrywanie twarzy. Następnie telefon naprawia „punkty orientacyjne” twarzy, aby wiedzieć, gdzie są oczy i usta oraz inne funkcje. Na koniec twarz i reszta pierwszego planu są odwzorowane w głębi, dzięki czemu twarz może wyskoczyć z tła. Wszystkie te dane są dostępne dla twórców aplikacji, co jest jednym z powodów proliferacji aplikacji do manipulowania twarzą, takich jak Mug Life, który robi pojedyncze zdjęcia i zamienia je w quasi-realistyczne fałszywe filmy na polecenie.

cała ta praca, która była niezwykle trudna dziesięć lat temu, a możliwa tylko na serwerach w chmurze bardzo niedawno, teraz działa bezpośrednio na telefonie, jak opisał Apple. Firma wytrenowała jeden model uczenia maszynowego, aby znaleźć twarze w ogromnej liczbie obrazów. Model był jednak zbyt duży, więc na wyjściach pierwszej wytrenowano mniejszą wersję. Ta sztuczka sprawiła, że uruchamianie jej przez telefon było możliwe. Każde zdjęcie, które robi każdy iPhone, jest w niewielkiej części zasługą tych milionów zdjęć, przefiltrowanych dwukrotnie przez ogromny system uczenia maszynowego.

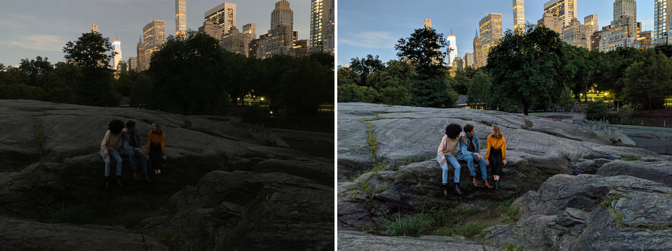

ale nie chodzi tylko o to, że aparat wie, że jest twarz i gdzie są oczy. Kamery również teraz przechwytywania wielu obrazów w chwili syntezy nowych. Night Sight, nowa funkcja Google Pixel, jest najlepiej wyjaśnionym przykładem tego, jak to działa. Google opracowało nowe techniki łączenia wielu gorszych (głośnych, ciemnych) obrazów w jeden lepszy (czystszy, jaśniejszy) obraz. Każde zdjęcie jest naprawdę mieszanką kilku zdjęć zrobionych wokół centralnej ekspozycji. Ale potem, podobnie jak w przypadku Apple, Google wdraża algorytmy uczenia maszynowego nad tymi obrazami. Ta, którą firma opisała publicznie, pomaga w balansowaniu bieli – co pomaga uzyskać realistyczny kolor na zdjęciu-w słabym świetle. Powiedział również The Verge, że ” jego uczenie maszynowe wykrywa, jakie obiekty znajdują się w kadrze, a aparat jest wystarczająco inteligentny, aby wiedzieć, jaki kolor mają mieć.”Zastanów się, jak różni się to od normalnego zdjęcia. Kamera Google nie rejestruje tego, co jest, ale co statystycznie jest prawdopodobne.

robienie zdjęć stało się coraz bardziej automatyczne. To jak piloci komercyjni latający samolotami: Są one pod ręczną kontrolą tylko przez niewielki procent danej podróży. Nasz telefon-komputer-Aparaty bezproblemowo, niewidocznie zacierają różnice między tym, co może zrobić Kamera, a tym, co może zrobić komputer. Oczywiście istnieją ciągłości z wcześniej istniejącymi technikami, ale tylko wtedy, gdy narysujesz postęp fotografii cyfrowej w jakiejś logarytmicznej skali.

high-dynamic range, czyli HDR, fotografia stała się popularna w 2000 roku, dominując na wczesnej stronie Flickr do udostępniania zdjęć. Fotografowie zarejestrowali wiele (zwykle trzy) zdjęć tej samej sceny przy różnych ekspozycjach. Następnie układali obrazy jeden na drugim i pobierali informacje o cieniach z najjaśniejszego Zdjęcia i informacje o pasemkach z najciemniejszego zdjęcia. Złącz je wszystkie razem i mogą wygenerować piękną surrealność. W odpowiednich rękach zdjęcie HDR może stworzyć scenę, która jest o wiele bardziej podobna do tego, co widzą nasze oczy, niż to, co zwykle produkuje większość aparatów.

nasze oczy, zwłaszcza w Warunkach zmiennej jasności, mogą kompensować dynamicznie. Spróbuj zrobić zdjęcie księżyca, na przykład. Sam księżyc jest bardzo jasny, a jeśli spróbujesz zrobić mu zdjęcie, musisz go odsłonić, jakby było w samo południe. Ale noc jest oczywiście ciemna, więc aby uzyskać obraz księżyca ze szczegółami, reszta sceny jest zasadniczo czarna. Nasze oczy bez problemu widzą zarówno księżyc, jak i ziemski krajobraz.

zarówno Google, jak i Apple chcą, aby proces HDR był tak automatyczny, jak korekty naszych oczu. Włączyli HDR do swoich domyślnych kamer, czerpiąc z serii zdjęć (Google używa do 15). HDR stał się po prostu sposobem robienia zdjęć dla większości ludzi. Podobnie jak w przypadku wygładzania skóry, nie ma już znaczenia, czy to, co zobaczyłyby nasze oczy. Celem niektórych nowych produktów jest przekroczenie imponujących zdolności wizualnych naszego ciała. „Celem Night Sight jest zrobienie zdjęć scen tak ciemnych, że nie widać ich wyraźnie na własne oczy-prawie jak super-moc!”Google pisze.

od XIX wieku kamery były w stanie rejestrować obrazy z różnymi prędkościami, długościami fal i powiększeniami, które ujawniają wcześniej ukryte światy. Fascynujące w obecnych zmianach w fotografii telefonicznej jest to, że chodzi o ujawnienie tego, jak chcemy wyglądać, tak samo jak o badanie świata. To tak, jakbyśmy odkryli sondę do znajdowania i dzielenia się wersjami naszych twarzy-a nawet nas samych-i to właśnie ten proces napędza teraz zachowanie najbardziej innowacyjnych, najbardziej dochodowych firm na świecie.

tymczasem firmy i rządy mogą zrobić coś innego z twoją twarzą: stworzyć technologie rozpoznawania twarzy, które zamienią każdą kamerę w maszynę do nadzoru. Google zobowiązało się nie sprzedawać produktu „ogólnego przeznaczenia do rozpoznawania twarzy”, dopóki nie zostaną rozwiązane kwestie etyczne związane z technologią, ale Amazon Recognition jest już dostępny, podobnie jak interfejs Face API Microsoftu, nie mówiąc już o jeszcze szerszych wysiłkach chińskich firm internetowych.

globalna gospodarka jest podłączona do twojej twarzy. I jest gotów poruszyć niebo i ziemię, aby pozwolić Ci zobaczyć to, co chcesz zobaczyć.