Cuando un prominente YouTuber llamado Lewis Hilsenteger (también conocido como «Terapia Unbox») estaba probando el nuevo modelo de iPhone de este otoño, el XS, notó algo: Su piel era extra suave en la cámara de selfies frontal del dispositivo, especialmente en comparación con los modelos de iPhone más antiguos. Hilsenteger lo comparó con una especie de maquillaje digital. «No me veo así», dijo en un video que demuestra el fenómeno. «Eso es raro look me veo como si estuviera usando una base.»

Tampoco es el único que ha notado el efecto, aunque Apple no ha reconocido que está haciendo algo diferente de lo que ha hecho antes. Hablando como usuario de iPhone desde hace mucho tiempo y fotógrafo aficionado, encuentro innegable que el modo Retrato, una tecnología de marquesina en la última edición de los teléfonos más populares del mundo, se ha vuelto brillante. Durante semanas de tomar fotos con el dispositivo, me di cuenta de que la cámara había cruzado un umbral entre la fotografía y el fauxtógrafo. No estaba tanto «tomando fotos» como el teléfono las estaba sintetizando.

Este fenómeno no es totalmente nuevo: Cada cámara digital utiliza algoritmos para transformar las diferentes longitudes de onda de luz que impactan en su sensor en una imagen real. La gente siempre ha buscado la buena luz. En la era de los teléfonos inteligentes, las aplicaciones de Snapchat, FaceApp y Beauty Plus se han ofrecido para mejorar tu rostro. Otros teléfonos tienen un «modo de belleza» que elimina defectos y que también puedes activar o desactivar. Lo que hace que el suavizado de la piel del iPhone XS sea notable es que es simplemente el valor predeterminado para la cámara. Tómate una selfie, y eso es lo que obtienes.

Estas imágenes no son falsas, exactamente. Pero tampoco son imágenes como se entendían en los días anteriores a tomar fotografías con una computadora.

Lo que ha cambiado es esto: Las cámaras saben demasiado. Todas las cámaras capturan información sobre el mundo: en el pasado, se registraba mediante productos químicos que interactuaban con fotones y, por definición, una fotografía era una exposición, corta o larga, de un sensor a la luz. Ahora, bajo el capó, las cámaras de los teléfonos extraen información de múltiples entradas de imagen en una salida de imagen, junto con el dibujo de redes neuronales entrenadas para comprender las escenas a las que están apuntando. Usando esta otra información, así como una exposición individual, la computadora sintetiza la imagen final, cada vez más automática e invisible.

Más historias

Las apuestas pueden ser altas: la inteligencia artificial hace que sea fácil sintetizar videos en nuevos y ficticios, a menudo llamados «deepfakes».»Pronto viviremos en un mundo donde nuestros ojos nos engañan rutinariamente», escribió mi colega Franklin Foer. «Dicho de otra manera, no estamos tan lejos del colapso de la realidad.»Los Deepfakes son una forma de derretir la realidad; otra es cambiar la simple fotografía telefónica de una aproximación decente de la realidad que vemos con nuestros ojos a algo muy diferente. Es ubicuo y de baja temperatura, pero no menos efectivo. Y probablemente mucho más importante para el futuro de las empresas tecnológicas.

En Cómo ver el mundo, el experto en medios Nicholas Mirzoeff llama a la fotografía » una forma de ver el mundo habilitada por las máquinas.»Estamos hablando no solo del uso de máquinas, sino de la «sociedad en red» en la que producen imágenes. Y para Mirzoeff, no hay mejor ejemplo de la «nueva cultura juvenil global urbana en red» que el selfie.

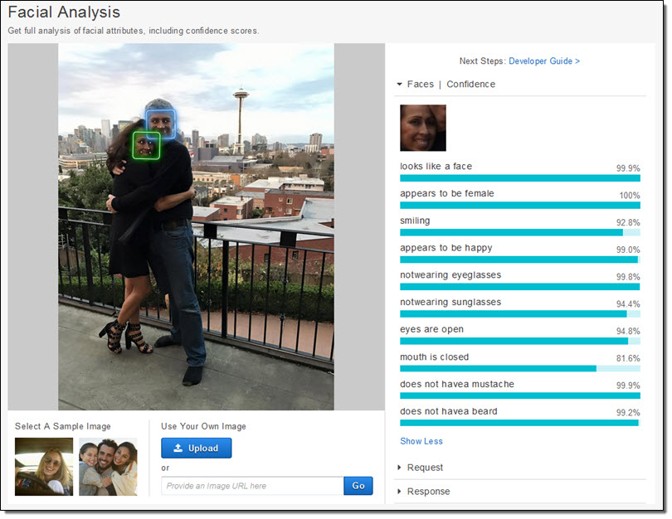

Los fabricantes de teléfonos y de aplicaciones parecen estar de acuerdo en que los selfies impulsan sus ecosistemas empresariales. Han dedicado enormes recursos a tomar fotos de caras. Apple ha creado literalmente nuevos chips de silicio para poder, como promete la compañía, considerar tu cara «incluso antes de disparar.»Primero, hay detección facial. Luego, el teléfono fija los «puntos de referencia» de la cara para saber dónde están los ojos, la boca y otras características. Por último, la cara y el resto del primer plano se mapean en profundidad, de modo que una cara pueda salir del fondo. Todos estos datos están disponibles para los desarrolladores de aplicaciones, que es una de las razones de la proliferación de aplicaciones para manipular la cara, como Mug Life, que toma fotos individuales y las convierte en videos falsos cuasi realistas a pedido.

Todo este trabajo, que era increíblemente difícil hace una década, y que solo era posible en servidores en la nube muy recientemente, ahora se ejecuta directamente en el teléfono, como ha descrito Apple. La compañía entrenó a un modelo de aprendizaje automático para encontrar rostros en una enorme cantidad de imágenes. Sin embargo, el modelo era demasiado grande, por lo que entrenaron una versión más pequeña en las salidas del primero. Ese truco hizo posible ejecutarlo en un teléfono. Cada foto que toma cada iPhone es gracias, en una pequeña parte, a estos millones de imágenes, filtradas dos veces a través de un enorme sistema de aprendizaje automático.

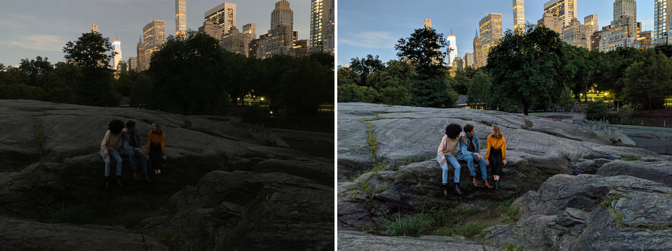

Pero no es solo que la cámara sepa que hay una cara y dónde están los ojos. Las cámaras ahora también capturan varias imágenes en el momento para sintetizar otras nuevas. Night Sight, una nueva función para Google Pixel, es el ejemplo mejor explicado de cómo funciona esto. Google desarrolló nuevas técnicas para combinar múltiples imágenes inferiores (ruidosas, oscuras) en una imagen superior (más limpia, más brillante). Cualquier foto es realmente una mezcla de un montón de fotos capturadas alrededor de la exposición central. Pero luego, al igual que con Apple, Google implementa algoritmos de aprendizaje automático en la parte superior de estas imágenes. El que la compañía ha descrito públicamente ayuda con el equilibrio de blancos, que ayuda a ofrecer un color realista en una imagen, en condiciones de poca luz. También le dijo a The Verge que » su aprendizaje automático detecta qué objetos están en el marco, y la cámara es lo suficientemente inteligente como para saber qué color se supone que tienen.»Considera lo diferente que es eso de una fotografía normal. La cámara de Google no está capturando lo que es, sino lo que, estadísticamente, es probable.

La toma de fotografías se ha vuelto cada vez más automática. Es como pilotos comerciales volando aviones: Están en control manual solo para un pequeño porcentaje de un viaje determinado. Nuestras cámaras de teléfono, computadora y computadora difuminan de manera transparente e invisible las distinciones entre las cosas que una cámara puede hacer y las que una computadora puede hacer. Hay continuidades con técnicas preexistentes, por supuesto, pero solo si se traza el progreso de la fotografía digital en algún tipo de escala logarítmica.

La fotografía de alto rango dinámico, o HDR, se hizo popular en la década de 2000, dominando el primer sitio para compartir fotos Flickr. Los fotógrafos capturaron varias imágenes (generalmente tres) de la misma escena a diferentes exposiciones. Luego, apilaron las imágenes una encima de la otra y tomaron la información sobre las sombras de la foto más brillante y la información sobre los reflejos de la foto más oscura. Ponlos todos juntos, y podrían generar una hermosa surrealidad. En las manos adecuadas, una foto HDR podría crear una escena que se parezca mucho más a lo que ven nuestros ojos que a lo que producen normalmente la mayoría de las cámaras.

Nuestros ojos, especialmente en condiciones de brillo variable, pueden compensar dinámicamente. Trate de tomar una foto de la luna, por ejemplo. La luna es muy brillante, y si intentas tomar una foto de ti, tienes que exponerlo como si fuera mediodía. Pero la noche es oscura, obviamente, por lo que para obtener una imagen de la luna con detalles, el resto de la escena es esencialmente negra. Nuestros ojos pueden ver tanto la luna como el paisaje terrestre sin ningún problema.

Google y Apple quieren que el proceso HDR sea tan automático como los ajustes de nuestros ojos. Han incorporado HDR en sus cámaras predeterminadas, a partir de una ráfaga de imágenes (Google usa hasta 15). HDR se ha convertido simplemente en la forma en que se toman las imágenes para la mayoría de las personas. Al igual que con el alisado de la piel, ya no importa si eso es lo que verían nuestros ojos. El objetivo de algunos productos nuevos es superar las impresionantes capacidades visuales de nuestros propios cuerpos. «El objetivo de Night Sight es hacer fotografías de escenas tan oscuras que no puedas verlas claramente con tus propios ojos, ¡casi como una superpotencia!»Escribe Google.

Desde el siglo XIX, las cámaras han sido capaces de capturar imágenes a diferentes velocidades, longitudes de onda y aumentos, que revelan mundos previamente ocultos. Lo fascinante de los cambios actuales en la fotografía telefónica es que se trata tanto de revelar cómo queremos ser como de investigar el mundo. Es como si hubiéramos descubierto una sonda para encontrar y compartir versiones de nuestras caras, o incluso de nosotros mismos, y es este proceso el que ahora impulsa el comportamiento de las empresas más innovadoras y rentables del mundo.

Mientras tanto, las empresas y los gobiernos pueden hacer algo más con su rostro: crear tecnologías de reconocimiento facial que conviertan cualquier cámara en una máquina de vigilancia. Google se ha comprometido a no vender un producto de «reconocimiento facial de propósito general» hasta que se hayan resuelto los problemas éticos con la tecnología, pero Amazon Rekognition está disponible ahora, al igual que la API Face de Microsoft, por no hablar de los esfuerzos aún más extensos de las empresas chinas de Internet.

La economía global está conectada a tu cara. Y está dispuesto a mover el cielo y la Tierra para que veas lo que quieres ver.