toen een prominente YouTuber genaamd Lewis Hilsenteger (aka “Unbox Therapy”) was het testen van dit najaar nieuwe iPhone-model, de XS, merkte hij iets: zijn huid was extra glad in de voorkant van het apparaat selfie cam, vooral in vergelijking met oudere iPhone-modellen. Hilsenteger vergeleek het met een soort digitale make-up. “Zo zie ik er niet uit”, zei hij in een video die het fenomeen demonstreert. “Dat is raar … ik zie eruit alsof ik foundation draag.”

hij is niet de enige die het effect heeft opgemerkt, hoewel Apple niet heeft erkend dat het iets anders doet dan voorheen. Sprekend als een oude iPhone-gebruiker en amateur-fotograaf, ik vind het onmiskenbaar dat Portrait mode—een marquee-technologie in de nieuwste editie van de meest populaire telefoons in de wereld-heeft gekregen gloeide. In weken van het nemen van foto ‘ s met het apparaat, realiseerde ik me dat de camera een drempel had overschreden tussen foto en fauxtograph. Ik maakte niet zozeer foto ‘ s, maar de telefoon maakte ze.

dit is geen Geheel nieuw fenomeen: elke digitale camera gebruikt algoritmen om de verschillende golflengten van licht die de sensor raken om te zetten in een echt beeld. Mensen hebben altijd goed licht gezocht. In het smartphonetijdperk hebben apps van Snapchat naar FaceApp naar Beauty Plus aangeboden om je gezicht te upgraden. Andere telefoons hebben een fout-het elimineren van “beauty mode” U kunt in-of uitschakelen, ook. Wat maakt de iPhone XS huid-smoothing opmerkelijk is dat het is gewoon de standaard voor de camera. Maak een selfie, en dat is wat je krijgt.

deze beelden zijn niet echt, precies. Maar het zijn ook geen foto ’s zoals ze werden begrepen in de dagen voordat je foto’ s nam met een computer.

wat er is veranderd is dit: de camera ‘ s weten te veel. Alle camera ‘ s leggen informatie vast over de wereld—in het verleden werd het opgenomen door chemische stoffen die met fotonen interageren, en per definitie was een foto één blootstelling, kort of lang, van een sensor aan licht. Nu, onder de motorkap, telefooncamera ‘ s trekken informatie van meerdere beeldingangen in één beelduitvoer, samen met tekenen op neurale netwerken getraind om de scènes te begrijpen waar ze naar worden gericht. Met behulp van deze andere informatie en een individuele belichting, synthetiseert de computer het uiteindelijke beeld, steeds meer automatisch en onzichtbaar.

meer verhalen

de inzet kan hoog zijn: kunstmatige intelligentie maakt het gemakkelijk om video ’s te synthetiseren tot nieuwe, fictieve video’ s die vaak “deepfakes” worden genoemd.””We zullen binnenkort leven in een wereld waar onze ogen routinematig bedriegen ons,” schreef mijn collega Franklin Foer. “Anders gezegd, we zijn niet zo ver van de ineenstorting van de werkelijkheid.”Deepfakes zijn een manier om de realiteit te smelten; een andere is het veranderen van de eenvoudige telefoon foto van een fatsoenlijke benadering van de realiteit die we zien met onze ogen om iets heel anders. Het is alomtegenwoordig en lage temperatuur, maar niet minder effectief. En waarschijnlijk veel belangrijker voor de toekomst van technologiebedrijven.In How to See the World noemt de mediawetenschapper Nicholas Mirzoeff Fotografie ” a way to see the world enabled by machines.”We hebben het niet alleen over het gebruik van machines, maar ook over de “netwerksamenleving” waarin ze beelden produceren. En voor Mirzoeff is er geen beter voorbeeld van de” new genetworked, urban global youth culture ” dan de selfie.

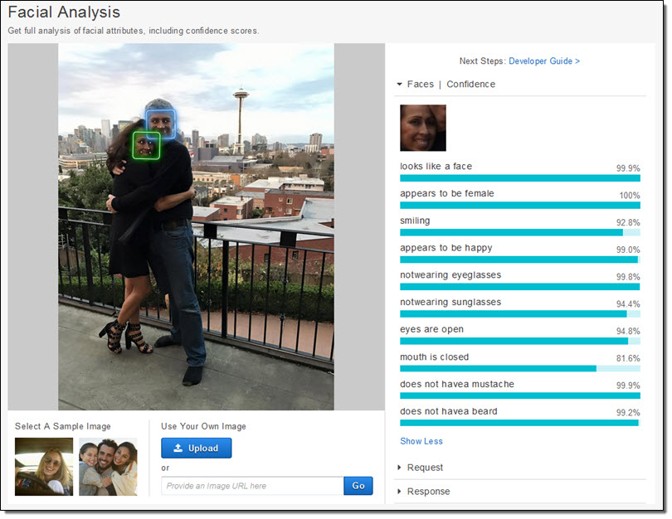

telefoonfabrikanten en app-makers lijken het erover eens te zijn dat selfies hun bedrijfsecosystemen aansturen. Ze hebben enorme middelen ingezet om gezichten te fotograferen. Apple heeft letterlijk nieuwe siliconenchips gemaakt om, zoals het bedrijf belooft, je gezicht te kunnen beschouwen ” zelfs voordat je schiet.”Eerst is er gezichtsdetectie. Dan, de telefoon fixes op het gezicht “oriëntatiepunten” om te weten waar de ogen en mond en andere functies zijn. Tot slot worden het gezicht en de rest van de voorgrond in kaart gebracht, zodat een gezicht uit de achtergrond kan springen. Al deze gegevens zijn beschikbaar voor app-ontwikkelaars, dat is een reden voor de proliferatie van apps om het gezicht te manipuleren, zoals Mok Life, die enkele foto ’s neemt en verandert ze in quasi-realistische nep-video’ s op commando.

al dit werk, dat was ongelooflijk moeilijk een decennium geleden, en alleen mogelijk op cloud servers zeer onlangs, draait nu direct op de telefoon, zoals Apple heeft beschreven. Het bedrijf trainde een machine-learning model om gezichten te vinden in een enorm aantal stukjes beelden. Het model was echter te groot, dus trainden ze een kleinere versie op de uitgangen van de eerste. Die Truc maakte het mogelijk om het via een telefoon te doen. Elke foto die elke iPhone neemt, is in een klein deel te danken aan deze miljoenen beelden, twee keer gefilterd door een enorm machine-learning systeem.

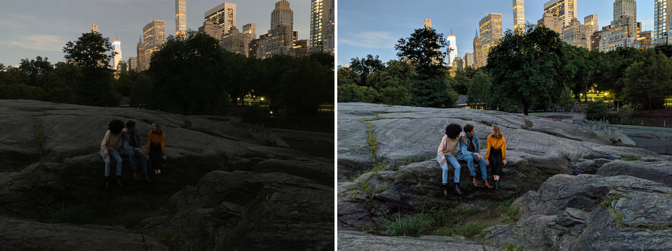

maar het is niet alleen dat de camera weet dat er een gezicht is en waar de ogen zijn. Camera ‘ s leggen nu ook meerdere beelden vast in het moment om nieuwe te synthetiseren. Night Sight, een nieuwe functie voor de Google Pixel, is het best uitgelegd voorbeeld van hoe dit werkt. Google ontwikkelde nieuwe technieken voor het combineren van meerdere inferieure (luidruchtige, donkere) beelden in één superieur (schoner, helderder) beeld. Elke foto is echt een mix van een bos van foto ‘ s genomen rond de centrale blootstelling. Maar dan, net als bij Apple, Google implementeert machine-learning algoritmen over de top van deze beelden. Degene die het bedrijf in het openbaar heeft beschreven helpt met witbalanceren – wat helpt bij het leveren van realistische kleur in een beeld-bij weinig licht. Het vertelde ook the Verge dat ” zijn machine learning detecteert welke objecten in het frame, en de camera is slim genoeg om te weten welke kleur ze moeten hebben.”Bedenk eens hoe anders dat is dan een normale foto. Google ‘ s camera is niet het vastleggen van Wat is, maar wat, statistisch, is waarschijnlijk.

het maken van foto ‘ s is steeds automatischer geworden. Het is net als commerciële piloten die vliegtuigen vliegen.: Ze zijn in handbediening voor slechts een klein percentage van een bepaalde reis. Onze telefoon-computer-camera ‘ s vervagen naadloos, onzichtbaar het onderscheid tussen dingen die een camera kan doen en dingen die een computer kan doen. Er zijn continuïteiten met reeds bestaande technieken, natuurlijk, maar alleen als je de voortgang van digitale fotografie plot op een soort van logaritmische schaal.High-dynamic range, of HDR, fotografie werd populair in de jaren 2000, domineerde de vroege foto-sharing site Flickr. Fotografen maakten meerdere (meestal drie) beelden van dezelfde scène bij verschillende belichtingen. Vervolgens stapelden ze de beelden op elkaar en namen de informatie over de schaduwen van de helderste foto en de informatie over de hoogtepunten van de donkerste foto. Als je ze allemaal samenvoegt, kunnen ze prachtige surrealiteit genereren. In de juiste handen kan een HDR-foto een scène creëren die veel meer lijkt op wat onze ogen zien dan wat de meeste camera ‘ s normaal produceren.

onze ogen, vooral onder omstandigheden van variabele helderheid, kunnen dynamisch compenseren. Probeer bijvoorbeeld een foto van de maan te nemen. De maan zelf is erg helder, en als je er een foto van probeert te maken, moet je hem blootstellen alsof het hoog middag is. Maar de nacht is donker, natuurlijk, en dus om een beeld van de maan met detail te krijgen, de rest van de scène is in wezen zwart. Onze ogen kunnen zowel de maan als het aardse landschap zonder probleem zien.

Google en Apple willen beide het HDR-proces zo automatisch maken als de aanpassingen van onze ogen. Ze hebben HDR opgenomen in hun standaard camera ‘ s, tekening van een uitbarsting van beelden (Google gebruikt maximaal 15). HDR is gewoon geworden hoe foto ‘ s worden genomen voor de meeste mensen. Net als bij het gladmaken van de huid, maakt het niet meer echt uit of dat is wat onze ogen zouden zien. Het doel van sommige nieuwe producten is om de indrukwekkende visuele vaardigheden van ons eigen lichaam te overtreffen. “Het doel van Night Sight is om foto’ s te maken van scènes die zo donker zijn dat je ze niet duidelijk met je eigen ogen kunt zien — bijna als een superkracht!”Google schrijft.Sinds de 19e eeuw zijn camera ‘ s in staat geweest om beelden vast te leggen met verschillende snelheden, golflengten en vergrotingen, die eerder verborgen werelden onthullen. Wat fascinerend is aan de huidige veranderingen in telefoonfotografie is dat ze net zo veel gaan over het onthullen van hoe we eruit willen zien als het onderzoeken van de wereld zijn. Het is alsof we een sonde hebben ontdekt voor het vinden en delen van versies van onze gezichten—of zelfs onszelf—en het is dit proces dat nu het gedrag van de meest innovatieve, meest winstgevende bedrijven in de wereld drijft.

ondertussen kunnen bedrijven en overheden iets anders met je gezicht doen: gezichtsherkenningstechnologieën maken die van elke camera een bewakingsmachine maken. Google heeft beloofd niet te verkopen een “algemene gezichtsherkenning” product totdat de ethische problemen met de technologie zijn opgelost, maar Amazon Rekognition is nu beschikbaar, net als Microsoft’ s gezicht API, om niets te zeggen van de Chinese internetbedrijven nog meer uitgebreide inspanningen.

de wereldeconomie is op je gezicht gericht. En het is bereid om Hemel en aarde te bewegen om je te laten zien wat je wilt zien.