när en framstående YouTuber som heter Lewis Hilsenteger (aka ”Unbox Therapy”) testade höstens nya iPhone-modell, XS, märkte han något: hans hud var extra slät i enhetens framåtvända selfie-kamera, särskilt jämfört med äldre iPhone-modeller. Hilsenteger jämförde det med en slags digital smink. ”Jag ser inte ut så,” sa han i en video som demonstrerade fenomenet. ”Det är konstigt … jag ser ut som jag bär foundation.”

han är inte den enda som har märkt effekten heller, även om Apple inte har erkänt att det gör något annat än tidigare. Talar som en långvarig iPhone—användare och amatörfotograf, tycker jag att det är obestridligt att Portrait mode—en markeringsteknik i den senaste utgåvan av de mest populära telefonerna i världen—har blivit glödd upp. Under veckor av att ta bilder med enheten, jag insåg att kameran hade passerat en tröskel mellan fotografi och fauxtograph. Jag var inte så mycket” ta bilder ” som telefonen syntetiserade dem.

Detta är inte ett helt nytt fenomen: varje digitalkamera använder algoritmer för att omvandla de olika våglängderna av ljus som träffar sensorn till en verklig bild. Människor har alltid sökt bra ljus. I smartphone-eran har appar från Snapchat till FaceApp till Beauty Plus erbjudit sig att uppgradera ditt ansikte. Andra telefoner har ett fel-eliminera” skönhetsläge ” du kan slå på eller av, för. Det som gör iPhone XS hudutjämning anmärkningsvärd är att det helt enkelt är standard för kameran. Ta en selfie, och det är vad du får.

dessa bilder är inte falska, exakt. Men de är inte heller bilder som de förstod dagarna innan du tog fotografier med en dator.

vad som har förändrats är detta: kamerorna vet för mycket. Alla kameror fångar information om världen—tidigare registrerades det av kemikalier som interagerade med fotoner, och per definition var ett fotografi en exponering, kort eller lång, av en sensor för ljus. Nu, under huven, drar telefonkameror information från flera bildingångar till en bildutgång, tillsammans med att dra på neurala nätverk utbildade för att förstå scenerna de pekar på. Med hjälp av denna Andra information såväl som en individuell exponering syntetiserar datorn den slutliga bilden, allt mer automatiskt och osynligt.

fler berättelser

insatserna kan vara höga: artificiell intelligens gör det enkelt att syntetisera videor till nya, fiktiva som ofta kallas ”deepfakes.””Vi kommer snart att leva i en värld där våra ögon rutinmässigt lurar oss”, skrev min kollega Franklin Foer. ”Sätt annorlunda, vi är inte så långt från verklighetens kollaps.”Deepfakes är ett sätt att smälta verkligheten; en annan förändrar det enkla telefonfotot från en anständig approximation av den verklighet vi ser med våra ögon till något mycket annorlunda. Det är allestädes närvarande och låg temperatur, men inte mindre effektiv. Och förmodligen mycket viktigare för Teknikföretagens framtid.

i hur man ser världen kallar mediaforskaren Nicholas Mirzoeff fotografi ”ett sätt att se världen möjliggjort av maskiner.”Vi pratar om inte bara användningen av maskiner, men ”nätverkssamhället” där de producerar bilder. Och för Mirzoeff finns det inget bättre exempel på den ”nya nätverkade, urbana globala ungdomskulturen” än selfie.

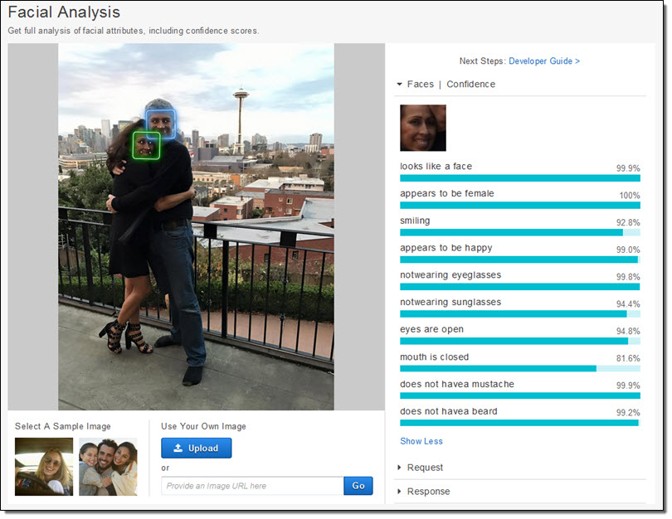

telefontillverkarna och apptillverkarna verkar vara överens om att selfies driver sina affärsekosystem. De har ägnat enorma resurser åt att ta bilder av ansikten. Apple har bokstavligen skapat nya kiselchips för att kunna, som företaget lovar, överväga ditt ansikte ”redan innan du skjuter.”Först finns det ansiktsdetektering. Sedan fixar telefonen på ansiktets” landmärken ” för att veta var ögonen och munnen och andra funktioner är. Slutligen är ansiktet och resten av förgrunden djup mappade, så att ett ansikte kan dyka upp från bakgrunden. Alla dessa data är tillgängliga för apputvecklare, vilket är en anledning till spridningen av appar för att manipulera ansiktet, till exempel Mug Life, som tar enstaka bilder och förvandlar dem till kvasi-realistiska falska Videor på kommando.

allt detta arbete, som var oerhört svårt för ett decennium sedan, och endast möjligt på molnservrar nyligen, körs nu direkt på telefonen, som Apple har beskrivit. Företaget utbildade en maskininlärningsmodell för att hitta ansikten i ett enormt antal bilder. Modellen var dock för stor, så de tränade en mindre version på utgångarna från den första. Det tricket gjorde det möjligt att köra det på en telefon. Varje foto som varje iPhone tar är tack, i någon liten del, till dessa miljoner bilder, filtrerade två gånger genom ett enormt maskininlärningssystem.

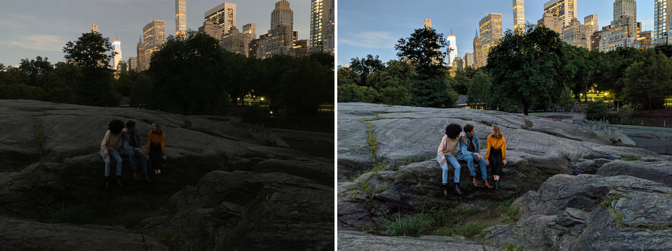

men det är inte bara att kameran vet att det finns ett ansikte och var ögonen är. Kameror tar nu också flera bilder just nu för att syntetisera nya. Night Sight, en ny funktion för Google Pixel, är det bäst förklarade exemplet på hur detta fungerar. Google utvecklade nya tekniker för att kombinera flera sämre (bullriga, mörka) bilder till en överlägsen (renare, ljusare) bild. Varje foto är verkligen en blandning av en massa bilder tagna runt den centrala exponeringen. Men sedan, som med Apple, använder Google maskininlärningsalgoritmer över toppen av dessa bilder. Den som företaget har beskrivit offentligt hjälper till med vitbalansering—vilket hjälper till att leverera realistisk färg i en bild-i svagt ljus. Det berättade också The Verge att ” dess maskininlärning upptäcker vilka objekt som finns i ramen, och kameran är smart nog att veta vilken färg de ska ha.”Tänk på hur annorlunda det är från ett normalt fotografi. Googles kamera fångar inte vad som är, men vad är statistiskt troligt.

bildtagning har blivit allt mer automatisk. Det är som kommersiella piloter som flyger flygplan: De är i manuell kontroll för endast en liten andel av en viss resa. Vår telefon-dator-kameror sömlöst, osynligt sudda ut skillnaderna mellan saker en kamera kan göra och saker en dator kan göra. Det finns kontinuiteter med befintliga tekniker, förstås, men bara om du plottar utvecklingen av digital fotografering på någon form av logaritmisk skala.

High-dynamic range, eller HDR, blev fotografering populär på 2000-talet och dominerade den tidiga fotodelningssidan Flickr. Fotografer fångade flera (vanligtvis tre) bilder av samma scen vid olika exponeringar. Sedan staplade de bilderna ovanpå varandra och tog informationen om skuggorna från det ljusaste fotot och informationen om höjdpunkterna från det mörkaste fotot. Sätt ihop dem alla, och de kan skapa vacker surrealitet. I rätt händer kan ett HDR-foto skapa en scen som är mycket mer som vad våra ögon ser än vad de flesta kameror normalt producerar.

våra ögon, särskilt under förhållanden med variabel ljusstyrka, kan kompensera dynamiskt. Försök att ta en bild av månen, till exempel. Månen själv är väldigt ljus, och om du försöker ta ett foto av det måste du avslöja det som om det var hög middagstid. Men natten är mörk, självklart, och för att få en bild av månen med detaljer är resten av scenen väsentligen svart. Våra ögon kan se både månen och det jordiska landskapet utan problem.

Google och Apple vill båda göra HDR-processen så Automatisk som våra ögons justeringar. De har införlivat HDR i sina standardkameror och ritat från en bildbyte (Google använder upp till 15). HDR har blivit helt enkelt hur bilder tas för de flesta. Som med hudutjämningen spelar det inte längre någon roll om det är vad våra ögon skulle se. Vissa nya produkters mål är att överträffa våra egna kroppars imponerande visuella förmågor. ”Målet med Night Sight är att göra fotografier av scener så Mörka att du inte kan se dem tydligt med dina egna ögon — nästan som en supermakt!”Google skriver.

sedan 19-talet har kameror kunnat ta bilder med olika hastigheter, våglängder och förstoringar, vilket avslöjar tidigare dolda världar. Det som är fascinerande med de nuvarande förändringarna i telefonfotografering är att de handlar lika mycket om att avslöja hur vi vill se ut som de är undersökningar av världen. Det är som om vi har upptäckt en sond för att hitta och dela versioner av våra ansikten—eller till och med oss själva—och det är den här processen som nu driver beteendet hos de mest innovativa och mest lönsamma företagen i världen.

samtidigt kan företag och regeringar göra något annat med ditt ansikte: skapa ansiktsigenkänningstekniker som gör vilken kamera som helst till en övervakningsmaskin. Google har lovat att inte sälja en ”generell ansiktsigenkänning”-produkt tills de etiska problemen med tekniken har lösts, men Amazon Rekognition är tillgänglig nu, liksom Microsofts Face API, för att inte säga något om Kinesiska internetföretagens ännu mer omfattande ansträngningar.

den globala ekonomin är kopplad till ditt ansikte. Och det är villigt att flytta himmel och jord för att låta dig se vad du vill se.