Quando um proeminente YouTuber chamado Lewis Hilsenteger (aka “Unbox Terapia”) foi o teste de outono do novo modelo de iPhone, o XS, ele notou uma coisa: Sua pele era extremamente lisa no dispositivo de frente selfie cam, especialmente se comparado com os antigos modelos de iPhone. O Hilsenteger comparou-a com uma espécie de Maquilhagem digital. “Eu não pareço assim”, disse ele em um vídeo demonstrando o fenômeno. “Que estranho, parece que estou a usar alicerces.”

ele não é o único que notou o efeito, também, embora a Apple não tenha reconhecido que está fazendo algo diferente do que fez antes. Falando como um usuário de iPhone de longa data e fotógrafo amador, eu acho inegável que o modo Retrato—uma tecnologia Marquesa na última edição dos telefones mais populares do mundo—ficou brilhando. Ao longo de semanas a tirar fotos com o dispositivo, percebi que a câmara tinha atravessado um limiar entre a fotografia e o fauxtógrafo. Não estava a tirar fotografias, mas o telefone estava a sintetizá-las.

este não é um fenômeno totalmente novo: cada câmera digital usa algoritmos para transformar os diferentes comprimentos de onda de luz que atingiu seu sensor em uma imagem real. As pessoas sempre procuraram boa luz. Na era do smartphone, aplicativos do Snapchat ao FaceApp ao Beauty Plus se ofereceram para atualizar seu rosto. Outros telefones têm uma falha-eliminando “modo de beleza” que você pode ligar ou desligar, também. O que faz o smoothing de pele do iPhone XS notável é que é simplesmente o padrão para a câmera. Tira uma selfie e é isso que ganhas.

estas imagens não são falsas, exactamente. Mas eles também não são fotos como eles foram entendidos nos dias antes que você tirou fotografias com um computador.

o que mudou foi isto: as câmaras sabem demasiado. Todas as câmeras capturam informações sobre o mundo—no passado, foi gravado por químicos interagindo com fótons, e por definição, uma fotografia era uma exposição, curta ou longa, de um sensor à luz. Agora, sob o capô, Câmeras de telefone puxam informações de várias entradas de imagem em uma saída de imagem, juntamente com desenho em redes neurais treinadas para entender as cenas para as quais estão sendo apontadas. Usando esta outra informação, bem como uma exposição individual, o computador sintetiza a imagem final, cada vez mais automática e invisível.

More Stories

The stakes can be high: Artificial intelligence makes it easy to synthesize videos into new, ficticious ones often called ” deepfakes.”Em breve viveremos num mundo onde os nossos olhos nos enganam rotineiramente”, escreveu o meu colega Franklin Foer. “Dito de outra forma, não estamos tão longe do colapso da realidade.”Deepfakes são uma maneira de derreter a realidade; outra é mudar a simples fotografia do telefone de uma aproximação decente da realidade que vemos com nossos olhos para algo muito diferente. É onipresente e a baixa temperatura, mas não menos eficaz. E provavelmente muito mais importante para o futuro das empresas de tecnologia.

em Como ver o mundo, o estudioso da mídia Nicholas Mirzoeff chama a fotografia de “uma maneira de ver o mundo habilitado pelas máquinas”.”Estamos falando não só do uso de máquinas, mas da” sociedade de rede ” na qual elas produzem imagens. E para Mirzoeff, não há melhor exemplo da” nova cultura urbana global da juventude em rede ” do que a selfie.

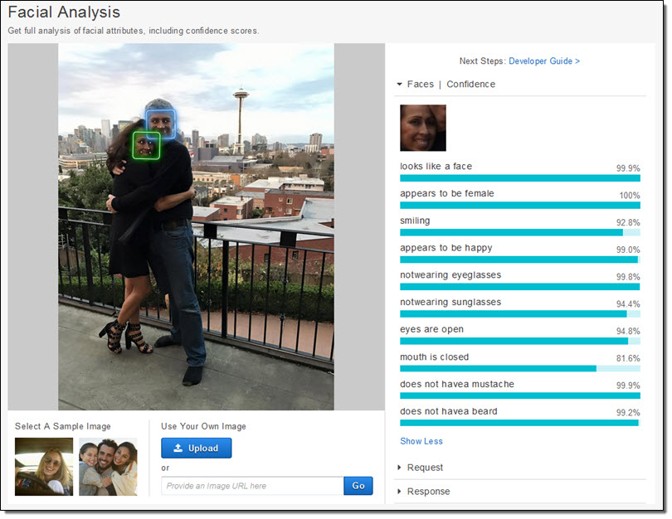

os fabricantes de telefones e fabricantes de aplicativos parecem concordar que selfies guiam seus ecossistemas de negócios. Eles dedicaram enormes recursos para tirar fotos de caras. A Apple literalmente criou novos chips de silício para ser capaz de, como a empresa promete, considerar o seu rosto “mesmo antes de atirar.”Primeiro, há detecção facial. Em seguida, o telefone fixa em “marcos” do rosto para saber onde os olhos e boca e outras características são. Finalmente, o rosto e o resto do primeiro plano são mapeados de profundidade, de modo que um rosto pode sair do fundo. Todos esses dados estão disponíveis para desenvolvedores de aplicativos, o que é uma razão para a proliferação de aplicativos para manipular o rosto, como o Mug Life, que tira fotos individuais e os transforma em vídeos falsos quase realistas sob comando.

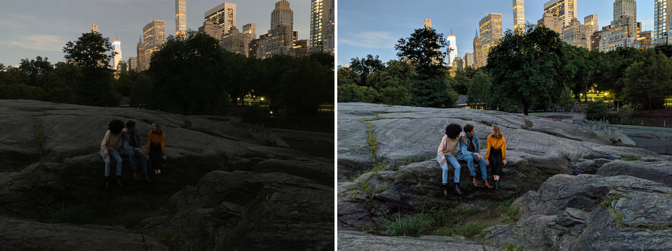

todo esse trabalho, que foi incrivelmente difícil há uma década, e possível apenas em servidores de nuvem muito recentemente, agora funciona exatamente ao telefone, como a Apple descreveu. A empresa treinou um modelo de aprendizado de máquina para encontrar rostos em um enorme número de peças de imagens. O modelo era muito grande, então eles treinaram uma versão menor sobre as saídas da primeira. Esse truque tornou possível executá-lo num telefone. Cada foto que cada iPhone tira é graças, em uma pequena parte, a esses milhões de imagens, filtradas duas vezes através de um enorme sistema de aprendizagem de máquinas. Mas não é só que a câmara sabe que há um rosto e onde estão os olhos. As câmeras também agora capturam várias imagens no momento para sintetizar novas. Visão noturna, um novo recurso para o Google Pixel, é o melhor exemplo explicado de como isso funciona. O Google desenvolveu novas técnicas para combinar múltiplas imagens inferiores (ruidosas, escuras) em uma imagem superior (mais limpa, mais brilhante). Qualquer foto é realmente uma mistura de um monte de fotos capturadas em torno da exposição central. Mas então, como com a Apple, o Google implanta algoritmos de aprendizagem de máquinas no topo dessas imagens. O que a empresa descreveu publicamente ajuda com o equilíbrio branco—o que ajuda a entregar a cor realista em uma imagem-em luz baixa. Ele também disse ao Verge que ” seu aprendizado de máquina detecta quais objetos estão no quadro, e a câmera é inteligente o suficiente para saber que cor eles devem ter.”Considere como isso é diferente de uma fotografia normal. A câmera do Google não está capturando o que é, mas o que, estatisticamente, é provável.

a tomada de fotografias tornou-se cada vez mais automática. É como pilotos comerciais a pilotar aviões.: Eles estão em controle manual para apenas uma pequena porcentagem de uma determinada viagem. Nossas câmeras de telefone-computador-perfeitamente, invisivelmente turva as distinções entre as coisas que uma câmera pode fazer e as coisas que um computador pode fazer. Há continuidades com técnicas pré-existentes, é claro, mas só se você traçar o progresso da fotografia digital em algum tipo de escala logarítmica.

High-dynamic range, ou HDR, a fotografia tornou-se popular na década de 2000, dominando o início do site de compartilhamento de fotos Flickr. Os fotógrafos capturaram várias (geralmente três) imagens da mesma cena em diferentes exposições. Em seguida, eles empilharam as imagens em cima um do outro e tiraram a informação sobre as sombras da foto mais brilhante e a informação sobre os destaques da foto mais escura. Juntá-los todos, e eles poderiam gerar uma bela surrealidade. Nas mãos certas, uma foto HDR poderia criar uma cena que é muito mais parecida com o que nossos olhos vêem do que o que a maioria das câmeras normalmente produzem.

os nossos olhos, especialmente em condições de brilho variável, podem compensar dinamicamente. Tente tirar uma foto da Lua, por exemplo. A lua em si é muito brilhante, e se você tentar tirar uma foto dela, você tem que expô-la como se fosse meio-dia. Mas a noite é escura, obviamente, e assim para obter uma foto da lua com detalhes, o resto da cena é essencialmente Negra. Nossos olhos podem ver a lua e a paisagem terrestre sem problemas.

Google e Apple ambos querem fazer o processo HDR tão automático quanto os ajustes dos nossos olhos. Eles incorporaram HDR em suas câmeras padrão, desenhando a partir de uma explosão de imagens (o Google usa até 15). HDR tornou-se simplesmente como as fotos são tiradas para a maioria das pessoas. Tal como com o alisamento da pele, já não importa se é isso que os nossos olhos vêem. O objetivo de alguns novos produtos é superar as impressionantes habilidades visuais de nossos próprios corpos. “O objetivo da Visão Noturna é fazer fotografias de cenas tão escuras que você não pode vê — las claramente com seus próprios olhos-quase como um super-poder!”Google escreve.

desde o século XIX, as câmeras têm sido capazes de capturar imagens em diferentes velocidades, comprimentos de onda e magnificações, que revelam mundos anteriormente ocultos. O que é fascinante sobre as mudanças atuais na fotografia de telefones é que eles são tanto sobre revelar o que queremos parecer como eles são investigações do mundo. É como se tivéssemos descoberto uma sonda para encontrar e compartilhar versões de nossos rostos—ou até mesmo de nós mesmos—e é esse processo que agora impulsiona o comportamento das empresas mais inovadoras e rentáveis do mundo.