Quando un noto YouTuber di nome Lewis Hilsenteger (aka “Unbox Therapy”) stava testando il nuovo modello di iPhone di questo autunno, l’XS, ha notato qualcosa: la sua pelle era extra liscia nella selfie cam frontale del dispositivo, specialmente rispetto ai vecchi modelli di iPhone. Hilsenteger lo ha paragonato a una sorta di trucco digitale. “Non sembro così”, ha detto in un video che dimostra il fenomeno. “Questo è strano look sembro indossare fondazione.”

Non è l’unico che ha notato l’effetto, anche se Apple non ha riconosciuto che sta facendo qualcosa di diverso da quello che ha prima. Parlando come un utente di iPhone di lunga data e fotografo dilettante, trovo innegabile che la modalità Ritratto-una tecnologia tendone nell’ultima edizione dei telefoni più popolari al mondo—ha ottenuto brillato. Nel corso di settimane di scattare foto con il dispositivo, mi sono reso conto che la fotocamera aveva varcato una soglia tra fotografia e fauxtograph. Non stavo tanto “scattando foto” quanto il telefono le stava sintetizzando.

Questo non è un fenomeno totalmente nuovo: ogni fotocamera digitale utilizza algoritmi per trasformare le diverse lunghezze d’onda della luce che colpiscono il suo sensore in un’immagine reale. Le persone hanno sempre cercato una buona luce. Nell’era degli smartphone, le app da Snapchat a FaceApp a Beauty Plus si sono offerte di aggiornare il tuo viso. Altri telefoni hanno un difetto-eliminando “modalità di bellezza” è possibile attivare o disattivare, anche. Ciò che rende notevole la levigatura della pelle di iPhone XS è che è semplicemente l’impostazione predefinita per la fotocamera. Scatta un selfie, ed è quello che ottieni.

Queste immagini non sono false, esattamente. Ma non sono anche immagini come sono state intese nei giorni prima di scattare fotografie con un computer.

Ciò che è cambiato è questo: le telecamere sanno troppo. Tutte le telecamere catturano informazioni sul mondo—in passato, è stato registrato da sostanze chimiche che interagiscono con i fotoni, e per definizione, una fotografia era una esposizione, breve o lungo, di un sensore alla luce. Ora, sotto il cofano, le telecamere del telefono estraggono informazioni da più input di immagini in un’unica uscita, insieme a disegnare su reti neurali addestrate per capire le scene a cui vengono puntate. Utilizzando queste altre informazioni e un’esposizione individuale, il computer sintetizza l’immagine finale, in modo sempre più automatico e invisibile.

Altre storie

La posta in gioco può essere alta: l’intelligenza artificiale rende facile sintetizzare video in nuovi, quelli fittizi spesso chiamati “deepfakes.”Vivremo a breve in un mondo in cui i nostri occhi ci ingannano abitualmente”, ha scritto il mio collega Franklin Foer. “In altre parole, non siamo così lontani dal crollo della realtà.”I deepfake sono un modo per fondere la realtà; un altro sta cambiando la semplice fotografia del telefono da un’approssimazione decente della realtà che vediamo con i nostri occhi a qualcosa di molto diverso. È onnipresente e a bassa temperatura, ma non per questo meno efficace. E probabilmente molto più importante per il futuro delle aziende tecnologiche.

In How to See the World, lo studioso dei media Nicholas Mirzoeff definisce la fotografia “un modo per vedere il mondo abilitato dalle macchine.”Stiamo parlando non solo dell’uso delle macchine, ma della “società di rete” in cui producono immagini. E per Mirzoeff, non c’è esempio migliore della “nuova cultura giovanile globale in rete e urbana” del selfie.

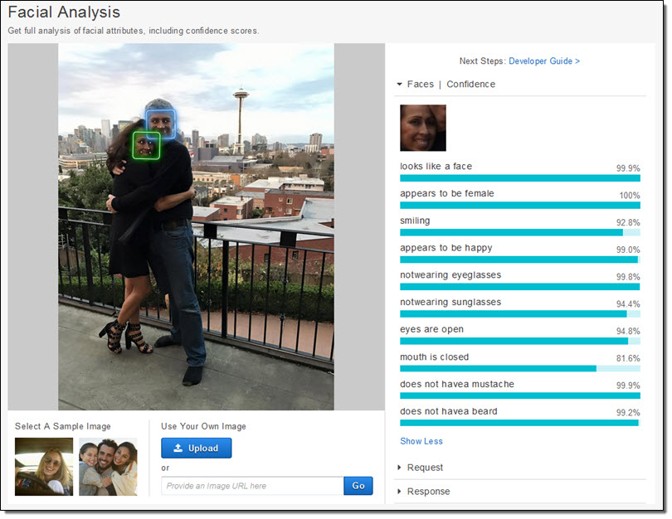

I produttori di telefoni e produttori di app sembrano concordare sul fatto che i selfie guidano i loro ecosistemi aziendali. Hanno dedicato enormi risorse per scattare foto di volti. Apple ha letteralmente creato nuovi chip di silicio per essere in grado di, come promette l’azienda, considerare la tua faccia “anche prima di sparare.”Innanzitutto, c’è il rilevamento facciale. Quindi, il telefono corregge i “punti di riferimento” del viso per sapere dove sono gli occhi e la bocca e altre caratteristiche. Infine, la faccia e il resto del primo piano sono mappati in profondità, in modo che una faccia possa uscire dallo sfondo. Tutti questi dati sono disponibili per gli sviluppatori di app, che è uno dei motivi per la proliferazione di applicazioni per manipolare il volto, come Mug Life, che prende singole foto e li trasforma in video falsi quasi-realistici a comando.

Tutto questo lavoro, che è stato incredibilmente difficile un decennio fa, e possibile solo sui server cloud molto di recente, ora funziona direttamente al telefono, come Apple ha descritto. L’azienda ha addestrato un modello di apprendimento automatico per trovare i volti in un numero enorme di immagini. Il modello era troppo grande, però, così hanno addestrato una versione più piccola sulle uscite del primo. Quel trucco ha reso possibile l’esecuzione su un telefono. Ogni foto ogni iPhone prende è grazie, in qualche piccola parte, a questi milioni di immagini, filtrati due volte attraverso un enorme sistema di machine-learning.

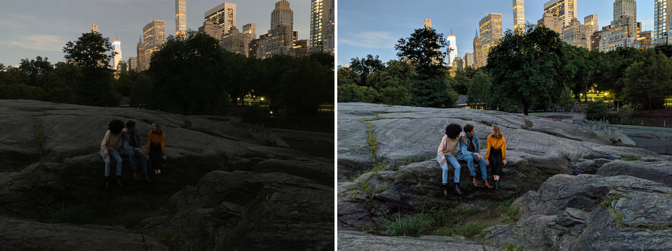

Ma non è solo che la fotocamera sa che c’è un volto e dove sono gli occhi. Le telecamere ora catturano anche più immagini nel momento in cui ne sintetizzano di nuove. Night Sight, una nuova funzionalità per Google Pixel, è l’esempio meglio spiegato di come funziona. Google ha sviluppato nuove tecniche per combinare più immagini inferiori (rumorose, scure) in un’unica immagine superiore (più pulita, più luminosa). Qualsiasi foto è davvero una miscela di un gruppo di foto catturate intorno all’esposizione centrale. Ma poi, come con Apple, Google distribuisce algoritmi di apprendimento automatico sopra la parte superiore di queste immagini. Quello che l’azienda ha descritto pubblicamente aiuta con il bilanciamento del bianco-che aiuta a fornire colori realistici in un’immagine—in condizioni di scarsa illuminazione. Ha anche detto a The Verge che ” il suo apprendimento automatico rileva quali oggetti sono nel frame e la fotocamera è abbastanza intelligente da sapere di che colore dovrebbero avere.”Considera quanto sia diverso da una normale fotografia. La fotocamera di Google non sta catturando ciò che è, ma ciò che, statisticamente, è probabile.

Scattare foto è diventato sempre più automatico. E come piloti commerciali che volano aerei: Sono in controllo manuale solo per una piccola percentuale di un determinato viaggio. Il nostro telefono-computer-telecamere senza soluzione di continuità, invisibilmente offuscare le distinzioni tra le cose che una fotocamera può fare e le cose che un computer può fare. Ci sono continuità con tecniche preesistenti, naturalmente, ma solo se si traccia il progresso della fotografia digitale su una sorta di scala logaritmica.

High-dynamic range, o HDR, la fotografia è diventata popolare negli anni 2000, dominando il primo sito di condivisione di foto Flickr. I fotografi hanno catturato più (di solito tre) immagini della stessa scena a esposizioni diverse. Quindi, hanno accatastato le immagini una sopra l’altra e hanno preso le informazioni sulle ombre dalla foto più luminosa e le informazioni sulle luci dalla foto più scura. Metterli tutti insieme, e potrebbero generare bella surrealità. Nelle mani giuste, una foto HDR potrebbe creare una scena che è molto più simile a ciò che i nostri occhi vedono rispetto a ciò che la maggior parte delle fotocamere normalmente produce.

I nostri occhi, specialmente in condizioni di luminosità variabile, possono compensare dinamicamente. Prova a scattare una foto della luna, per esempio. La luna stessa è molto luminosa, e se provi a scattare una foto, devi esporla come se fosse mezzogiorno. Ma la notte è buia, ovviamente, e quindi per avere un’immagine della luna con dettagli, il resto della scena è essenzialmente nero. I nostri occhi possono vedere sia la luna che il paesaggio terrestre senza problemi.

Google e Apple vogliono entrambi rendere il processo HDR automatico come le regolazioni dei nostri occhi. Hanno incorporato HDR nelle loro fotocamere predefinite, attingendo da una raffica di immagini (Google utilizza fino a 15). HDR è diventato semplicemente come le immagini sono prese per la maggior parte delle persone. Come con la levigatura della pelle, non importa più se è quello che i nostri occhi vedrebbero. L’obiettivo di alcuni nuovi prodotti è quello di superare le capacità visive impressionanti dei nostri corpi. “L’obiettivo di Night Sight è fare fotografie di scene così scure che non puoi vederle chiaramente con i tuoi occhi — quasi come una superpotenza!”Google scrive.

Dal 19 ° secolo, le telecamere sono state in grado di catturare immagini a diverse velocità, lunghezze d’onda e ingrandimenti, che rivelano mondi precedentemente nascosti. Ciò che è affascinante circa gli attuali cambiamenti nella fotografia telefono è che sono tanto di rivelare ciò che vogliamo apparire come sono indagini del mondo. È come se avessimo scoperto una sonda per trovare e condividere versioni dei nostri volti – o anche di noi stessi-ed è questo processo che ora guida il comportamento delle aziende più innovative e più redditizie del mondo.

Nel frattempo, aziende e governi possono fare qualcos’altro con il tuo volto: creare tecnologie di riconoscimento facciale che trasformano qualsiasi telecamera in una macchina di sorveglianza. Google si è impegnata a non vendere un prodotto di “riconoscimento facciale generico” fino a quando non saranno stati risolti i problemi etici con la tecnologia, ma Amazon Rekognition è ora disponibile, così come l’API Face di Microsoft, per non parlare degli sforzi ancora più estesi delle società Internet cinesi.

L’economia globale è collegata al tuo volto. Ed è disposto a spostare il cielo e la Terra per farti vedere ciò che vuoi vedere.