da en fremtredende YouTuber kalt Lewis Hilsenteger (aka «Unbox Therapy») testet ut høstens nye iPhone-modell, XS, la han merke til noe: huden hans var ekstra glatt i enhetens front-facing selfie cam, spesielt sammenlignet med eldre iPhone-modeller. Hilsenteger sammenlignet det med en slags digital sminke. «Jeg ser ikke slik ut,» sa han i en video som demonstrerte fenomenet. «Det er rart … jeg ser ut som om jeg har grunnlag.»

Han er ikke den eneste som har lagt merke til effekten, heller, Selv Om Apple ikke har erkjent At Det gjør noe annerledes enn det har gjort før. Når jeg snakker som en langvarig iPhone-bruker og amatørfotograf, finner jeg det ubestridelig At Portrettmodus—en teltteknologi i den nyeste utgaven av de mest populære telefonene i verden—har blitt glødet opp. Over uker med å ta bilder med enheten, jeg innså at kameraet hadde krysset en terskel mellom fotografi og fauxtograph. Jeg var ikke så mye «å ta bilder» som telefonen syntetiserte dem.

Dette er ikke et helt nytt fenomen: hvert digitalkamera bruker algoritmer for å forvandle de forskjellige bølgelengdene av lys som treffer sensoren til et faktisk bilde. Folk har alltid oppsøkt godt lys. I smarttelefonalderen har apper fra Snapchat Til FaceApp Til Beauty Plus tilbudt å oppgradere ansiktet ditt. Andre telefoner har en feil-eliminere «beauty mode» du kan slå på eller av, også. Det som gjør iPhone XS hudutjevning bemerkelsesverdig er at det bare er standard for kameraet. Ta en selfie, og det er det du får.

disse bildene er ikke falske, akkurat. Men de er heller ikke bilder som de ble forstått i dagene før du tok bilder med en datamaskin.

hva er endret er dette: kameraene vet for mye. Alle kameraer fanger opp informasjon om verden – tidligere ble det registrert av kjemikalier som interagerer med fotoner, og per definisjon var et fotografi en eksponering, kort eller lang, av en sensor til lys. Nå, under hetten, trekker telefonkameraer informasjon fra flere bildeinnganger til en bildeutgang, sammen med tegning av nevrale nettverk trent til å forstå scenene de blir pekt på. Ved hjelp av denne andre informasjonen, samt en individuell eksponering, syntetiserer datamaskinen det endelige bildet, stadig mer automatisk og usynlig.

Flere Historier

innsatsen kan være høy: Kunstig intelligens gjør det enkelt å syntetisere videoer til nye, fiktive som ofte kalles «deepfakes.»Vi vil snart leve i en verden hvor våre øyne rutinemessig lurer oss,» skrev min kollega Franklin Foer. «Sagt på en annen måte, vi er ikke så langt fra sammenbruddet av virkeligheten.»Deepfakes er en måte å smelte virkeligheten på; en annen er å endre det enkle telefonfotografiet fra en anstendig tilnærming av virkeligheten vi ser med øynene til noe mye annet. Det er allestedsnærværende og lav temperatur, men ikke mindre effektiv. Og sannsynligvis mye viktigere for fremtiden for teknologibedrifter.

I How To See The World kaller Medieforskeren Nicholas Mirzoeff fotografering » en måte å se verden aktivert av maskiner.»Vi snakker om ikke bare bruk av maskiner, men «nettverkssamfunnet» der de produserer bilder. Og For Mirzoeff er det ikke noe bedre eksempel på den «nye nettverksbaserte, urbane globale ungdomskulturen» enn selfie.

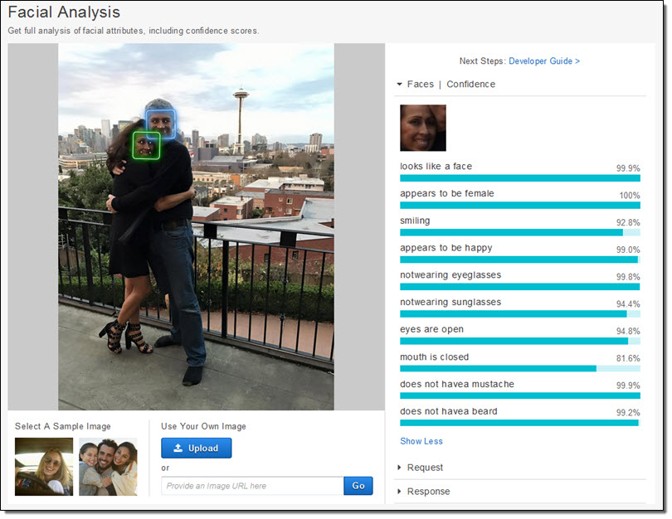

telefonprodusentene og appprodusentene ser ut til å være enige om at selfies driver deres forretningsøkosystemer. De har viet enorme ressurser til å ta bilder av ansikter. Apple har bokstavelig talt skapt nye silisiumchips for å kunne, som selskapet lover, vurdere ansiktet ditt «selv før du skyter.»Først er det ansiktsgjenkjenning . Deretter løser telefonen på ansiktets «landemerker» for å vite hvor øynene og munnen og andre funksjoner er. Til slutt er ansiktet og resten av forgrunnen dybdekartlagt, slik at et ansikt kan komme ut fra bakgrunnen. Alle disse dataene er tilgjengelige for apputviklere, noe som er en grunn til spredning av apper for å manipulere ansiktet, for Eksempel Mug Life, som tar enkeltbilder og gjør dem til kvasi-realistiske falske videoer på kommando.

Alt dette arbeidet, som var utrolig vanskelig for et tiår siden, og bare mulig på skyservere veldig nylig, går nå rett på telefonen, Som Apple har beskrevet. Selskapet trente en maskinlæringsmodell for å finne ansikter i et enormt antall bilder. Modellen var for stor, men de trente en mindre versjon på utgangene til den første. Det trikset gjorde det mulig å kjøre det på en telefon. Hvert bilde hver iPhone tar er takk, i en liten del, til disse millioner av bilder, filtrert to ganger gjennom et enormt maskinlæringssystem.

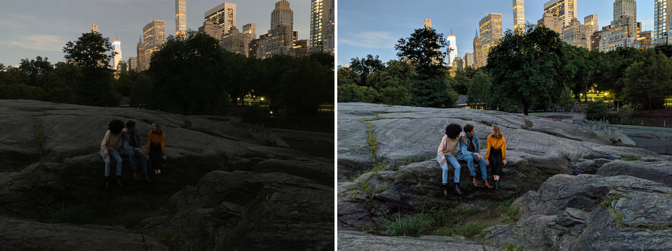

men det er ikke bare at kameraet vet at det er et ansikt og hvor øynene er. Kameraer også nå ta flere bilder i øyeblikket for å syntetisere nye. Night Sight, En ny funksjon For Google Pixel, er det best forklarte eksempelet på hvordan dette fungerer. Google utviklet nye teknikker for å kombinere flere dårligere (støyende, mørke) bilder til ett overlegen (renere, lysere) bilde. Ethvert bilde er virkelig en blanding av en haug med bilder tatt rundt den sentrale eksponeringen. Men Så, Som Med Apple, distribuerer Google maskinlæringsalgoritmer over toppen av disse bildene. Den selskapet har beskrevet offentlig, hjelper med hvitbalansering—som bidrar til å levere realistisk farge i et bilde-i svakt lys. Det fortalte Også The Verge at » maskinlæringen oppdager hvilke objekter som er i rammen, og kameraet er smart nok til å vite hvilken farge de skal ha .»Tenk på hvor forskjellig det er fra et vanlig fotografi . Googles kamera fanger ikke hva som er, men hva er statistisk sannsynlig.

Bildeopptak har blitt stadig mer automatisk. Det er som kommersielle piloter som flyr fly: De er i manuell kontroll for bare en liten prosentandel av en gitt tur. Våre telefon-datamaskin-kameraer sømløst, usynlig viske ut forskjellene mellom ting et kamera kan gjøre og ting en datamaskin kan gjøre. Det er kontinuiteter med eksisterende teknikker, selvfølgelig, men bare hvis du plotter fremdriften av digital fotografering på en slags logaritmisk skala.

High-dynamic range, ELLER HDR, fotografering ble populært på 2000-tallet, dominerende tidlig foto-deling nettstedet Flickr. Fotografer fanget flere (vanligvis tre) bilder av samme scene ved forskjellige eksponeringer. Deretter stablet de bildene oppå hverandre og tok informasjonen om skyggene fra det lyseste bildet og informasjonen om høydepunktene fra det mørkeste bildet. Sett dem alle sammen, og de kunne generere vakker surrealitet. I de rette hender kan ET HDR-bilde skape en scene som er mye mer som det våre øyne ser enn hva de fleste kameraer normalt produserer.

våre øyne, spesielt under forhold med variabel lysstyrke, kan kompensere dynamisk. Prøv å ta et bilde av månen, for eksempel. Månen i seg selv er veldig lys, og hvis du prøver å ta et bilde av det, må du utsette det som om det var høy middag. Men natten er mørk, åpenbart, og for å få et bilde av månen med detaljer, er resten av scenen i hovedsak svart. Våre øyne kan se både månen og det jordiske landskapet uten problem.

Google og Apple vil begge GJØRE HDR-prosessen like automatisk som øynene våre justerer. DE har innlemmet HDR i standardkameraene sine, tegning fra en serie bilder (Google bruker Opptil 15). HDR har blitt ganske enkelt hvordan bilder tas for de fleste. Som med hudutjevning, betyr det ikke lenger noe om det er det våre øyne ville se. Noen nye produkter mål er å overgå våre egne kropper imponerende visuelle evner. «Målet Med Night Sight er å lage fotografier av scener så mørke at du ikke kan se dem klart med dine egne øyne — nesten som en supermakt!»Google skriver.

siden det 19.århundre har kameraer vært i stand til å ta bilder med forskjellige hastigheter, bølgelengder og forstørrelser, som avslører tidligere skjulte verdener. Hva er fascinerende om dagens endringer i telefon fotografering er at de er så mye om å avsløre hva vi ønsker å se ut som de er undersøkelser av verden. Det er som om vi har oppdaget en sonde for å finne og dele versjoner av ansiktene våre-eller til og med oss selv-og det er denne prosessen som nå driver oppførselen til de mest innovative, mest lønnsomme selskapene i verden.

i Mellomtiden kan bedrifter og myndigheter gjøre noe annet med ansiktet ditt: lag ansiktsgjenkjenningsteknologi som gjør et hvilket som helst kamera til en overvåkingsmaskin. Google har lovet å ikke selge et «generell ansiktsgjenkjenning» – produkt før de etiske problemene med teknologien er løst, Men Amazon Rekognition er nå tilgjengelig, som Microsofts Ansikts-API, for ikke å si Noe Om Kinesiske internett-selskapers enda mer omfattende innsats.

den globale økonomien er koblet opp til ansiktet ditt. Og det er villig til å flytte himmel og Jord for å la deg se hva du vil se.