da en fremtrædende YouTuber ved navn Levis Hilsenteger (aka “Unbackterapi”) testede dette efterårs nye iPhone-model, Han bemærkede noget: hans hud var ekstra glat i enhedens frontvendte selfie-cam, især sammenlignet med ældre iPhone-modeller. Hilsenteger sammenlignede det med en slags digital makeup. “Jeg ser ikke sådan ud,” sagde han i en video, der demonstrerede fænomenet. “Det er underligt … jeg ser ud som om jeg har foundation på.”

han er heller ikke den eneste, der har bemærket effekten, selvom Apple ikke har erkendt, at det gør noget andet, end det har gjort før. Når jeg taler som en langvarig iPhone—bruger og amatørfotograf, finder jeg det ubestrideligt, at portrættilstand—en telteteknologi i den seneste udgave af de mest populære telefoner i verden-er blevet glødet op. I løbet af uger med at tage billeder med enheden indså jeg, at kameraet havde krydset en tærskel mellem fotografi og falsk billede. Jeg var ikke så meget “at tage billeder”, da telefonen syntetiserede dem.

dette er ikke et helt nyt fænomen: hvert digitalkamera bruger algoritmer til at omdanne de forskellige bølgelængder af lys, der rammer sin sensor til et faktisk billede. Folk har altid søgt godt lys. I smartphone-æraen har apps fra Snapchat til FaceApp til Beauty Plus tilbudt at opgradere dit ansigt. Andre telefoner har en fejl-eliminere” beauty mode ” Du kan tænde eller slukke, også. Hvad der gør iPhone ‘ s hududjævning bemærkelsesværdig er, at det simpelthen er standard for kameraet. Tag en selfie, og det er hvad du får.

disse billeder er ikke falske, nemlig. Men de er heller ikke billeder, som de blev forstået i dagene før du tog fotografier med en computer.

hvad der er ændret er dette: kameraerne ved for meget. Alle kameraer fanger information om verden—tidligere blev det optaget af kemikalier, der interagerer med fotoner, og per definition var et fotografi en eksponering, kort eller lang, af en sensor til lys. Nu, under hætten, trækker telefonkameraer information fra flere billedindgange til en billedudgang sammen med at trække på neurale netværk, der er uddannet til at forstå de scener, de bliver peget på. Ved hjælp af denne anden information såvel som en individuel eksponering syntetiserer computeren det endelige billede, stadig mere automatisk og usynligt.

flere historier

indsatsen kan være høj: kunstig intelligens gør det nemt at syntetisere videoer til nye, fiktive, ofte kaldet “deepfakes.””Vi vil snart leve i en verden, hvor vores øjne rutinemæssigt bedrager os,” skrev min kollega Franklin foer. “Sagt på en anden måde er vi ikke så langt fra virkelighedens sammenbrud.”Deepfakes er en måde at smelte virkeligheden på; en anden ændrer det enkle telefonfotografi fra en anstændig tilnærmelse af den virkelighed, vi ser med vores øjne, til noget meget anderledes. Det er allestedsnærværende og lav temperatur, men ikke mindre effektiv. Og sandsynligvis meget vigtigere for teknologiselskabernes fremtid.

i hvordan man ser verden, medieforsker Nicholas Mirsoeff kalder fotografering “en måde at se verden aktiveret af maskiner.”Vi taler om ikke kun brugen af maskiner, men “netværkssamfundet”, hvor de producerer billeder. Og for Mirsoeff er der ikke noget bedre eksempel på den “nye netværksmæssige, urbane globale ungdomskultur” end selfie.

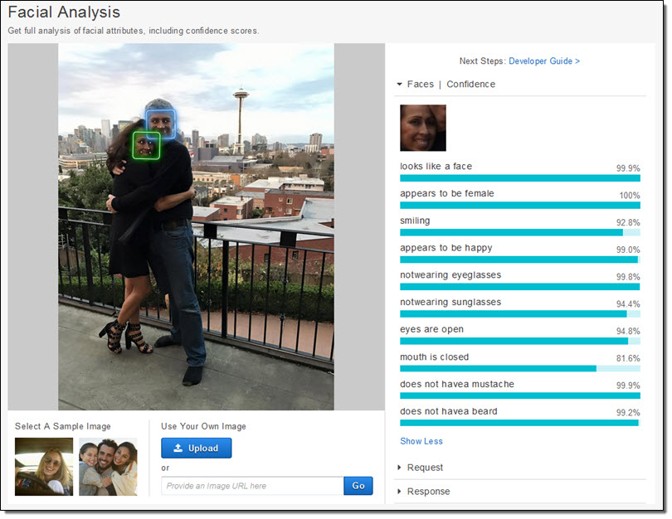

telefonproducenterne og appproducenterne synes at være enige om, at selfies driver deres forretningsøkosystemer. De har dedikeret enorme ressourcer til at tage billeder af ansigter. Apple har bogstaveligt talt skabt nye siliciumchips for at kunne, som virksomheden lover, overveje dit ansigt “selv før du skyder.”For det første er der ansigtsgenkendelse. Derefter løser telefonen på ansigtets” landemærker ” for at vide, hvor øjnene og munden og andre funktioner er. Endelig kortlægges ansigtet og resten af forgrunden dybde, så et ansigt kan springe ud fra baggrunden. Alle disse data er tilgængelige for appudviklere, hvilket er en af grundene til spredningen af apps til at manipulere ansigtet, såsom Mug Life, der tager enkeltbilleder og gør dem til kvasirealistiske falske videoer på kommando.

alt dette arbejde, som var utroligt vanskeligt for et årti siden, og kun muligt på cloud-servere for nylig, kører nu lige på telefonen, som Apple har beskrevet. Virksomheden uddannede en maskinlæringsmodel til at finde ansigter i et enormt antal stykker billeder. Modellen var dog for stor, så de trænede en mindre version på output fra den første. Det trick gjorde det muligt at køre det på en telefon. Hvert foto, som hver iPhone tager, er tak, i en lille del, til disse millioner af billeder, filtreret to gange gennem et enormt maskinlæringssystem.

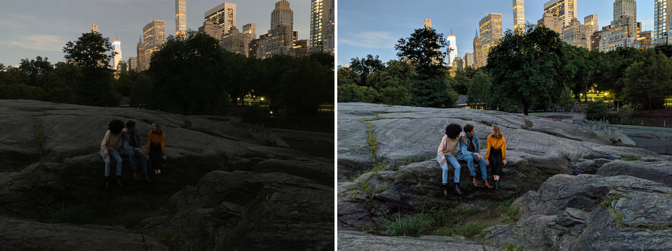

men det er ikke kun, at kameraet ved, at der er et ansigt, og hvor øjnene er. Kameraer optager nu også flere billeder i øjeblikket for at syntetisere nye. Night Sight, en ny funktion til Google, er det bedst forklarede eksempel på, hvordan dette fungerer. Google udviklede nye teknikker til at kombinere flere ringere (støjende, mørke) billeder til et overlegen (renere, lysere) billede. Ethvert foto er virkelig en blanding af en flok fotos taget omkring den centrale eksponering. Men så, som med Apple, anvender Google maskinlæringsalgoritmer over toppen af disse billeder. Den, som virksomheden har beskrevet offentligt, hjælper med hvidbalancering—som hjælper med at levere realistisk farve i et billede-i svagt lys. Det fortalte også The Verge, at ” dens maskinlæring registrerer, hvilke objekter der er i rammen, og kameraet er smart nok til at vide, hvilken farve de skal have.”Overvej, hvor anderledes det er fra et normalt fotografi. Googles kamera fanger ikke, hvad der er, men hvad statistisk set er sandsynligt.

billedoptagelse er blevet mere og mere automatisk. Det er som kommercielle piloter, der flyver fly: De er i manuel kontrol for kun en lille procentdel af en given tur. Vores telefon-computer-kameraer problemfrit, usynligt sløre sondringerne mellem ting et kamera kan gøre, og ting en computer kan gøre. Der er selvfølgelig kontinuiteter med allerede eksisterende teknikker, men kun hvis du plotter fremskridtene med digital fotografering på en slags logaritmisk skala.

High-dynamic range, eller HDR, blev fotografering populær i 2000 ‘ erne og dominerede det tidlige fotodelingssted Flickr. Fotografer fangede flere (normalt tre) billeder af den samme scene ved forskellige eksponeringer. Derefter stablede de billederne oven på hinanden og tog informationen om skyggerne fra det lyseste foto og informationen om højdepunkterne fra det mørkeste foto. Sæt dem alle sammen, og de kunne skabe smuk surrealitet. I de rigtige hænder kunne et HDR-foto skabe en scene, der ligner meget mere, hvad vores øjne ser, end hvad de fleste kameraer normalt producerer.

vores øjne, især under forhold med variabel lysstyrke, kan kompensere dynamisk. Prøv at tage et billede af Månen, for eksempel. Månen selv er meget lys, og hvis du forsøger at tage et billede af det, skal du udsætte det som om det var høj middag. Men natten er mørk, naturligvis, og så for at få et billede af Månen med detaljer, resten af scenen er i det væsentlige sort. Vores øjne kan se både månen og det jordiske landskab uden problemer.

Google og Apple ønsker begge at gøre HDR-processen så automatisk som vores øjne’ justeringer. De har indarbejdet HDR i deres standardkameraer, der tegner fra et udbrud af billeder (Google bruger op til 15). HDR er blevet simpelthen, hvordan billeder tages for de fleste mennesker. Som med hududjævningen betyder det ikke længere noget, hvis det er, hvad vores øjne ville se. Nogle nye produkters mål er at overgå vores egne krops imponerende visuelle evner. “Målet med Night Sight er at gøre fotografier af scener så mørke, at du ikke kan se dem tydeligt med dine egne øjne — næsten som en supermagt!”Google skriver.

siden det 19.århundrede har kameraer været i stand til at optage billeder med forskellige hastigheder, bølgelængder og forstørrelser, som afslører tidligere skjulte verdener. Hvad der er fascinerende ved de aktuelle ændringer i telefonfotografering er, at de handler lige så meget om at afsløre, hvordan vi vil se ud, som de er undersøgelser af verden. Det er som om vi har opdaget en sonde til at finde og dele versioner af vores ansigter—eller endda os selv—og det er denne proces, der nu driver adfærden hos de mest innovative, mest rentable virksomheder i verden.

i mellemtiden kan virksomheder og regeringer gøre noget andet med dit ansigt: Opret ansigtsgenkendelsesteknologier, der gør ethvert kamera til en overvågningsmaskine. Google har lovet ikke at sælge et “almindeligt ansigtsgenkendelsesprodukt”, før de etiske problemer med teknologien er løst, men

den globale økonomi er koblet op til dit ansigt. Og det er villig til at flytte himmel og jord for at lade dig se, hvad du vil se.