Als ein prominenter YouTuber namens Lewis Hilsenteger (alias „Unbox Therapy“) das neue iPhone-Modell XS in diesem Herbst testete, bemerkte er etwas: Seine Haut war in der nach vorne gerichteten Selfie-Kamera des Geräts besonders glatt, insbesondere im Vergleich zu älteren iPhone-Modellen. Hilsenteger verglich es mit einer Art digitalem Make-up. „Ich sehe nicht so aus“, sagte er in einem Video, das das Phänomen demonstrierte. „Das ist seltsam … ich sehe aus, als würde ich Foundation tragen.“

Er ist auch nicht der einzige, der den Effekt bemerkt hat, obwohl Apple nicht anerkannt hat, dass es etwas anderes macht als zuvor. Als langjähriger iPhone-Nutzer und Amateurfotograf finde ich es unbestreitbar, dass der Porträtmodus — eine Festzelt—Technologie in der neuesten Ausgabe der beliebtesten Telefone der Welt – aufleuchtet. Über Wochen des Fotografierens mit dem Gerät wurde mir klar, dass die Kamera eine Schwelle zwischen Fotografie und Fauxtograph überschritten hatte. Ich war nicht so sehr „fotografieren“, wie das Telefon sie synthetisierte.

Das ist kein völlig neues Phänomen: Jede Digitalkamera nutzt Algorithmen, um die verschiedenen Wellenlängen des Lichts, das auf ihren Sensor trifft, in ein tatsächliches Bild umzuwandeln. Die Menschen haben immer gutes Licht gesucht. In der Smartphone-Ära haben Apps von Snapchat über FaceApp bis hin zu Beauty Plus angeboten, Ihr Gesicht zu verbessern. Andere Telefone haben einen Fehler – den „Beauty-Modus“ können Sie auch ein- oder ausschalten. Was die Hautglättung des iPhone XS bemerkenswert macht, ist, dass es einfach der Standard für die Kamera ist. Machen Sie ein Selfie, und das ist, was Sie bekommen.

Diese Bilder sind nicht gefälscht, genau. Aber es sind auch keine Bilder, wie sie in den Tagen vor dem Fotografieren mit einem Computer verstanden wurden.

Was sich geändert hat, ist Folgendes: Die Kameras wissen zu viel. Alle Kameras erfassen Informationen über die Welt — in der Vergangenheit wurden sie von Chemikalien aufgenommen, die mit Photonen interagieren, und per Definition war ein Foto eine kurze oder lange Belichtung eines Sensors mit Licht. Unter der Haube ziehen Telefonkameras Informationen von mehreren Bildeingängen in eine Bildausgabe und zeichnen auf neuronale Netze, die darauf trainiert sind, die Szenen zu verstehen, auf die sie gerichtet sind. Unter Verwendung dieser anderen Informationen sowie einer individuellen Belichtung synthetisiert der Computer das endgültige Bild immer automatischer und unsichtbarer.

Weitere Geschichten

Es kann viel auf dem Spiel stehen: Künstliche Intelligenz macht es einfach, Videos zu neuen, fiktiven Videos zu synthetisieren, die oft als „Deepfakes“ bezeichnet werden.“Wir werden in Kürze in einer Welt leben, in der unsere Augen uns routinemäßig täuschen“, schrieb mein Kollege Franklin Foer. „Anders ausgedrückt, wir sind nicht so weit vom Zusammenbruch der Realität entfernt.“ Deepfakes sind eine Möglichkeit, die Realität zu schmelzen; Eine andere besteht darin, das einfache Telefonfoto von einer anständigen Annäherung an die Realität, die wir mit unseren Augen sehen, in etwas ganz anderes zu verwandeln. Es ist allgegenwärtig und niedrige Temperatur, aber nicht weniger effektiv. Und wahrscheinlich viel wichtiger für die Zukunft von Technologieunternehmen.

In How to See the World nennt der Medienwissenschaftler Nicholas Mirzoeff die Fotografie „eine Möglichkeit, die Welt durch Maschinen zu sehen.“ Wir sprechen nicht nur über den Einsatz von Maschinen, sondern auch über die „Netzwerkgesellschaft“, in der sie Bilder produzieren. Und für Mirzoeff gibt es kein besseres Beispiel für die „neue vernetzte, urbane globale Jugendkultur“ als das Selfie.

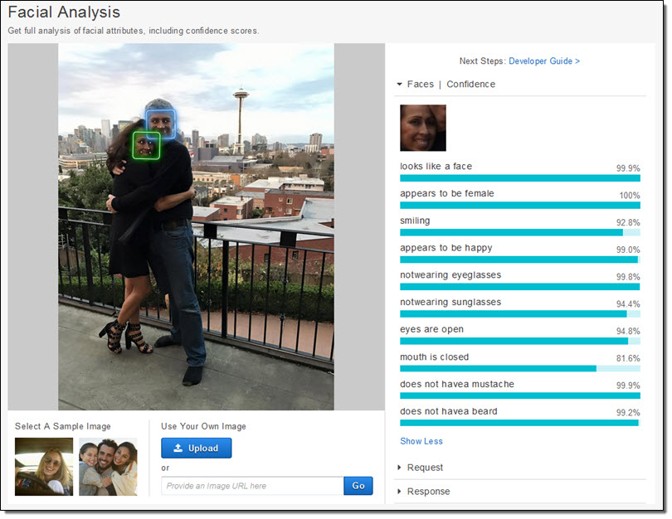

Die Telefonhersteller und App-Hersteller scheinen sich einig zu sein, dass Selfies ihr Geschäftsökosystem antreiben. Sie haben enorme Ressourcen für das Fotografieren von Gesichtern bereitgestellt. Apple hat buchstäblich neue Siliziumchips entwickelt, um, wie das Unternehmen verspricht, Ihr Gesicht zu betrachten „, noch bevor Sie schießen.“ Zuerst gibt es Gesichtserkennung. Dann fixiert das Telefon die „Orientierungspunkte“ des Gesichts, um zu wissen, wo sich Augen, Mund und andere Merkmale befinden. Schließlich werden das Gesicht und der Rest des Vordergrunds in der Tiefe abgebildet, so dass ein Gesicht aus dem Hintergrund herausspringen kann. All diese Daten stehen App-Entwicklern zur Verfügung, was ein Grund für die Verbreitung von Apps zur Manipulation des Gesichts ist, wie Mug Life, das einzelne Fotos aufnimmt und sie auf Befehl in quasi realistische gefälschte Videos verwandelt.

All diese Arbeit, die vor einem Jahrzehnt unglaublich schwierig war und erst vor kurzem auf Cloud-Servern möglich war, läuft jetzt direkt auf dem Telefon, wie Apple beschrieben hat. Das Unternehmen trainierte ein maschinelles Lernmodell, um Gesichter in einer enormen Anzahl von Bildern zu finden. Das Modell war zu groß, obwohl, so trainierten sie eine kleinere Version auf den Ausgängen des ersten. Dieser Trick machte es möglich, es auf einem Telefon auszuführen. Jedes Foto, das jedes iPhone aufnimmt, ist zu einem kleinen Teil diesen Millionen von Bildern zu verdanken, die zweimal durch ein enormes maschinelles Lernsystem gefiltert wurden.

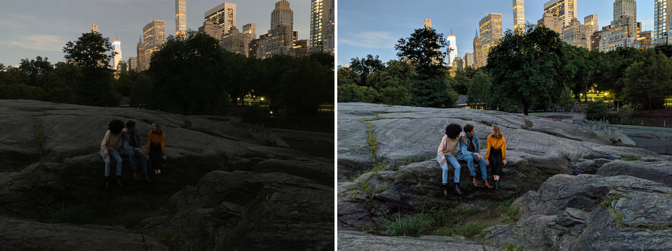

Aber es ist nicht nur so, dass die Kamera weiß, dass es ein Gesicht gibt und wo die Augen sind. Kameras erfassen jetzt auch mehrere Bilder im Moment, um neue zu synthetisieren. Night Sight, eine neue Funktion für das Google Pixel, ist das am besten erklärte Beispiel dafür, wie dies funktioniert. Google hat neue Techniken entwickelt, um mehrere minderwertige (verrauschte, dunkle) Bilder zu einem überlegenen (saubereren, helleren) Bild zu kombinieren. Jedes Foto ist wirklich eine Mischung aus einer Reihe von Fotos, die um die zentrale Belichtung aufgenommen wurden. Aber dann, wie bei Apple, setzt Google Machine-Learning-Algorithmen über diese Bilder. Der, den das Unternehmen öffentlich beschrieben hat, hilft beim Weißabgleich — der dazu beiträgt, realistische Farben in einem Bild zu liefern – bei schlechten Lichtverhältnissen. Es sagte auch The Verge, dass „sein maschinelles Lernen erkennt, welche Objekte sich im Rahmen befinden, und die Kamera ist intelligent genug, um zu wissen, welche Farbe sie haben sollen.“ Überlegen Sie, wie unterschiedlich das von einem normalen Foto ist. Googles Kamera erfasst nicht, was ist, sondern was statistisch wahrscheinlich ist.

Das Fotografieren ist immer automatischer geworden. Es ist wie kommerzielle Piloten, die Flugzeuge fliegen: Sie sind in der manuellen Steuerung für nur einen winzigen Prozentsatz einer bestimmten Reise. Unsere Telefon-Computer-Kameras verwischen nahtlos und unsichtbar die Unterschiede zwischen den Dingen, die eine Kamera tun kann, und den Dingen, die ein Computer tun kann. Es gibt natürlich Kontinuitäten mit bereits vorhandenen Techniken, aber nur, wenn Sie den Fortschritt der digitalen Fotografie auf einer Art logarithmischer Skala darstellen.

High-Dynamic Range- oder HDR-Fotografie wurde in den 2000er Jahren populär und dominierte die frühe Foto-Sharing-Site Flickr. Fotografen haben mehrere (normalerweise drei) Bilder derselben Szene bei unterschiedlichen Belichtungen aufgenommen. Dann stapelten sie die Bilder übereinander und nahmen die Informationen über die Schatten vom hellsten Foto und die Informationen über die Lichter vom dunkelsten Foto. Setzen Sie sie alle zusammen, und sie könnten schöne Surrealität erzeugen. In den richtigen Händen könnte ein HDR-Foto eine Szene erzeugen, die dem, was unsere Augen sehen, viel ähnlicher ist als das, was die meisten Kameras normalerweise produzieren.

Unsere Augen, insbesondere unter Bedingungen variabler Helligkeit, können dies dynamisch kompensieren. Versuchen Sie zum Beispiel, ein Bild des Mondes zu machen. Der Mond selbst ist sehr hell, und wenn Sie versuchen, ein Foto davon zu machen, müssen Sie es belichten, als wäre es Mittag. Aber die Nacht ist offensichtlich dunkel, und um ein detailliertes Bild des Mondes zu erhalten, ist der Rest der Szene im Wesentlichen schwarz. Unsere Augen können problemlos sowohl den Mond als auch die irdische Landschaft sehen.

Google und Apple wollen den HDR-Prozess so automatisch machen wie die Anpassungen unserer Augen. Sie haben HDR in ihre Standardkameras integriert und zeichnen aus einer Reihe von Bildern (Google verwendet bis zu 15). HDR ist einfach geworden, wie Bilder für die meisten Menschen gemacht werden. Wie bei der Hautglättung spielt es keine Rolle mehr, ob unsere Augen das sehen würden. Das Ziel einiger neuer Produkte ist es, die beeindruckenden visuellen Fähigkeiten unseres eigenen Körpers zu übertreffen. „Das Ziel von Night Sight ist es, Fotos von Szenen zu machen, die so dunkel sind, dass man sie mit eigenen Augen nicht klar sehen kann — fast wie eine Superkraft!“ Google schreibt.

Seit dem 19.Jahrhundert sind Kameras in der Lage, Bilder mit unterschiedlichen Geschwindigkeiten, Wellenlängen und Vergrößerungen aufzunehmen, die bisher verborgene Welten enthüllen. Das Faszinierende an den aktuellen Veränderungen in der Telefonfotografie ist, dass es genauso darum geht, zu enthüllen, wie wir aussehen wollen, wie sie Teil der Welt sind. Es ist, als hätten wir eine Sonde entdeckt, um Versionen unserer Gesichter — oder sogar uns selbst — zu finden und zu teilen, und es ist dieser Prozess, der jetzt das Verhalten der innovativsten und profitabelsten Unternehmen der Welt bestimmt.

In der Zwischenzeit können Unternehmen und Regierungen etwas anderes mit Ihrem Gesicht tun: Gesichtserkennungstechnologien entwickeln, die jede Kamera in eine Überwachungsmaschine verwandeln. Google hat sich verpflichtet, kein „Allzweck-Gesichtserkennungsprodukt“ zu verkaufen, bis die ethischen Probleme mit der Technologie gelöst sind, aber Amazon Rekognition ist jetzt verfügbar, ebenso wie Microsofts Face API, ganz zu schweigen von den noch umfangreicheren Bemühungen chinesischer Internetunternehmen.

Die Weltwirtschaft ist mit eurem Gesicht verbunden. Und es ist bereit, Himmel und Erde zu bewegen, damit Sie sehen können, was Sie sehen möchten.