Lorsqu’un YouTuber de premier plan nommé Lewis Hilsenteger (alias « Unbox Therapy ») testait le nouveau modèle d’iPhone de cet automne, le XS, il a remarqué quelque chose: Sa peau était très lisse dans la caméra selfie frontale de l’appareil, en particulier par rapport aux anciens modèles d’iPhone. Hilsenteger l’a comparé à une sorte de maquillage numérique. « Je ne ressemble pas à ça », a-t-il déclaré dans une vidéo démontrant le phénomène. « C’est bizarre I j’ai l’air de porter du fond de teint. »

Il n’est pas le seul à avoir remarqué l’effet, même si Apple n’a pas reconnu qu’il faisait quelque chose de différent qu’auparavant. En tant qu’utilisateur d’iPhone de longue date et photographe amateur, je trouve indéniable que le mode Portrait — une technologie de pointe dans la dernière édition des téléphones les plus populaires au monde — a brillé. Au fil des semaines de prise de photos avec l’appareil, je me suis rendu compte que l’appareil avait franchi un seuil entre la photographie et le fauxtographe. Je n’étais pas tellement en train de « prendre des photos » que le téléphone les synthétisait.

Ce phénomène n’est pas totalement nouveau: chaque appareil photo numérique utilise des algorithmes pour transformer les différentes longueurs d’onde de la lumière qui frappent son capteur en une image réelle. Les gens ont toujours cherché la bonne lumière. À l’ère des smartphones, des applications de Snapchat à FaceApp en passant par Beauty Plus ont proposé de mettre à niveau votre visage. D’autres téléphones ont un défaut – éliminant le « mode beauté », vous pouvez également l’allumer ou l’éteindre. Ce qui rend remarquable le lissage de la peau de l’iPhone XS, c’est qu’il s’agit simplement de la valeur par défaut de l’appareil photo. Prenez un selfie, et c’est ce que vous obtenez.

Ces images ne sont pas fausses, exactement. Mais ce ne sont pas non plus des images telles qu’elles étaient comprises dans les jours précédant la prise de photos avec un ordinateur.

Ce qui a changé, c’est que les caméras en savent trop. Toutes les caméras capturent des informations sur le monde — dans le passé, elles étaient enregistrées par des produits chimiques interagissant avec des photons, et par définition, une photographie était une exposition, courte ou longue, d’un capteur à la lumière. Maintenant, sous le capot, les caméras téléphoniques extraient les informations de plusieurs entrées d’image en une seule sortie d’image, tout en s’appuyant sur des réseaux de neurones formés pour comprendre les scènes sur lesquelles elles sont pointées. En utilisant ces autres informations ainsi qu’une exposition individuelle, l’ordinateur synthétise l’image finale, toujours plus automatiquement et de manière invisible.

Plus d’histoires

Les enjeux peuvent être importants : l’intelligence artificielle permet de synthétiser facilement des vidéos en de nouvelles vidéos fictives souvent appelées « deepfakes ». »Nous vivrons bientôt dans un monde où nos yeux nous trompent régulièrement », a écrit mon collègue Franklin Foer. « Autrement dit, nous ne sommes pas si loin de l’effondrement de la réalité. »Les Deepfakes sont une façon de fondre la réalité; une autre est de changer la simple photographie de téléphone d’une approximation décente de la réalité que nous voyons avec nos yeux à quelque chose de très différent. Il est omniprésent et à basse température, mais pas moins efficace. Et probablement beaucoup plus important pour l’avenir des entreprises technologiques.

Dans Comment voir le monde, le spécialiste des médias Nicholas Mirzoeff appelle la photographie « une façon de voir le monde activée par les machines. »Nous ne parlons pas seulement de l’utilisation des machines, mais de la « société en réseau » dans laquelle elles produisent des images. Et pour Mirzoeff, il n’y a pas de meilleur exemple de la « nouvelle culture mondiale de la jeunesse urbaine en réseau » que le selfie.

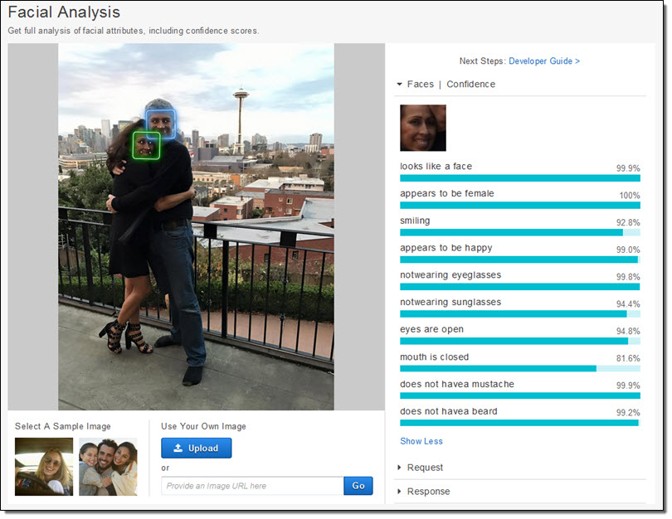

Les fabricants de téléphones et les fabricants d’applications semblent convenir que les selfies sont le moteur de leurs écosystèmes commerciaux. Ils ont consacré d’énormes ressources à la prise de photos de visages. Apple a littéralement créé de nouvelles puces de silicium pour pouvoir, comme le promet l’entreprise, considérer votre visage « avant même de tirer. »D’abord, il y a la détection faciale. Ensuite, le téléphone fixe les « repères » du visage pour savoir où se trouvent les yeux, la bouche et d’autres caractéristiques. Enfin, le visage et le reste du premier plan sont mappés en profondeur, de sorte qu’un visage peut sortir de l’arrière-plan. Toutes ces données sont disponibles pour les développeurs d’applications, ce qui est l’une des raisons de la prolifération d’applications pour manipuler le visage, telles que Mug Life, qui prend des photos uniques et les transforme en fausses vidéos quasi réalistes sur commande.

Tout ce travail, qui était incroyablement difficile il y a dix ans et qui n’était possible que sur des serveurs cloud très récemment, fonctionne désormais directement sur le téléphone, comme l’a décrit Apple. L’entreprise a formé un modèle d’apprentissage automatique pour trouver des visages dans un nombre énorme d’images. Le modèle était trop grand, cependant, ils ont donc entraîné une version plus petite sur les sorties du premier. Cette astuce a rendu possible l’exécution sur un téléphone. Chaque photo prise par chaque iPhone est en partie due à ces millions d’images, filtrées deux fois via un énorme système d’apprentissage automatique.

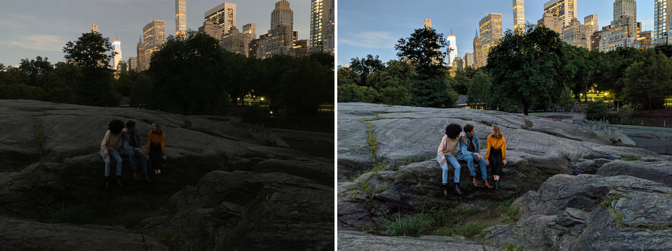

Mais ce n’est pas seulement que la caméra sait qu’il y a un visage et où sont les yeux. Les caméras capturent également plusieurs images dans le moment pour en synthétiser de nouvelles. Night Sight, une nouvelle fonctionnalité pour le Google Pixel, est l’exemple le mieux expliqué de son fonctionnement. Google a développé de nouvelles techniques pour combiner plusieurs images inférieures (bruyantes, sombres) en une image supérieure (plus propre, plus lumineuse). Toute photo est vraiment un mélange d’un tas de photos capturées autour de l’exposition centrale. Mais ensuite, comme avec Apple, Google déploie des algorithmes d’apprentissage automatique au-dessus de ces images. Celui que la société a décrit publiquement aide à l’équilibrage des blancs – ce qui aide à fournir des couleurs réalistes dans une image — en basse lumière. Il a également déclaré à The Verge que « son apprentissage automatique détecte quels objets se trouvent dans le cadre et que la caméra est suffisamment intelligente pour savoir de quelle couleur ils sont censés avoir. »Considérez à quel point cela est différent d’une photographie normale. La caméra de Google ne capture pas ce qui est, mais ce qui, statistiquement, est probable.

La prise de vue est devenue de plus en plus automatique. C’est comme des pilotes commerciaux qui volent des avions: Ils sont en contrôle manuel pour seulement un infime pourcentage d’un trajet donné. Nos caméras téléphone-ordinateur brouillent de manière transparente et invisible les distinctions entre les choses qu’un appareil photo peut faire et les choses qu’un ordinateur peut faire. Il y a des continuités avec des techniques préexistantes, bien sûr, mais seulement si vous tracez les progrès de la photographie numérique sur une sorte d’échelle logarithmique.

La photographie à plage dynamique élevée, ou HDR, est devenue populaire dans les années 2000, dominant le site de partage de photos Flickr. Les photographes ont capturé plusieurs (généralement trois) images de la même scène à différentes expositions. Ensuite, ils ont empilé les images les unes sur les autres et ont pris les informations sur les ombres de la photo la plus brillante et les informations sur les reflets de la photo la plus sombre. Mettez-les tous ensemble, et ils pourraient générer une belle surréalité. Dans les bonnes mains, une photo HDR pourrait créer une scène qui ressemble beaucoup plus à ce que nos yeux voient que ce que la plupart des caméras produisent normalement.

Nos yeux, en particulier dans des conditions de luminosité variable, peuvent compenser dynamiquement. Essayez de prendre une photo de la lune, par exemple. La lune elle-même est très brillante, et si vous essayez de la prendre en photo, vous devez l’exposer comme s’il faisait midi. Mais la nuit est sombre, évidemment, et donc pour avoir une image de la lune avec des détails, le reste de la scène est essentiellement noir. Nos yeux peuvent voir à la fois la lune et le paysage terrestre sans problème.

Google et Apple veulent tous deux rendre le processus HDR aussi automatique que les ajustements de nos yeux. Ils ont intégré le HDR à leurs caméras par défaut, en tirant parti d’une rafale d’images (Google en utilise jusqu’à 15). HDR est devenu simplement la façon dont les photos sont prises pour la plupart des gens. Comme pour le lissage de la peau, cela n’a plus vraiment d’importance si c’est ce que nos yeux verraient. L’objectif de certains nouveaux produits est de surpasser les capacités visuelles impressionnantes de notre propre corps. « Le but de Night Sight est de faire des photos de scènes si sombres que vous ne pouvez pas les voir clairement de vos propres yeux — presque comme un super-pouvoir! » Écrit Google.

Depuis le 19ème siècle, les caméras sont capables de capturer des images à différentes vitesses, longueurs d’onde et grossissements, qui révèlent des mondes auparavant cachés. Ce qui est fascinant dans les changements actuels de la photographie par téléphone, c’est qu’ils consistent autant à révéler à quoi nous voulons ressembler qu’à des enquêtes sur le monde. C’est comme si nous avions découvert une sonde pour trouver et partager des versions de nos visages — ou même de nous—mêmes – et c’est ce processus qui guide désormais le comportement des entreprises les plus innovantes et les plus rentables au monde.

Pendant ce temps, les entreprises et les gouvernements peuvent faire autre chose avec votre visage: créer des technologies de reconnaissance faciale qui transforment n’importe quelle caméra en machine de surveillance. Google s’est engagé à ne pas vendre de produit de « reconnaissance faciale à usage général » tant que les problèmes éthiques liés à la technologie n’auront pas été résolus, mais Amazon Rekognition est maintenant disponible, tout comme l’API Face de Microsoft, pour ne rien dire des efforts encore plus importants des sociétés Internet chinoises.

L’économie mondiale est connectée à votre visage. Et il est prêt à émouvoir le ciel et la Terre pour vous permettre de voir ce que vous voulez voir.